Книга: Думай «почему?». Причина и следствие как ключ к мышлению

Назад: Критерий парадного входа

Дальше: Гобелен, сотканный наукой, или невидимые музыканты Do-оркестра

Математика Do-оператора, или сознание над материей

Главная цель обеих обсужденных выше поправок — вычислить эффект интервенции, P (Y | do (X)), в терминах данных типа Р (Y | X, A, B, Z…), не включающих оператор do. Если нам удастся полностью устранить все do, мы сможем использовать для оценки каузального воздействия наблюдаемые данные, что позволит нам перепрыгнуть со ступени 1 на ступень 2 Лестницы Причинности.

Тот факт, что в приведенных двух случаях мы это сделали (черный ход и парадный вход), немедленно поднимает вопрос, существуют ли другие входы и выходы, через которые устраняются все do. Рассуждая в общем и целом, мы поднимаем вопрос, реально ли решить заранее, допускает данная каузальная модель подобную процедуру устранения или нет. Если да, мы применим эту процедуру и обретем желаемое каузальное воздействие, не пошевелив пальцем для осуществления интервенции. В противном случае мы по крайней мере будем знать, что допущения, встроенные в модель, недостаточны для того, чтобы выявить каузальное воздействие с помощью одних только наблюдений, и, как бы умны мы ни были, нам никуда не деться от постановки интервенционного эксперимента того или иного рода.

Перспектива принятия таких решений на основе чисто математических средств должна показаться заманчивой любому, кто понимает дороговизну и сложность проведения рандомизированных контролируемых исследований даже в тех случаях, когда они возможны с точки зрения физики и законодательства. Я тоже был вдохновлен этой идеей в начале 1990-х, не как экспериментатор, а как ученый в области информатики и заодно философ. Несомненно, одно из самых радостных событий в жизни ученого — обнаружить, что, не выходя из-за своего стола, вы способны определить, что возможно или невозможно в реальном мире — особенно, если решаемая проблема важна для общества, а тех, кто пытался ее решить до вас, она ставила в тупик. Могу себе представить, что нечто подобное испытывал Гиппарх из Никеи, когда обнаружил, что в состоянии вычислить высоту пирамиды по ее тени на земле, не взбираясь на нее. Это была явная победа разума над материей.

В самом деле, используемый мной подход во многом был вдохновлен учеными Древней Греции (включая Гиппарха) и изобретенной ими формальной логикой геометрии. В центре древнегреческой логики — набор аксиом, или самоочевидных истин, допустим: «Между двумя точками можно провести одну и только одну прямую». С помощью этих аксиом древним грекам удалось создать сложные структурированные утверждения — теоремы, истинность которых уже очень далека от очевидной. Возьмем, к примеру, утверждение, что сумма углов треугольника равна 180° (или двум прямым углам) вне зависимости от его размера и формы. Истинность этого утверждения ни в какой мере не очевидна; однако философы-пифагорейцы V века до н. э. сумели доказать его универсальную истинность, используя самоочевидные аксиомы в качестве деталей конструктора.

Если вы постараетесь вспомнить школьные уроки геометрии, хотя бы в первом приближении, вы вспомните, что доказательства теорем всегда состоят из вспомогательных построений: скажем, прямой, параллельной стороне треугольника, отмечающей равенство определенных углов; окружности с радиусом, равным данному сегменту, и т. д. Эти вспомогательные построения рассматриваются как временные математические предложения, которые содержат допущения (или требования), касающиеся свойств изображенных фигур. Каждое новое построение опирается на уже существующие, так же как и на аксиомы и на ранее доказанные теоремы. Например, начертание прямой, параллельной одной из сторон треугольника, определяется пятой аксиомой Евклида, о том, что возможно провести одну и только одну прямую, параллельную данной прямой через точку, не лежащую на этой прямой. Начертание этих вспомогательных конструкций — всего лишь операция механического манипулирования символами: в ходе него предложение, написанное ранее (или ранее начертанное изображение), переписывается в новом формате, если это переписывание допускается аксиомой. Великая заслуга Евклида в том, что он определил минимальный набор из всего пяти аксиом, из которого возможно вывести все остальные истинные утверждения геометрии.

Теперь давайте вернемся к нашему центральному вопросу: в каких случаях модель может заменить эксперимент или когда данные, полученные в результате действия, можно заменить просто наблюдаемыми данными. Вдохновившись геометрами Древней Греции, мы хотели бы свести задачу к манипуляции символами и таким образом свергнуть причинность с Олимпа и сделать ее доступной обычному исследователю.

Для начала перефразируем задачу нахождения воздействия X на Y, используя язык доказательств, аксиом и вспомогательных построений, язык Евклида и Пифагора. Начнем с нашего итогового предложения P (Y | do (X)). Задача будет считаться выполненной, если нам удастся удалить из него do-оператор, оставив только классические выражения для вероятностей, вроде P (Y | X) или P (Y | X, Z, W). Конечно, мы не вправе манипулировать нашим итоговым, целевым выражением так, как нам вздумается; операции должны соответствовать тому, что do (X) означает как физическая интервенция. Таким образом, необходимо провести наше выражение через последовательность законных манипуляций, каждая из которых разрешена аксиомами и допущениями нашей модели. Эти манипуляции будут сохранять значение выражения, которое им подвергается, изменяя только формат, в котором оно записывается.

Пример преобразования, сохраняющего значение, — алгебраическое преобразование, превращающее y = ax+ b в ax = y — b. Отношения между X и Y остаются прежними, меняется только формат.

Мы уже знакомы с некоторыми легитимными преобразованиями do-выражений. Так, правило 1 гласит, что, когда мы наблюдаем переменную W, которая не имеет отношения к Y (возможно, является условной по отношению к другим переменным Z), вероятностное распределение Y не изменится. В главе 3 мы видели, что переменная пожар нерелевантна для состояния переменной тревога, если мы знаем состояние переменной-медиатора (дым). Это утверждение о нерелевантности переводится как символическая манипуляция: P (Y | do (X), Z, W) = P (Y | do (X), Z). Постулированное выше уравнение правомерно, если набор переменных Z блокирует все пути от W к Y после того как мы удалили все стрелки, ведущие к Х. В примере пожар → дым → тревога W = пожар, Z = дым и Y = тревога, а Z блокирует все пути от W к Y (в этом случае у нас нет переменной X).

Следующая легитимная трансформация знакома нам по обсуждению критерия черного хода. Мы знаем, что, если набор переменных Z блокирует все пути черного хода от X к Y, поправка по Z, do (X) эквивалентна see (X).

Следовательно, мы можем написать P (Y | do (X), Z) = P (Y | X, Z), если Z удовлетворяет критериям черного хода. Примем это как правило 2 нашей системы аксиом. Хотя это, вероятно, менее самоочевидное правило, чем правило 1, в простейших случаях это принцип общей причины Ханса Рейхенбаха, измененный таким образом, чтобы мы не путали схождения с конфаундерами. Другими словами, мы говорим, что после того, как введены поправки по достаточному набору переменных, снимающих осложнения, любая оставшаяся корреляция представляет собой истинное каузальное воздействие.

Правило 3 очень простое: оно более-менее сводится к тому, что мы можем убрать do (X) из P (Y | do (X)) в любых случаях, в которых нет каузальных путей от X к Y, т. е. P (Y | do (X)) = P (Y), если нет пути от X к Y, состоящего только из стрелок, направленных вперед. Перефразируем это правило следующим образом: если мы делаем нечто, что не влияет на Y, вероятностное распределение Y не изменяется. Помимо того, что правила 1–3 столь же самоочевидны, как и аксиомы Евклида, их можно также доказать математически, используя наше «бесстрелочное» определение do-оператора и базовые законы вероятности. Обратите внимание, что правила 1 и 2 включают условные вероятности, связанные со вспомогательными переменными Z, отличными от X и Y. Эти переменные допустимо считать контекстом, в котором исчисляется вероятность. Иногда уже само присутствие этого контекста делает преобразования законными. В правиле 3 также могут присутствовать вспомогательные переменные, но я опустил их для простоты.

Отмечу, что у каждого правила имеется простая синтаксическая интерпретация. Правило 1 разрешает добавить или удалить наблюдения. Правило 2 разрешает замену интервенции на наблюдение или наоборот. Правило 3 разрешает добавлять или удалять интервенции. Все эти разрешения действуют при определенных условиях, которые в каждом конкретном случае должны быть подтверждены каузальными диаграммами.

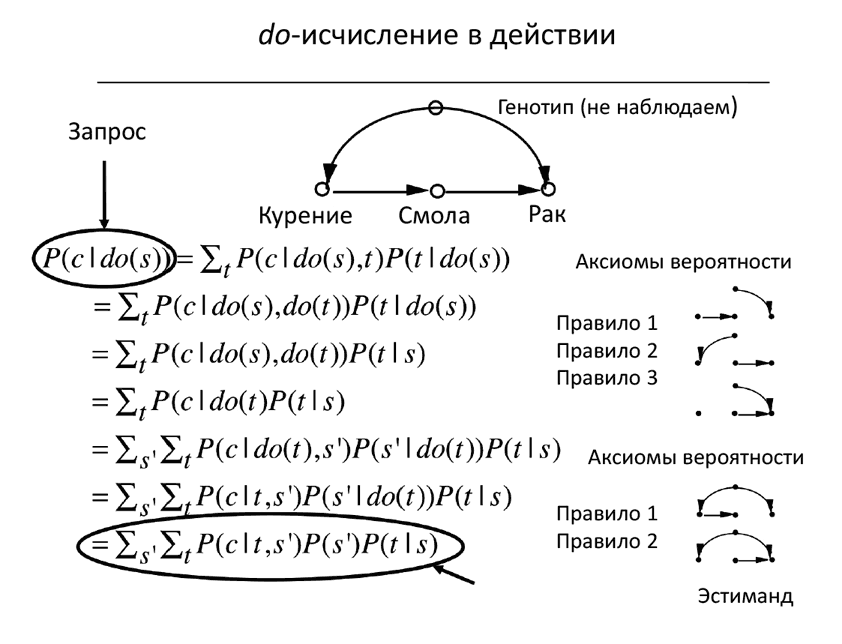

Теперь мы готовы продемонстрировать, как правила 1–3 позволяют нам преобразовывать одну формулу в другую до тех пор, пока (если только мы окажемся достаточно сообразительны) не получим выражение, которое нам нужно. Хотя это займет довольно много места, я думаю, что нужно все-таки наглядно показать вам, как с помощью последовательного применения правил do-исчисления получается формула парадного входа (рис. 44). Вам нет необходимости внимательно следить за каждым шагом, я показываю вам вывод формулы, чтобы вы ощутили вкус do-исчисления.

Наше путешествие начнется с целевого выражения P (Y | do (X)). Мы вводим вспомогательные переменные и трансформируем целевое выражение так, чтобы оно не содержало оператора do и совпадало, конечно, с формулой поправок парадного входа. Каждый наш шаг обосновывается каузальной диаграммой, связывающей X, Y и вспомогательные переменные, или в некоторых случаях субдиаграммами, в которых стерты стрелки, соответствующие интервенциям. Эти обоснования изображаются справа.

К do-исчислению я испытываю особые чувства. С помощью этих трех скромных правил мне удалось вывести формулу парадного входа. Это было первое каузальное воздействие, которое получилось оценить иными средствами, чем поправки по конфаундерам. Я был убежден, что без do-исчисления этого никто не сможет сделать, поэтому представил эту задачу как вызов на семинаре по статистике в Калифорнийском университете в Беркли в 1993 году и даже предложил приз в 100 долларов тому, кто ее решит. Пол Холланд, присутствовавший на семинаре, написал мне, что предложил задачу в качестве проекта своим студентам и пошлет мне решение, когда оно будет готово (коллеги рассказывали мне, что на конференции в 1995 году он таки представил длинное решение, так что, возможно, я должен ему 100 долларов, если найду его доказательство). Экономисты Джеймс Хекман и Родриго Пинто предприняли следующую попытку доказать формулу парадного входа, используя только «стандартные инструменты», в 2015 году. Им это удалось, хотя и ценой восьми страниц сложных выкладок.

В ресторане вечером накануне этой беседы я записал доказательство (очень похожее на то, что приведено на рис. 44) на салфетке для Дэвида Фридмана. Позже он написал мне, что потерял ту салфетку, не может восстановить доказательство, и спросил меня, не сохранилось ли у меня копии. На следующий день Джейми Робинс написал мне из Гарварда, сообщив, что слышал о «задаче на салфетке» от Фридмана и готов вылететь в Калифорнию ближайшим рейсом, чтобы вывести доказательство вместе со мной.

Рис. 44. Вывод формулы поправок парадного входа по правилам do-исчисления

Я был очень рад поделиться с Робинсом секретами do-исчисления и полагаю, что его поездка в Лос-Анджелес в том году сыграла ключевую роль в том, с каким энтузиазмом он воспринял каузальные диаграммы. Благодаря ему и Сандеру Гренланду эти диаграммы стали вторым языком эпидемиологов. Это объясняет, почему я так отношусь к «задаче на салфетке».

Поправка парадного входа была приятным сюрпризом и означала, что do-исчислению есть что предложить людям. Тем не менее в тот момент я еще не знал наверняка, достаточно ли всего трех правил do-исчисления. Не упустили ли мы четвертое правило, которое помогло бы нам решать задачи, неразрешимые с помощью только этих трех?

В 1994 году, когда я впервые предложил общественности do-исчисление, я выбрал эти три правила потому, что они были достаточны во всех известных мне случаях. Я не знал, выведут ли они меня как нить Ариадны из абсолютно любого лабиринта, или когда-нибудь мне попадется лабиринт такой дьявольской сложности, что выбраться из него я не смогу. Конечно, я надеялся на лучшее. Я предполагал, что в тех случаях, когда каузальное воздействие вообще возможно оценить по данному набору данных, последовательность шагов, использующих эти три правила, позволит сократить do-оператор. Но я не в состоянии был это доказать.

У такого типа задач есть множество предшественников в математике и логике. Это свойство в математической логике обычно называют функциональной полнотой. У обладающей полнотой системы аксиом есть следующее свойство: этих аксиом достаточно для выведения любого истинного утверждения данного языка. Некоторые очень хорошие системы аксиом тем не менее не обладают функциональной полнотой: таковы, например, аксиомы Филипа Давида, описывающие условную независимость в теории вероятности.

В этом современном мифе о лабиринте роль Ариадны для моего блуждающего Тезея сыграли две группы исследователей: Имин Хуан и Марко Вальторта из Университета Южной Каролины, а также мой собственный студент Илья Шпицер из Калифорнийского университета в Лос-Анджелесе. Обе группы одновременно и независимо доказали, что правил 1–3 достаточно, для того чтобы выбраться из любого лабиринта, из которого в принципе есть выход. Я не уверен в том, что весь мир, затаив дыхание, ждал доказательства функциональной полноты этих аксиом, потому что большинству исследователей в то время хватало просто критериев черного хода и парадного входа. Тем не менее обе команды получили награды в номинации лучших студенческих работ на конференции «Неопределенность в искусственном интеллекте», проходившей в 2006 году.

Однако признаюсь, что я как раз ждал этого решения, затаив дыхание. Оно сообщает нам, что если мы не в состоянии найти способ оценить вероятность P (Y | do (X)) с помощью правил 1–3, то решения не существует. В этом случае мы знаем, что без рандомизированного контролируемого исследования не обойтись. Оно также говорит нам, какие дополнительные допущения или эксперименты нужны для того, чтобы каузальное воздействие стало возможно оценить.

Перед тем как объявить окончательную победу, нам нужно обсудить одну проблему с do-исчислением. Как и любые вычислительные методы, оно помогает нам выстроить доказательство, но не найти решение. С ним замечательно легко проверить истинность решения, но для поиска решений оно не так хорошо. Если вы знаете правильную последовательность преобразований, легко продемонстрировать другим (знакомым с правилами 1–3), что do-оператор можно сократить. Однако, если правильная последовательность вам неизвестна, не так-то легко обнаружить ее или даже определить, что она вообще существует. Используя аналогию с геометрическими доказательствами, нам надо решить, какие дополнительные построения потребуются нам на следующем шаге. Окружность с центром в точке А? Прямая, параллельная АВ? Число возможностей безгранично, а аксиомы сами по себе не дают намека, что делать дальше. Мой школьный учитель геометрии говорил, что нужно посмотреть на ситуацию через «математические очки».

В математической логике это называется проблемой принятия решений. Многие логические системы страдают от неустранимой проблемы принятия решений. Например, если у нас есть кучка костяшек домино различных размеров, у нас нет определенного способа решить, возможно ли сложить из них квадрат заданного размера. Но когда расклад уже заявлен, очень просто подтвердить, является ли он решением.

К счастью (опять) для do-исчисления, с проблемой принятия решений удалось справиться. Илья Шпицер, основываясь на более ранней работе другого моего студента по имени Цзинь Тянь, нашел алгоритм, который определяет, существует ли решение в «полиномиальном времени». Это до некоторой степени технический термин, но, продолжая нашу аналогию с поиском выхода из лабиринта, это означает, что у нас появляется намного более эффективный способ поиска выхода, чем случайное блуждание по всем доступным путям.

Алгоритм Шпицера для поиска всех каузальных воздействий не устраняет потребности в do-исчислении. На самом деле мы нуждаемся в нем даже больше, и по нескольким независимым причинам. В первую очередь, оно нужно нам для того, чтобы продвинуться дальше исследований, использующих только наблюдения. Допустим, что все складывается наихудшим образом и наша каузальная модель не допускает оценки каузального воздействия P (Y | do (X)) исключительно из данных, полученных в результате наблюдений. Предположим, что мы также не в состоянии провести рандомизированное контролируемое исследование со случайно назначаемыми X. Сообразительный исследователь спросит, удастся ли нам тогда оценить P (Y | do (X)), рандомизируя какую-либо другую переменную, скажем Z, которая лучше поддается контролю, чем X.

Например, если мы хотим узнать воздействие уровня холестерина (X) на сердечно-сосудистые заболевания (Y), мы можем манипулировать диетой испытуемых (Z) вместо того, чтобы пытаться прямо контролировать уровень холестерина у них в крови. Таким образом, мы задаемся вопросом, реально ли найти такую суррогатную переменную Z, которая позволит получить ответ на вопрос о причинах. На языке do-исчисления вопрос звучит так: возможно ли найти такое Z, чтобы преобразовать P (Y | do (X)) в выражение, в котором Z, а не X подвергается do-оператору. Это совершенно отдельная задача, не подпадающая под алгоритм Шпицера. К счастью, для нее тоже есть полный ответ — новый алгоритм, открытый Элиасом Баренбоймом в моей лаборатории в 2012 году.

Еще больше подобных задач возникает, когда мы рассматриваем проблемы транспортабельности или внешней валидности данных, выясняя, будет ли экспериментальный результат сохранять валидность в других условиях, отличающихся от изученных по нескольким ключевым параметрам. Этот более амбициозный набор вопросов бьет уже в самое сердце научной методологии, потому что наука не существует без обобщений. Однако вопрос обобщения не двигался с места по крайней мере два столетия. Инструментов для нахождения решения попросту не было.

В 2015 году Баренбойм и я представили в Национальную академию наук публикацию, в которой проблема решается в случае, если вы можете выразить свои допущения относительно двух сред с помощью каузальных диаграмм. В этих случаях правила do-исчисления обеспечивают систематический подход к определению того, насколько каузальные воздействия, определенные в опытных условиях, помогут нам оценить воздействия в интересующих нас целевых условиях.

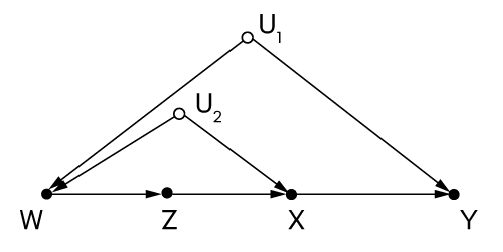

Еще одна причина, по которой do-исчисление остается необходимым, — это прозрачность. Когда я писал эту главу, Баренбойм (ныне профессор в Университете Пердью) прислал мне новую головоломку — диаграмму, в которой всего четыре наблюдаемые переменные: X, Y, Z и W — и две ненаблюдаемые: U1 и U2 (рис. 45). Он предложил мне определить, возможно ли оценить воздействие X на Y в этом случае. Здесь невозможно заблокировать пути черного хода и не выполняются условия для парадного входа. Я испробовал все свои любимые подходы и ранее выручавшие меня интуитивные аргументы, как за, так и против, и все же я не мог понять, как это сделать. Я не мог найти выхода из лабиринта. Но как только Баренбойм шепнул мне: «Попробуй do-исчисление!», ответ немедленно засиял во всей непосредственной простоте. Каждый шаг стал ясен и наполнен смыслом. Теперь это самая простая из известных нам моделей, в котором каузальное воздействие приходится оценивать методом, выходящим за рамки поправок черного хода и парадного входа.

Чтобы не оставлять читателя под впечатлением, что do-исчисление хорошо только для теории и для решения головоломок на досуге, я закончу эту секцию практической задачей, которую поставили недавно два ведущих статистика Нэнни Вермут и Дэвид Кокс. Она показывает, как дружеская подсказка «Попробуй do-исчисление» может помочь экспертам в области статистики решать сложнейшие практические задачи.

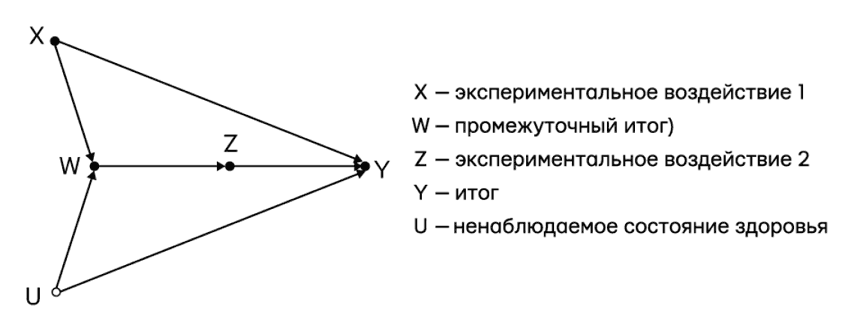

Приблизительно в 2005 году Вермут и Кокс заинтересовались так называемой проблемой последовательных решений, или курса лечения, меняющегося во времени, с которой часто приходится сталкиваться, например, при лечении СПИДа. В этом случае типично, что лечение проводится продолжительное время, и в каждый период времени врачи изменяют силу и дозировку медикаментозных средств в последующих назначениях, исходя из состояния здоровья пациента. В свою очередь, на состояние здоровья пациента влияет лечение, назначенное ему в прошлом.

Рис. 45. Новая «задача на салфетке»?

Таким образом, в итоге у нас получается сценарий вроде того, что изображен на рис. 46, где показаны два отрезка времени и два назначения врача. Первое назначение (X) рандомизировано, а второе (Z) назначается в ответ на наблюдение (W), которое зависит от X. Задача Кокса и Вермут состояла в том, чтобы из данных, полученных в таком режиме лечения, предсказать воздействие Х на исход Y, предполагая, что Z остается постоянным во времени вне зависимости от наблюдений W.

Рис. 46. Пример меняющегося во времени курса лечения, по Вермут и Коксу

Джейми Робинс впервые обратил мое внимание на проблему меняющегося во времени курса лечения в 1994 году, и с помощью do-исчисления мы получили общее решение, включающее серийную версию формулы поправок черного хода. Вермут и Кокс, не зная об этом методе, назвали свою проблему «непрямое осложнение» и опубликовали три работы, посвященные ее анализу (2008, 2014 и 2015). Не сумев решить ее в общем виде, они прибегли к линейной аппроксимации, но даже в линейном виде решение показалось им сложным и неудобным, потому что стандартными методами регрессии решить эту задачу нельзя.

К счастью, когда муза шепнула мне в ухо «Попробуй do-исчисление», я заметил, что их задача решается в три строчки вычислений. Логика решения такова. Нам нужно вычислить P (Y | do (X), do (Z)), в то время как нам доступны данные в виде P (Y | do (X), Z, W) и P (W | do (X)). Это отражает тот факт, что в исследовании, откуда получены наши данные, Z не контролируется извне, а следует за W согласно некоему (неизвестному) протоколу. Таким образом, наша задача — преобразовать искомое выражение в другое выражение, отражающее условия исследования, при которых do-оператор применяется только к X, но не к Z. Оказывается, что одно только применение трех правил do-исчисления позволяет этого добиться. В этой истории нет никакой морали, кроме глубокого почтения к возможностям математики по решению сложнейших задач, иногда влекущих за собой практические последствия.

Назад: Критерий парадного входа

Дальше: Гобелен, сотканный наукой, или невидимые музыканты Do-оркестра