Заключение

Сила

Искусственный интеллект не является объективной, универсальной или нейтральной вычислительной техникой, которая принимает решения без участия человека. Его системы встроены в социальный, политический, культурный и экономический мир, формируются людьми, институтами и императивами, определяющими то, что они делают и как они это делают. Они предназначены для дискриминации, усиления иерархии и кодирования узких классификаций. Применяясь в таких социальных контекстах, как полиция, судебная система, здравоохранение и образование, они могут воспроизводить, оптимизировать и усиливать существующее структурное неравенство. Это не случайно: Системы ИИ создаются для того, чтобы видеть мир и вмешиваться в него таким образом, чтобы это было выгодно в первую очередь государствам, институтам и корпорациям, которым они служат. В этом смысле системы ИИ являются выражением власти, возникающей из более широких экономических и политических сил, созданных для увеличения прибыли и централизации контроля для тех, кто ими владеет. Но история искусственного интеллекта обычно рассказывается не так.

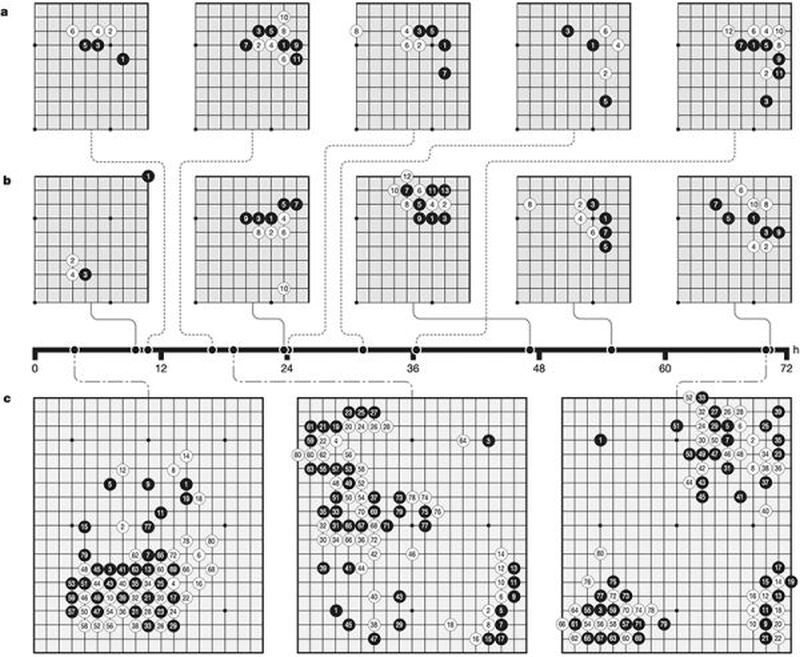

Стандартные описания ИИ часто основываются на своего рода алгоритмической исключительности – идее о том, что, поскольку системы ИИ способны совершать невероятные вычислительные подвиги, они должны быть умнее и объективнее, чем их несовершенные человеческие создатели. Рассмотрим диаграмму AlphaGo Zero, программу ИИ, разработанную DeepMind компании Google для стратегических игр. Изображение показывает, как она «научилась» играть в китайскую стратегическую игру Го, оценивая более тысячи вариантов каждого хода.

AlphaGo Zero. Предоставлено компанией DeepMind

В статье, повествующей об этой разработке, авторы пишут: «Начав с tabula rasa, наша новая программа AlphaGo Zero достигла сверхчеловеческой производительности». Соучредитель DeepMind Демис Хассабис описал игровые движки как подобие инопланетного интеллекта. «Он не играет как человек, но и не играет как компьютерный механизм. Он играет третьим, почти инопланетным способом… Это как шахматы из другого измерения». Когда следующая итерация освоила игру Го за три дня, Хассабис описал это как «открытие заново трех тысяч лет человеческих знаний за 72 часа!»

На диаграмме Го нет ни машин, ни людей, ни капиталовложений, ни углеродного следа, только абстрактная система, основанная на правилах, наделенная потусторонними способностями. Рассказы о магии и мистификации повторяются на протяжении всей истории ИИ, рисуя яркие круги вокруг впечатляющих демонстраций скорости, эффективности и вычислительного мышления. Не случайно одним из знаковых примеров современного ИИ является игра.

Игры без границ

С 1950-х годов игры являются предпочтительным полигоном для тестирования программ ИИ. В отличие от повседневной жизни, игры предлагают закрытый мир с определенными параметрами и четкими условиями победы. Исторические корни ИИ уходят во Вторую мировую войну и берут начало в финансируемых военными исследованиях в области обработки сигналов и оптимизации, которые стремились упростить мир, сделав его более похожим на стратегическую игру. Появился сильный акцент на рационализации и прогнозировании, а также вера в то, что математические формализмы помогут нам понять человека и общество. Вера в то, что точное прогнозирование в основном заключается в уменьшении сложности мира, породила неявную теорию социального: найти сигнал в шуме и создать порядок из беспорядка.

Такое эпистемологическое сглаживание сложности в чистый сигнал с целью предсказаний в настоящее время является центральной логикой машинного обучения. Мы с историком технологий Алексом Камполо называем это заколдованным детерминизмом: Системы ИИ рассматриваются как заколдованные, находящиеся за пределами известного мира, но при этом детерминированные, поскольку они обнаруживают закономерности, которые можно с предсказательной уверенностью применять в повседневной жизни. При обсуждении систем глубокого обучения, где машинные методы расширяются путем наслаивания друг на друга абстрактных представлений данных, заколдованный детерминизм приобретает почти теологическое качество. То, что подходы глубокого обучения часто не поддаются интерпретации даже для инженеров, которые их создали, придает этим системам сложную и мощную ауру. Как заметил социальный антрополог Ф. Г. Бейли, техника «затушевывания путем мистификации» зачастую используется в публичной среде, чтобы доказать неизбежность того или иного явления. Нам предлагают сосредоточиться на инновационном характере метода, а не на том, что является главным: назначении самой вещи. Прежде всего, зачарованный детерминизм затуманивает власть и закрывает возможность для информированного общественного обсуждения, критического анализа или откровенного неприятия.

Зачарованный детерминизм имеет два доминирующих направления, каждое из которых является зеркальным отражением другого. Одно из них – это утопизм, который предлагает вычислительные вмешательства как универсальные решения, применимые к любой проблеме. Другое – антиутопическая перспектива, обвиняющая алгоритмы в негативных результатах, как будто они являются независимыми агентами, без учета контекста. В крайнем случае, антиутопическое повествование о технологиях заканчивается сингулярностью, или сверхразумом – теорией о том, что может появиться машинный интеллект, который в конечном итоге будет доминировать над людьми или их уничтожит. Этот взгляд редко сопоставляется с реальностью: по всему миру люди уже доминируют в системах добывающих планетарных вычислений.

Оба дискурса – антиутопический и утопический – являются метафизическими близнецами: один возлагает надежды на ИИ как на решение всех проблем, а другой боится ИИ как величайшей опасности. Каждый из них предлагает глубоко аисторический взгляд, который определяет власть исключительно в рамках самой технологии. Независимо от того, рассматривается ли ИИ как универсальный инструмент или как всемогущий повелитель, результатом является технологический детерминизм. ИИ занимает центральное место в искуплении или разрушении общества, позволяя нам игнорировать системные силы неолиберализма, политики жесткой экономии, расового неравенства и широко распространенной трудовой эксплуатации. И утописты, и антиутописты ставят проблему так, что технология всегда находится в центре, неизбежно распространяясь на все сферы жизни, в отрыве от форм власти, которые она усиливает и обслуживает.

Когда AlphaGo побеждает человеческого гроссмейстера, очень заманчиво представить, что появился некий потусторонний интеллект. Но есть гораздо более простое и точное объяснение. Игровые движки ИИ предназначены для того, чтобы играть миллионы партий, проводить статистический анализ для оптимизации выигрышных результатов, а затем играть еще миллионы партий. Эти программы производят удивительные ходы, не встречающиеся в человеческих играх, по простой причине: они могут играть и анализировать гораздо больше игр с гораздо большей скоростью, чем это может сделать любой человек. Это не магия, это статистический анализ в масштабе. Тем не менее рассказы о сверхъестественном машинном интеллекте не прекращаются. Снова и снова мы сталкиваемся с идеологией картезианского дуализма в ИИ: фантазией о том, что системы ИИ – это развоплощенные мозги, которые поглощают и производят знания независимо от своих создателей, инфраструктур и мира в целом. Эти иллюзии отвлекают от гораздо более важных вопросов: Кому служат системы? Какова политическая экономика их создания? И каковы более широкие планетарные последствия?

Инженерные системы ИИ

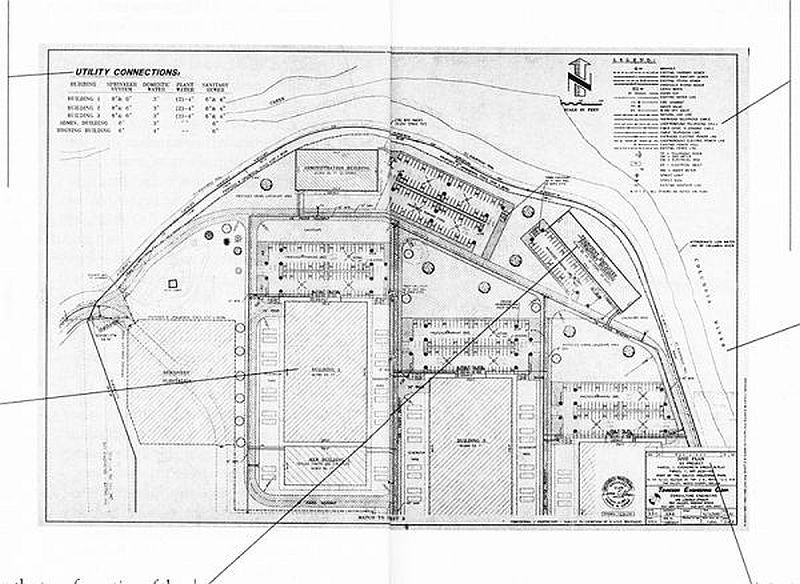

Рассмотрим другую иллюстрацию ИИ: чертеж первого собственного и управляемого центра обработки данных компании Google в городе Даллес, штат Орегон. На нем изображены три здания площадью 68680 квадратных футов, огромный объект, который, по оценкам 2008 года, потребляет достаточно энергии для питания восьмидесяти двух тысяч домов или города размером с Такому, штат Вашингтон. Сейчас дата-центр раскинулся вдоль берега реки Колумбия, где он в значительной степени использует энергию.

Лоббисты Google в течение шести месяцев вели переговоры с местными чиновниками, чтобы добиться сделки, включающей налоговые льготы, гарантии дешевой энергии и использование построенного городом оптоволоконного кольца. В отличие от абстрактного видения игры Го, инженерный план показывает, насколько сильно техническое видение Google зависит от коммунальных служб, включая газовые магистрали, канализационные трубы и высоковольтные линии, по которым будет поступать электричество со скидкой. По словам писательницы Джинджер Стрэнд, «благодаря городской инфраструктуре, государственным субсидиям и субсидируемой федеральным правительством электроэнергии, YouTube финансируется нами».

Чертеж центра обработки данных Google. Предоставлено изданием Harper’s

Этот план напоминает, насколько сильно расширение индустрии искусственного интеллекта субсидировалось государством: от финансирования обороны и федеральных исследовательских агентств до коммунальных услуг и налоговых льгот, до данных и неоплачиваемого труда всех, кто пользуется поисковыми системами или размещает изображения в Интернете. ИИ начинался как крупный общественный проект двадцатого века и был неустанно приватизирован, чтобы принести огромную финансовую выгоду крошечному меньшинству на вершине пирамиды добычи.

Диаграммы представляют два разных способа понимания работы ИИ. Я утверждала, что многое зависит от того, как мы определяем ИИ, каковы его границы и кто их определяет: именно это и формирует картину видимости и спорных вопросов. Диаграмма Go говорит об отраслевых нарративах абстрактного вычислительного облака, далекого от земных ресурсов, необходимых для его производства, парадигме, где технические инновации превозносятся, регулирование отвергается, а истинные затраты никогда не раскрываются. Чертеж указывает нам на физическую инфраструктуру, но оставляет без внимания все экологические последствия и политические сделки. Частичные описания ИИ представляют то, что философы Майкл Хардт и Антонио Негри называют «двойной операцией абстрагирования и извлечения» в информационном капитализме: абстрагирование от материальных условий производства при извлечении большего количества информации и ресурсов. Описание ИИ как фундаментально абстрактного отделяет его от энергии, труда и капитала, необходимых для его производства, а также от множества различных видов добычи, которые позволяют это сделать.

В этой книге исследуется планетарная инфраструктура ИИ как добывающей промышленности: от его материального генезиса, политэкономии его операций до дискурсов, поддерживающих ауру нематериальности и неизбежности. Мы наблюдали политику, заложенную в процессе обучения систем ИИ распознаванию мира. И мы наблюдали системные формы неравенства, которые делают ИИ тем, чем он сегодня является. Основная проблема заключается в глубоком переплетении технологий, капитала и власти, последним проявлением которого является ИИ. Вместо того чтобы оставаться непостижимыми и чуждыми, эти системы служат продуктами более крупных социальных и экономических структур с глубокими материальными последствиями.

Карта – это не территория

Как увидеть полный жизненный цикл искусственного интеллекта и динамику власти, которая им управляет? Чтобы рассмотреть его в более широком ландшафте, придется выйти за рамки обычных карт. В этой книге говорится о том, что реальная ставка ИИ – это глобальные взаимосвязанные системы добычи и власти, а не технократические фантазии об искусственности, абстракции и автоматизации. Чтобы понять ИИ таким, какой он есть, прежде всего необходимо увидеть структуры власти, которым он служит.

ИИ рождается из соляных озер в Боливии и шахт в Конго, создается из помеченных толпой данных, которые пытаются классифицировать человеческие действия, эмоции и личности. Он используется для навигации беспилотников над Йеменом, управления иммиграционной полицией в Соединенных Штатах и изменения рейтинга человеческой ценности и риска по всему миру. Для борьбы с этими пересекающимися режимами необходим широкий угол зрения на ИИ.

Начало книги зародилось под землей, где добывающая политика искусственного интеллекта проявляется в самом буквальном смысле. Редкоземельные минералы, вода, уголь и нефть: технологический сектор добывает землю, чтобы обеспечить топливом свои высокоэнергоемкие инфраструктуры. Технологический сектор, который одновременно расширяет сети центров обработки данных и помогает нефтегазовой промышленности находить и выкачивать оставшиеся запасы ископаемого топлива, никогда полностью не признает и не учитывает углеродный след ИИ. Непрозрачность более крупной цепочки поставок вычислительной техники в целом и ИИ в частности является частью давно сложившейся бизнес-модели извлечения ценности из общего достояния и избегания возмещения долговременного ущерба.

Труд представляет собой еще одну форму добычи. Во второй главе мы вышли за рамки высокооплачиваемых инженеров машинного обучения и рассмотрели другие формы труда, необходимые для функционирования систем искусственного интеллекта. От шахтеров, добывающих олово в Индонезии, до краудворкеров в Индии, выполняющих задания на Amazon Mechanical Turk, до рабочих завода по производству iPhone на Foxconn в Китае – рабочая сила ИИ гораздо больше, чем мы обычно себе представляем. Даже в самих технологических компаниях существует большая теневая отрасль, состоящая из контрактных рабочих, которых значительно больше, чем штатных сотрудников, но у них меньше льгот и нет гарантий занятости.

В логистических узлах технологического сектора мы видим людей, выполняющих задачи, которые не под силу машинам. Тысячи людей необходимы для поддержания иллюзии автоматизации: пометки, исправления, оценка и редактирование систем искусственного интеллекта, чтобы они выглядели бесшовными. Другие поднимают посылки, доставляют еду. Системы искусственного интеллекта следят за всеми ними, выжимают максимум производительности из голой функциональности человеческого тела: сложные суставы пальцев, глаз и коленных суставов дешевле и проще приобрести, чем роботов. В этих пространствах будущее работы больше похоже на фабрики прошлого, но с браслетами, вибрирующими при ошибках, и штрафами за слишком частые перерывы на туалет.

Использование искусственного интеллекта на рабочем месте еще больше нарушает баланс власти, передавая все больше контроля в руки работодателей. Приложения используются для отслеживания работников, подталкивания их к более продолжительной работе и ранжирования в режиме реального времени. Amazon представляет собой канонический пример того, как микрофизика власти связана с макрофизикой, логистикой планетарного времени и информации. Системы искусственного интеллекта используют различия во времени и заработной плате на разных рынках, чтобы ускорить движение капитала. Внезапно каждый житель городских центров уже может получить – и ожидает – доставку в день заказа. И система снова ускоряется, а материальные последствия скрываются за картонными коробками, грузовиками и кнопками «купить сейчас».

На уровне данных мы видим другую географию добычи. «Мы создаем зеркало реального мира, – сказал в 2012 году инженер Google Street View. – Все, что вы видите в реальном мире, должно попасть в наши базы данных». С тех пор добыча информации из реального мира только усилилась, чтобы проникнуть в пространства, которые раньше было трудно охватить. Как мы увидели в третьей главе, разграбление общественных мест широко распространено; лица людей снимаются для обучения систем распознавания лиц; ленты социальных сетей поглощаются для построения предиктивных моделей языка; сайты, где люди хранят личные фотографии или ведут онлайн-дебаты, обшариваются для обучения машинного зрения и алгоритмов естественного языка. Эта практика стала настолько распространенной, что мало кто из специалистов в области ИИ даже задается этим вопросом. Отчасти все объясняется тем, что от ИИ зависит много карьер и рыночных оценок. Менталитет «забрать все, что можно», который некогда являлся уделом разведывательных служб, не только нормализовался, но и морализировался – считается, что не собирать данные везде, где это возможно, – это расточительство.

Как только данные извлекаются и упорядочиваются в обучающие наборы, они становятся эпистемической основой, с помощью которой системы ИИ классифицируют мир. Из эталонных обучающих групп, таких как ImageNet, MS-Celeb или коллекции NIST, изображения используются для представления идей, гораздо более реляционных и спорных, чем можно предположить по их обозначениям. В четвертой главе мы рассмотрели, как таксономии ярлыков распределяют людей по принудительным гендерным бинарам, упрощенным и оскорбительным расовым группам и весьма нормативным и стереотипным анализам характера, достоинств и эмоционального состояния. Эти классификации, неизбежно нагруженные ценностями, навязывают свой способ видения мира, претендуя при этом на научную нейтральность.

База данных в ИИ никогда не служит сырьем для алгоритмов: это по своей сути политические интервенции. Вся практика сбора данных, их категоризации и маркировки, а затем использования для обучения систем является формой политики. Она привела к переходу к так называемым оперативным образам – представлениям мира, созданным исключительно для машин. Предвзятость – это симптом более глубокого заболевания: далеко идущей и централизованной нормативной логики, которая используется для определения того, как следует видеть и оценивать мир.

Центральным примером здесь служит детекция аффектов, описанная в пятой главе, которая опирается на спорные идеи о связи лиц с эмоциями и применяет их с редуктивной логикой теста на детекторе лжи. Эта наука остается глубоко спорной. Институты всегда классифицировали людей по категориям идентичности, сужая личность и разбивая ее на точно измеренные ячейки. Машинное обучение позволяет достичь широких масштабов. От горных городов Папуа-Новой Гвинеи до военных лабораторий в Мэриленде были разработаны методы, позволяющие свести беспорядочные чувства, внутренние состояния, предпочтения и идентификацию к чему-то количественному, обнаруживаемому и отслеживаемому.

Какое эпистемологическое насилие необходимо для того, чтобы сделать мир читаемым системой машинного обучения? ИИ стремится систематизировать несистематизируемое, формализовать социальное и преобразовать бесконечно сложную и изменяющуюся вселенную в Линнеевскую систему таблиц, читаемых машиной. Многие достижения ИИ зависели от того, чтобы свести понятия к краткому набору формализмов, основанных на косвенных признаках: выявить и назвать некоторые характеристики, игнорируя или затушевывая бесчисленные другие. Говоря словами философа Бабетты Бабич, машинное обучение использует то, что оно знает, чтобы предсказать то, чего оно не знает: игра в повторяющиеся приближения. Наборы данных также являются прокси-стандартами того, что они, как утверждается, измеряют. Проще говоря, это преобразование различий в вычисляемое подобие. Такая схема знания напоминает то, что Фридрих Ницше назвал «фальсификацией многообразного и неисчислимого в идентичное, похожее и исчислимое» Системы ИИ становятся детерминированными, когда косвенные признаки принимаются за базовую истину, когда фиксированные ярлыки применяются к изменчивой сложности. Мы наблюдали подобное в случае попыток ИИ предсказывать пол, расу или ориентацию по фотографии лица. Эти подходы напоминают френологию и физиогномику в их стремлении эссенциализировать и навязать идентичность на основе внешнего облика.

Проблема достоверности данных, собираемых для систем ИИ, обостряется в контексте государственной власти, как мы увидели в шестой главе. Спецслужбы возглавили массовый сбор информации, где сигнатуры метаданных достаточно для смертоносных ударов беспилотников, а местоположение мобильного телефона становится косвенным признаком неизвестной цели. Даже здесь бескровный язык метаданных прямо противоречит непреднамеренным убийствам от ракет беспилотников. Как спросила Люси Сачман: «Как определяются „объекты“, представляющие угрозу? Мы знаем, что „пикап ИГИЛ“ – это категория, основанная на помеченных вручную данных, но кто выбирает категории и идентифицирует автомобили?» Мы видели эпистемологическую путаницу и ошибки обучающих наборов распознавания объектов, таких как ImageNet; военные системы ИИ и атаки беспилотников построены на той же нестабильной почве.

Глубокая взаимосвязь между технологическим сектором и военным ведомством стала обрамляться сильной националистической повесткой дня. Риторика о войне ИИ между США и Китаем стимулирует интересы крупнейших технологических компаний работать при большей государственной поддержке и минимальных ограничениях. Между тем, арсенал средств наблюдения, используемый такими агентствами, как АНБ и ЦРУ, теперь развертывается внутри страны на муниципальном уровне в промежуточном пространстве коммерческого и военного подряда такими компаниями, как Palantir. За нелегальными иммигрантами охотятся с помощью логистических систем тотального контроля и захвата информации, которые раньше были предназначены только для внелегального шпионажа. Системы принятия решений по социальному обеспечению используются для отслеживания аномальных моделей данных, чтобы лишить людей пособия по безработице и обвинить их в мошенничестве. Технология считывания номерных знаков применяется в системах домашнего наблюдения – широко распространенная интеграция ранее отдельных сетей наблюдения.

В результате началось глубокое и быстрое расширение системы наблюдения и размывание границ между частными подрядчиками, правоохранительными органами и технологическим сектором, подпитываемое откатами и тайными сделками. Это радикальная перекройка гражданской жизни, где центры власти укрепляются с помощью инструментов, согласующихся с логикой капитала, охраны правопорядка и милитаризации.

На пути к объединенным движениям за справедливость

Если ИИ в настоящее время служит существующим структурам власти, то очевидным вопросом может быть следующий: а не должны ли мы стремиться к его демократизации? Разве не может существовать ИИ для людей, переориентированный на справедливость и равенство, а не на промышленную добычу и дискриминацию? Это может показаться привлекательным, но, как мы видели на протяжении всей этой книги, инфраструктуры и формы власти, которые обеспечивают и поддерживают ИИ, сильно перекошены в сторону централизации контроля. Предлагать демократизацию ИИ для уменьшения асимметрии власти – это все равно, что призывать к демократизации производства оружия во имя мира. Как напоминает нам Одре Лорд, инструменты хозяина никогда не разрушат свой же дом.

В технологическом секторе наступает время расплаты. На сегодняшний день общим ответом отрасли является подписание принципов этики ИИ. Как отметила парламентарий Европейского союза Мариетье Шааке, в 2019 году только в Европе было разработано 128 рамочных документов по этике ИИ. Эти документы часто представляются как продукты «широкого консенсуса», однако в подавляющем большинстве они подготовлены экономически развитыми странами, в них практически не представлены страны Африки, Южной и Центральной Америки или Центральной Азии. Голоса людей, которым системы ИИ причиняют наибольший вред, в значительной степени отсутствуют в процессах их создания. Кроме того, в этических принципах и заявлениях не обсуждается, как они должны быть реализованы, и редко подлежат исполнению или подотчетны общественности. Как отметила Шеннон Маттерн, в центре внимания чаще всего оказываются этические цели ИИ, без оценки этических средств его применения. В отличие от медицины или права, у ИИ нет официальной структуры профессионального управления или норм – нет согласованных определений и целей для этой области или стандартных протоколов для обеспечения этической практики.

Саморегулирующиеся этические рамки позволяют компаниям выбирать, как внедрять технологии, и, соответственно, решать, что означает этичный ИИ для остального мира. Технологические компании редко подвергаются серьезным финансовым санкциям, когда их системы ИИ нарушают закон, и еще меньше последствий, когда нарушаются их этические принципы. Кроме того, на публичные компании оказывают давление акционеры, требуя максимизации прибыли от инвестиций, а не этических соображений, что обычно делает мораль вторичной по отношению к прибыли. В результате этика является необходимым, но недостаточным условием для решения фундаментальных проблем, поднятых в этой книге.

Чтобы понять, что именно поставлено на карту, мы должны сосредоточиться не столько на этике, сколько на власти. ИИ неизменно предназначен для усиления и воспроизводства тех форм власти, для оптимизации которых он был создан. Противодействие этому требует сосредоточения интересов наиболее затронутых сообществ. Вместо того чтобы превозносить основателей компаний, венчурных капиталистов и технических провидцев, мы должны начать с живого опыта тех, кто лишен прав, подвергается дискриминации и страдает от систем ИИ. Когда кто-то говорит «этика ИИ», нам следует оценить условия труда шахтеров, подрядчиков и краудворкеров. Когда мы слышим «оптимизация», нам стоит спросить, не являются ли они инструментами для бесчеловечного обращения с иммигрантами. Когда мы аплодируем «крупномасштабной автоматизации», нам следует вспомнить о том, что в результате этого будет выброшен углекислый газ в то время, когда планета и так находится в состоянии крайнего стресса. Что значит работать над справедливостью во всех этих системах?

В 1986 году политический теоретик Лэнгдон Виннер описал общество, «приверженное созданию искусственных реальностей», не заботясь о последующем вреде условиям жизни: «Огромные преобразования в структуре нашего общего мира предприняты с минимальным вниманием к тому, что эти изменения означают… В технической сфере мы постоянно заключаем ряд социальных контрактов, условия которых становятся известны только после подписания».

За четыре десятилетия, прошедшие с тех пор, эти преобразования достигли таких масштабов, что изменили химический состав атмосферы, температуру поверхности Земли и содержание коры планеты. Разрыв между тем, как оценивают технологию при ее выпуске, и ее долгосрочными последствиями только увеличился. Общественный договор, в той мере, в какой он вообще когда-либо существовал, привел к климатическому кризису, стремительному росту неравенства богатства, расовой дискриминации, повсеместной слежке и трудовой эксплуатации. Но идея о том, что эти преобразования происходили в неведении относительно их возможных результатов, является частью проблемы. Философ Акилле Мбембе резко критикует идею о том, что мы не могли предвидеть последствия развития систем знаний двадцать первого века, поскольку они всегда являлись «операциями абстракции, претендующими на рационализацию мира на основе корпоративной логики». Он пишет: «Речь идет об извлечении, захвате, культе данных, коммерциализации человеческой способности мыслить и отказе от критического разума в пользу программирования. Сейчас, как никогда раньше, нам нужна новая критика технологии, опыта технической жизни».

Следующая эра критики потребует поиска пространства за пределами технической жизни, преодолевая догму о неизбежности. Когда стремительное развитие ИИ воспринимается как неостановимое, можно только латать юридические и технические ограничения на системы постфактум: очищать базы данных, укреплять законы о конфиденциальности или создавать советы по этике. Но это всегда будут частичные и неполные ответы, в которых технология предполагается, а все остальное должно адаптироваться. Но что произойдет, если мы изменим эту полярность и начнем с обязательств по созданию более справедливого и устойчивого мира? Как мы можем вмешаться в решение взаимозависимых проблем социальной, экономической и климатической несправедливости? Где технологии могут в этом помочь? И есть ли места, где ИИ не следует использовать, где он подрывает справедливость?

Именно это является основой для обновленной политики отказа – противостояния нарративам технологической неизбежности, в которых говорится: «Раз это возможно сделать, значит, так и будет». Вместо того чтобы спрашивать, где будет применяться искусственный интеллект – просто потому, что он может, – акцент следует сделать на том, почему он должен применяться. Зачем его использовать? Таким образом мы сможем поставить под сомнение идею о том, что все должно подчиняться логике статистического прогнозирования и накопления прибыли, что Донна Харауэй называет «информатикой господства». Мы видим проблески отказа, когда население решает отменить предиктивную полицию, запретить распознавание лиц или протестует против алгоритмических оценок. Пока что эти незначительные победы носят фрагментарный и локализованный характер и часто сосредоточены в городах с большими ресурсами для организации, таких как Лондон, Сан-Франциско, Гонконг и Портленд, штат Орегон. Они указывают на необходимость более широких национальных и международных движений, которые отказываются от подходов, основанных на использовании технологий, и фокусируются на решении основных проблем неравенства и несправедливости. Отказ включает в себя неприятие идеи о том, что те же инструменты, которые служат капиталу, армии и полиции, также пригодны для преобразования школ, больниц, городов и экологии.

Призывы к справедливости в отношении труда, климата и данных наиболее сильны, когда они объединены. Прежде всего, я вижу самую большую надежду в растущих движениях за справедливость, направленных на решение проблемы взаимосвязи капитализма, вычислений и контроля: объединение вопросов климатической справедливости, трудовых прав, расовой справедливости, защиты данных и превышения полицейской и военной власти. Отвергая системы, способствующие неравенству и насилию, мы бросаем вызов структурам власти, которые ИИ в настоящее время укрепляет, и создаем основы для другого общества. Как отмечает Руха Бенджамин, «Деррик Белл сказал об этом следующим образом: „Чтобы увидеть вещи такими, какие они есть на самом деле, вы должны представить их такими, какими они могли бы быть“. Мы – создатели шаблонов, и мы должны изменить их суть». Для этого необходимо избавиться от очарования технологического решения проблем и принять альтернативные солидарности – то, что Мбембе называет «другой политикой проживания на Земле, ремонта и совместного использования планеты». Существует устойчивая коллективная политика, выходящая за пределы извлечения стоимости; существуют общины, которые стоит сохранить, миры за пределами рынка и способы жить вне дискриминации и жестоких способов оптимизации. Наша задача – проложить туда курс.