Сверточные нейронные сети

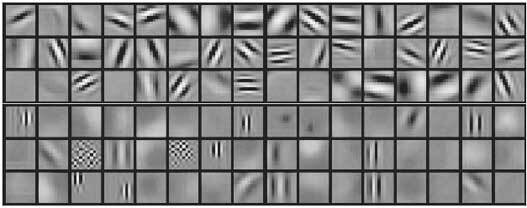

Когда Ян Лекун в 2003 году перешел на работу в Нью-Йоркский университет, он продолжал развивать свою «видящую» сеть, сейчас известную как сверточная нейронная сеть (рис. 9.2). Она основана на свертке, которую можно рассматривать как скользящий фильтр, пропускающий через себя все изображение и создающий параллельно ему новый информационный слой. Например, фильтр, предназначенный для определения контуров, как тот, о котором говорилось в главе 5, имеет большой выходной сигнал только тогда, когда окно находится над краем верно ориентированного объекта на изображении или так же ориентированной текстуры внутри объекта. Окно на первом слое – лишь небольшой фрагмент изображения, при этом может быть много фильтров и, следовательно, много характеристик, представленных в каждом фрагменте. Фильтры в первом слое, который связан с изображением, похожи на то, что Хьюбел и Визель называли простыми клетками первичной зрительной коры (рис. 9.3). Фильтры в более высоких слоях реагируют на еще более сложные характеристики.

В более ранних версиях сверточной сети выходные данные каждого фильтра пропускались через нелинейную функцию, плавно увеличивающуюся от 0 до 1, называемую сигмоидной (S-образной) функцией, которая подавляла вывод слабо активированных блоков. Окно во втором слое, которое получает входные данные от первого слоя, охватывает бо́льшую область поля зрения, так что после нескольких слоев появляются блоки, получающие входные данные со всего изображения. Этот верхний слой схож с верхушкой иерархии зрительной коры, которая у приматов называется нижневисочной корой и имеет рецептивные поля, покрывающие значительную часть поля зрения. Затем верхний слой подается в слой классификации, который использовался для обучения всей сети, чтобы классифицировать объекты на изображении с помощью обратного распространения ошибки.

Рис. 9.3. Фильтры из первого слоя сверточной сети. Каждый фильтр расположен на определенном участке в поле зрения. Предпочтительные входные сигналы некоторых фильтров ориентированы как простые клетки в зрительной коре. Предпочтительные входные сигналы на втором слое более вытянутые и имеют сложные формы [Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton, ImageNet Classification with Deep Convolutional Neural Networks, Advances in Neural Information Processing Systems 25 (NIPS 2012)]

За прошедшие годы в сверточные сети внесли множество улучшений (см. рис. 9.3). Важным дополнением стало объединение каждого признака по областям, получившее название пулинг (pooling). Оно обеспечивает перенос изображения в неизменном виде и похоже на работу сложных клеток, обнаруженных Хьюбелом и Визелем в первичной зрительной коре (см. рис. 5.5), которые реагируют на линии с одинаковой ориентацией на всем участке поля зрения. Еще одной полезной функцией стала нормализация усиления, регулирующего уровень входных сигналов таким образом, чтобы каждый блок работал в пределах определенного диапазона (в коре это реализовано через подавление обратной связи). Сигмоидная функция выхода также была заменена блоками линейной ректификации (ReLUs), которые имеют нулевой выход до четкого порогового значения и линейно увеличиваются выше него. Элементы ниже порогового значения эффективно исключаются из сети, что ближе к тому, как работает пороговое значение у настоящего нейрона.

С тех пор как сверточные сети были усовершенствованы, они стали больше напоминать архитектуру зрительной коры, какой ее представляли в 1960-х годах. Однако все изменения имели математическое обоснования и эффективность повысили способами, которые способен понять инженер, в то время как в 1960-х годах мы могли только догадываться о функциях простых и сложных клеток или о том, для чего нужно распределенное представление на вершине иерархии. Это пример того, как много могут дать тесные взаимосвязи между биологией и глубоким обучением.

Столкновение глубокого обучения и визуальной иерархии

Патриция Черчленд, философ из Калифорнийского университета в Сан-Диего, специализируется на нейрофилософии. Например, эпистемология изучает научное знание и, в конечном счете, зависит от того, как знание представляет мозг. Конечно, это не мешает философам думать о знании как, говоря словами Иммануила Канта, о «вещи в себе», независимо от мира. Однако даже животным для начала необходимо обоснованное знание, чтобы найти безопасное место и выжить. В 1992 году мы с Патрицией Черчленд написали книгу «Вычислительный мозг» для разработки системы понятий в нейробиологии, основанной на больших совокупностях нейронов. Нас вдохновило поразительное сходство в схемах работы скрытых элементов обученной многослойной сети и групп нейронов, записанных поочередно. Эта книга выдержала переиздание и является хорошим учебником для тех, кто хочет больше узнать, как обрабатываются данные в мозге. Джеймс Дикарло из МТИ недавно сравнил отклик нейронов на разных уровнях иерархии зрительной коры обезьян, обученных распознавать изображения объектов, с откликов элементов в сети глубокого обучения, обученной распознавать те же изображения (см. рис. 9.2). Он пришел к выводу, что статистические свойства нейронов в каждом слое сети глубокого обучения вполне соответствуют свойствам нейронов в кортикальной иерархии.

Сходство между свойствами элементов в сети глубокого обучения и свойствами нейронов в зрительной коре, характеристиками сетей и характеристиками человеческого мозга – загадка, особенно учитывая то, что мозг вряд ли будет использовать для обучения метод обратного распространения ошибки. Обратное распространение ошибки требует, чтобы на сигналы об ошибке каждый нейрон в каждом слое откликался с гораздо большей точностью, чем в уже известных обратных связях. Тем не менее другие алгоритмы обучения более биологически правдоподобны – например, алгоритм машины Больцмана, использующий синаптическую пластичность Хебба, найденную в коре. Это ставит интересный вопрос: существует ли математическая теория глубокого обучения, применимая к большому классу алгоритмов обучения, в том числе к алгоритмам в коре мозга? Я уже упоминал о разделении поверхностей на категории на верхних уровнях иерархии в главе 7, где поверхности принятия решений более плоские, чем в нижних слоях. Геометрический анализ поверхности принятия решений может углубить математическое понимание как сетей глубокого обучения, так и мозга.

Одно из преимуществ сети глубокого обучения – мы можем фиксировать данные из каждого блока в сети и следить за потоком информации по мере ее перехода из слоя в слой. Подход к анализу искусственных сетей позже можно будет применять для анализа нейронов в головном мозге. Одна из потрясающих особенностей этой технологии в том, что за ней обычно стоит хорошее объяснение, подталкивающее во всем разобраться. Первые паровые машины инженеры создавали, опираясь лишь на интуицию: теория термодинамики, которая объяснила, как те работают, появилась позже, одновременно с повышением эффективности двигателей. Анализ сетей глубокого обучения физиками и математиками идет полным ходом.