IV

Чтобы предупредить сбои в сложных системах, нам необходимо отыскать целую кучу иголок в стоге сена. Авиакомпания United Airlines вознамерилась продвинуться в этом отношении, запустив программу повышения уровня безопасности. Она создала карту, указывающую, где были спрятаны некоторые из этих иголок. Но это не дало больших результатов – карта не попала в руки к тем, кто в ней нуждался.

Свидетели в ходе расследования крушения рейса 514 настаивали на том, что Федеральное управление авиации должно создать в отрасли единую систему, в которой собирались бы анонимные сообщения и отчеты по вопросам безопасности, и предоставить иммунитет всем, кто будет их посылать. Таким образом, спустя шесть месяцев родилась Система сообщений по вопросам безопасности в авиации (Aviation Safety Reporting System – ASRS).

Система ASRS, которую контролирует специальное подразделение в NASA, собирает тысячи отчетов в месяц – от пилотов, военных, диспетчеров воздушного движения, механиков и всех, занятых в авиационной отрасли. Помимо уверенности, что их не накажут за ошибку, у этих людей появляется чувство гордости. Они знают, что отчеты в ASRS делают воздушные перевозки более безопасными.

Отчеты хранятся в базе данных с открытым доступом, и NASA освещает события и тенденции в области авиабезопасности в ежемесячной новостной рассылке, которая носит название Callback («Отзыв»). Последний выпуск, например, содержал отчет команды авиалайнера, которому в последний момент поменяли взлетно-посадочную полосу, что потребовало крайне резкого снижения. Экипаж не смог его выполнить в отведенное время, поэтому подал соответствующий доклад. В ответ Федеральное управление авиации поменяло процедуру захода на посадку.

В другом выпуске новостной рассылки рассказывалось об опасности халатности на основе историй пилота небольшого частного самолета, который вовремя не переключил подачу топлива из одного бака на другой (и был вынужден приземлиться на шоссе, поскольку топливо в первом баке закончилось), и механика, который погубил двигатель самолета, забыв в нем инструмент для ремонта. Как вы, наверное, уже догадались, Чик Перроу очень любит систему ASRS. «Для конструкторов, – пишет он, – она является источником информации, в котором они обнаруживают парадоксальные вещи, касающиеся недостатков систем. Для организаций она служит напоминанием о том, что хоть кто-то в самом деле думает о вопросах безопасности».

Фундаментальным свойством сложных систем является то, что мы не можем обнаружить все существующие в них проблемы, просто размышляя о них. Сложность системы может вызывать возникновение таких непонятных и редких взаимодействий, что предсказать большинство цепочек ошибок, которые могут возникнуть, практически невозможно. Но перед разрушением сложные системы подают предупреждающие сигналы, которые раскрывают эти взаимодействия. Таким образом, сами системы подсказывают, как эти взаимодействия могут проявиться.

Однако мы часто не уделяем этим подсказкам должного внимания. До тех пор, пока все идет нормально, мы склонны полагать, что наши системы работают хорошо – даже если в основе успеха всего лишь слепая удача. Это называется искаженное понимание результатов. Возьмите, например, Стефана Фишера, воображаемого менеджера проекта, работающего над разработкой нового планшета в какой-то IT-компании. За несколько месяцев до запуска планшета в серийное производство инженер, отвечавший за его фотокамеру, перешел на работу в другую компанию. В результате команда проекта начала отставать от графика. Чтобы сэкономить время, Стефан решил отказаться от подбора и оценки альтернативных камер.

В нашем эксперименте мы попросили 80 студентов высшей школы бизнеса после ознакомления с проектом оценить действия Стефана и рассмотреть три возможных сценария развития событий. В успешном сценарии планшет продавался хорошо, и проблемы отсутствовали. Сценарий «просто повезло» окончился успешно только благодаря случайному благоприятному стечению обстоятельств: конструкция камеры вызывала перегрев планшета, однако можно было модернизировать процессор и уменьшить нагрев устройства. А вот в сценарии неудачи камера также вызывала перегрев планшета, но модернизировать процессор не представилось возможным. Это стало большой проблемой, и планшет продавался плохо.

В случае со студентами, которые оценивали проект Стефана (как и в случае с инженерами NASA, участвовавшими в подобном же эксперименте с безымянным космическим кораблем), оценку участников определял результат. Когда продажи планшетов шли успешно, Стефан получал хорошие характеристики. Даже когда его проект ждал успех только в результате слепой удачи, участники оценивали его как высококвалифицированного, умного и заслуживающего продвижения по службе. Они выражали сомнения в качестве его решений только в случае неудачи проекта. Но пока проект не терпел фиаско, участники эксперимента не придавали особого значения тому обстоятельству, что Стефану просто везло. Они не усматривали особой разницы между хорошей работой и элементарным везением.

Помните потерю финансовой компанией Knight Capital 500 млн долларов на бирже? Эта потеря произошла из-за небольшой ошибки IT-специалиста компании, который забыл скопировать новый компьютерный код на все восемь серверов Knight Capital. Когда-то в прошлом компьютерщики компании наверняка совершали подобные ошибки, но им везло, и проблема разрешалась без каких-либо потрясений. Поэтому был сделан вывод, что система работает нормально. В конце концов, никаких неудач ведь не было. Однако на самом деле запуск каждого нового программного обеспечения превращался в игру в кости.

Многие из нас совершают нечто подобное и в повседневной жизни. Мы относимся к засорившемуся туалету как к небольшому неудобству, а не как к сигналу тревоги – пока не прорывает канализацию. Или мы игнорируем небольшие «тревожные звоночки» в автомобиле – например, туго переключающуюся коробку передач или шину, которая медленно спускает воздух, – вместо того чтобы отвезти машину в ремонт.

Чтобы совладать со сложностью систем, нам необходимо научиться воспринимать небольшие сбои – информацию, которой эти системы буквально забрасывают нас. Сюда же относятся ситуации, когда мы минуем неудачи буквально чудом, и другие предупреждающие знаки. Во Флинте городские власти не придали должного значения целому ряду сигналов тревоги и упорно настаивали на том, что воду из городского водопровода можно пить без опасений. Они даже не признали наличия проблемы. Инженеры вашингтонского метро сработали лучше. Они понимали, в чем состоит проблема, и создали процедуру тестирования и мониторинговую программу, которая должна была следить за системой. Эти охранительные меры, однако, оказались погребенными под повседневной суетой. Хотя решение проблемы было найдено, оно не применялось на практике. Наконец, менеджеры United Airlines осознавали наличие проблемы и предупредили о ней всех своих пилотов, но это предупреждение не вышло за пределы авиакомпании. Оно не достигло пилотов TWA, которые управляли злополучным рейсом № 514.

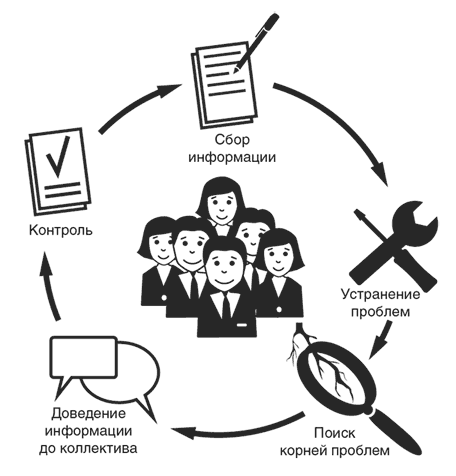

Каждая из этих историй приближает нас к решению, которое может сработать. Оказывается, в некоторых организациях нашли способы, благодаря которым можно учиться на небольших ошибках и предаварийных ситуациях. Исследователи называют эту методику аномализированием, пример ее графического представления мы дали на следующей странице.

Первый шаг – это сбор информации. Он подразумевает тщательный сбор данных об успешно миновавших предаварийных ситуациях и изучение того, что пошло не так. Например, авиакомпании собирают информацию не только о случаях успешного предотвращения аварийных ситуаций, но и прямые данные о полетах.

Второй шаг – устранение выявленных проблем. Сообщения о преодоленных предаварийных ситуациях не должны пылиться в коробке с названием «Для замечаний и предложений». Например, в одном госпитале в штате Иллинойс медсестра чуть не перепутала лекарства, предназначенные для двух разных пациентов из одной палаты. У пациентов были одинаковые фамилии, а названия прописанных им препаратов были очень похожими. Медсестра вовремя предотвратила ошибку и написала соответствующую докладную. В результате пациентов перевели в разные палаты, чтобы помочь следующей медсестре избежать подобной ошибки.

Третий шаг заключается в том, чтобы «докопаться» до корней проблем и устранить причины их возникновения. Менеджер по контролю качества лекарств в местном госпитале обратил внимание на повторяющиеся ошибки с назначением препаратов в одном из отделений. Фармацевты стали «копать» глубже, чтобы понять причины ошибок. Оказалось, что медсестер, которые готовили лекарства к раздаче пациентам в общем коридоре, постоянно что-то отвлекало. В связи с этим менеджеры госпиталя выделили для подготовки лекарств к раздаче отдельное помещение, в котором была создана необходимая обстановка, не отвлекавшая сестер.

После того как мы поняли проблему, также надо осознать, что предаварийные ситуации нельзя скрывать. Информация о случаях, попадающих в категорию «на волосок от…», должна доводиться до всех – либо в рамках какой-то организации, либо в рамках целой отрасли экономики, как это происходит благодаря новостной рассылке Callback. Общее понимание возможных промахов проясняет для людей тот факт, что ошибки являются нормальной частью системы и каждый может с такими проблемами столкнуться.

А на заключительном этапе мы должны удостовериться, что решения, принятые в ответ на предупреждающие сигналы, действительно работают. На некоторых авиарейсах, например, в кабине присутствует еще один пилот, который наблюдает за действиями экипажа и обращает внимание на такие вещи, как пропущенные элементы контрольного списка или ошибочные операции. Такой подход позволяет авиакомпаниям проводить аудит собственных решений. В противном случае эти решения могут потеряться в повседневной суете, как это произошло в вашингтонском метро. Иногда те самые люди, которые должны использовать найденные решения, даже не знают об их существовании. Контроль исполнения решений позволяет добиться того, чтобы лекарство не приносило больше вреда, чем сама болезнь. А такое может происходить, например, когда решение проблемы излишне усложнено или когда дополнительный мониторинг создает слишком много ложных сигналов тревоги.

В основе всего этого находится корпоративная культура, созданная в организации. Как сказал нам Бен Берман, капитан авиалайнера и участник расследований многих авиационных происшествий, «если вы собираетесь расстреливать всех гонцов, то никто ничего вам не расскажет об ошибках и сбоях, которые существуют в вашей системе». Открыто знакомя всех с неудачами или ошибками, которые не обернулись неудачей только чудом, без возложения на кого-то вины или без угрозы наказания, мы можем создать такую организационную культуру, в которой люди будут воспринимать ошибки как возможность чему-то научиться, а не как призыв к «охоте на ведьм». «Успешный сотрудник, всегда получающий благодарственные письма от генерального директора, еще не показатель безопасности организации», – писал Боб Уотчер, врач госпиталя Калифорнийского университета в Сан-Франциско, изучавший дело о Пабло Гарсия и передозировке антибиотиков, о чем было рассказано ранее в этой книге. Настоящим мерилом безопасности выступает такая ситуация, в которой кто-то, озвучивший проблему, может оказаться неправ, но тоже получает благодарственное письмо.

Возможно, вы читаете это и думаете: «Да, это все хорошо для авиакомпаний и больниц. Но что остается делать мне в том случае, если в моей организации не происходит ошибок, которые напрямую связаны с конкретными производственными происшествиями?». Тогда что же вам вообще отслеживать? И что можно сказать о тех проблемах, которые прямо с безопасностью не связаны, но которыми вы не хотели бы делиться с конкурентами?

Ответ знает датский социолог и исследователь культуры организаций Клаус Реруп. Используя информацию о целом ряде интересных событий – включая рок-концерты, крушения паромов и сбои в больших транснациональных корпорациях, – Реруп изучает, как организации реагируют на небольшие сигналы о предстоящей неудаче, чтобы предотвратить беду.

Несколько лет Реруп глубоко изучал транснациональную фармацевтическую компанию Novo Nordisk, одного из самых крупных производителей инсулина в мире. Как отмечает Реруп, в начале 1990-х годов для любого сотрудника Novo Nordisk было сложно привлечь внимание руководства даже к серьезным угрозам. «Вам необходимо было убедить своего босса, а затем босса этого босса, а после еще босса всех этих боссов в существовании какой-то проблемы, – пояснял один из старших вице-президентов компании. – Потом этот босс должен был убедить своего руководителя в том, что нужно что-то где-то поменять». Но, как в детской игре «Сломанный телефон», когда слова передаются от одного к другому и все больше искажаются с каждым звеном, проблемы излишне упрощались по мере продвижения по иерархической цепочке. «То, что было написано в оригинальном варианте доклада… и что являлось сигналом тревоги для специалиста, – говорил нам один генеральный директор Novo Nordisk, – скорее всего, вычеркивалось из докладов, которые получало в конечном счете высшее руководство компании».

В то время сотрудники Novo Nordisk, работавшие на производстве, знали, что в скором времени корпорации будет трудно соблюдать все более строгие стандарты, которые вводило Федеральное управление по санитарному контролю за качеством пищевых продуктов и медикаментов (FDA). Но руководители компании и не подозревали, что кризис уже за воротами. В 1993 году Novo Nordisk наняла группу отставных инспекторов FDA для того, чтобы провести самостоятельный аудит в компании. Инспекторы обнаружили шокирующее количество проблем. Ситуация выглядела так, что Novo Nordisk, скорее всего, могла потерять лицензию на сбыт инсулина в США. Компания забраковала шестимесячные складские запасы инсулина и обратилась к фирме Eli Lilly, одному их своих главных конкурентов, с просьбой принять у нее всю американскую клиентскую базу. В конечном счете неспособность Novo Nordisk соответствовать стандартам FDA подорвала репутацию компании и принесла ей убытков на 100 млн долларов.

По результатам этой неудачи в Novo Nordisk не стали возлагать вину на конкретных людей. В компании не только обратились к менеджерам с призывами быть более внимательными, но и ввели масштабные изменения, которые повысили ее способность замечать тревожные сигналы и учиться на них.

Для обнаружения новых проблем в Novo Nordisk был создан целый отдел из двадцати работников, в чью задачу входил мониторинг новых вызовов извне. Частью их работы стало взаимодействие с некоммерческими организациями, обществами по защите экологии и правительственными чиновниками по таким вопросам, как генетические модификации и изменения в правилах регулирования, которые менеджеры компании могут просто пропустить (не найти времени для их обдумывания). После выявления конкретной крупной проблемы создаются рабочие группы из сотрудников различных подразделений и разного должностного уровня. Эти группы должны исследовать, как данная проблема может повлиять на их зону ответственности и что можно сделать для предотвращения ее появления в дальнейшем. Цель состоит в обретении уверенности в том, что в Novo Nordisk не игнорируются даже небольшие тревожные сигналы зреющих серьезных проблем.

В Novo Nordisk также проводят аудиты, чтобы обнаруживать проблемы внутри компании. При этом привлекается специальная категория работников-координаторов, которые следят, не оказались ли крупные проблемы под иерархическими завалами (как это произошло до кризиса с производством инсулина). Координаторы – порядка двух десятков человек, выбранных из наиболее уважаемых менеджеров компании, – работают с каждым подразделением по меньшей мере раз в несколько лет. Два таких координатора обычно беседуют как минимум с 40 % работников подразделения, чтобы понять их заботы. Один из координаторов рассказал: «Мы говорим о таких вещах, которые обычно не обсуждаются. Запретных тем для нас нет».

Впоследствии координаторы анализируют собранные данные и делают выводы, нет ли в них тех проблем персонала, которые могут не замечать руководители подразделения. «Мы обходим компанию и ищем небольшие проблемы, – объяснил один из координаторов. – Мы не знаем, превратятся ли они во что-то более серьезное, если их проигнорировать. Но нельзя рисковать. Мы принимаем меры даже по небольшим сбоям».

Когда координаторы обнаруживают какую-то проблему, менеджер подразделения обычно обращает на нее внимание. Заботы и беспокойство персонала уже не прогоняются через иерархические фильтры. И речь идет не просто о повышении информированности. Координаторы готовят списки конкретных действий, которые менеджеры должны предпринять для улучшения положения дел в своем подразделении. Каждое такое действие поручается конкретному человеку и отслеживается до устранения проблемы. В прошлом году 95 % таких действий было выполнено в срок.

Программа, запущенная в Novo Nordisk, может показаться масштабным мероприятием. Но ведь и компания Novo Nordisk – предприятие большое. Данная программа стóит всего лишь 1 % от его годового дохода. Однако подобные принципы могут применяться и в меньших масштабах – даже в рамках команды или подразделения организации. Реруп вместе с одним коллегой даже изучили, как меньшая версия этой системы применяется в семейных фирмах с привлечением всего одного лица – надежного советника. Такие советники, как правило, остаются за кулисами и оттуда помогают частным предпринимателям замечать угрозы, исходящие от конкурентов, технологических сбоев и изменений в правилах государственного регулирования. Такие советники могут даже заранее предвидеть возникновение несогласия внутри семьи и напомнить владельцам бизнеса о том, что им следует советоваться со своими близкими при принятии важных решений. Как и специальный отдел в Novo Nordisk, эти советники просматривают весь семейный бизнес своих клиентов на предмет наличия возникающих проблем и появления тревожных сигналов, а также заставляют руководителей обратить на них внимание.

В опасной зоне наши системы настолько сложны, что зачастую очень трудно точно предсказать, что может пойти не так. Однако всегда есть предупреждающие сигналы – они как надписи на стене. Нам остается только научиться их читать.