Прохождение теста Тьюринга

Каждый месяц ИИ овладевает все более сложными навыками, а стоимость вычислений, необходимых для его работы, неуклонно снижается. Траектория развития ясна. Но как мы поймем, что ИИ достиг уровня человеческого мозга? Тест Тьюринга дает нам возможность подойти к этому вопросу с научной точки зрения. Однако сам Тьюринг не обозначил всех условий эксперимента, например, он не уточнил, сколько времени должна продолжаться беседа машины и человека и какими качествами должен обладать судья. Девятого апреля 2002 года я и Митч Капор, один из первых разработчиков программ для персональных компьютеров, заключили пари в проекте фонда Long Now. Мы поспорили о том, будет ли пройден тест Тьюринга к 2029 году152. В ходе обсуждения возникло множество новых вопросов, в частности, о допустимом уровне усовершенствования мышления человека, при котором он все еще может быть судьей или участником.

Подробно описанная методика проведения теста крайне важна, поскольку, как мы уже упоминали ранее, люди склонны в ретроспективе недооценивать сложность задач, решенных ИИ. Это явление получило название «синдром искусственного интеллекта»153. За семь десятилетий, прошедших со дня описания Аланом Тьюрингом его игры в имитацию, компьютеры постепенно превзошли людей в ряде специфических аспектов интеллекта. Однако чего машинам всегда недоставало, так это гибкости и широты охвата человеческой мысли. После победы суперкомпьютера Deep Blue фирмы IBM над чемпионом мира по шахматам Гарри Каспаровым в 1997 году многие комментаторы не сочли это достижение значимым в том, что касается моделирования общего интеллекта154. Игру в шахматы легко описать математически, потому что расположение и свойства фигур на доске определяются однозначно, количество допустимых ходов сравнительно невелико. Так что победу над Каспаровым можно отнести на счет хитроумных вычислений. При этом ряд наблюдателей уверенно заявлял, что машины никогда не добьются успеха в многогранных задачах, связанных с обработкой фраз на естественном языке, таких как разгадывание кроссвордов или телевизионная игра «Джеопарди!»155. С кроссвордами машины справились через два года156, а менее чем двенадцать лет спустя суперкомпьютер Watson, разработанный компанией IBM, сыграл в «Джеопарди!» и победил двух самых успешных игроков за всю историю этой игры – Кена Дженнигса и Брэда Руттера 157.

Эти викторины выявили очень интересную особенность ИИ. Наблюдая, как ловко Watson вникает в игровые подсказки, ищет информацию и уверенно озвучивает правильные ответы роботизированным голосом, легко было поддаться иллюзии, что компьютер размышляет примерно так же, как Кен или Брэд. Однако у зрителей была дополнительная информация. В нижней части экрана отображались три лучшие версии, полученные суперкомпьютером, в порядке убывания вероятности. Хотя в первой строчке почти всегда содержался верный ответ, две другие догадки были не просто неверными, они были смехотворно неподходящими. Таких нелепых ошибок не допустил бы даже самый слабый из игроков-людей. Например, на вопрос «Члены этого органа избираются каждые 5 лет, сейчас в нем заседают 736 человек из 7 фракций»158 из категории «ЕС, Европейский союз» Watson дал верный ответ «Европейский парламент», присвоив ему вероятность 66 %. Вторым вариантом было «ДЕП» (депутаты Европарламента, 14 %), а третьим с вероятностью 10 % шло «всеобщее избирательное право»159. Даже тот, кто никогда не слышал о Европарламенте, не мог бы предположить, что варианты 2 или 3 являются верными, хотя бы исходя из формулировки вопроса. Таким образом, хотя стиль игры Watson был похож на человеческий, «под капотом» явно происходили процессы, не свойственные мышлению человека.

В последние годы нам удалось научить ИИ гораздо лучше понимать и использовать естественные языки. В 2018 году компания Google представила сервис Duplex – роботизированного помощника, умеющего настолько хорошо общаться по телефону, что ничего не подозревавшие собеседники были уверены, что говорят с человеком. В том же году компания IBM разработала систему Project Debater, способную вести осмысленные споры160. А к 2023 году большие языковые модели уже научились писать сочинения так же хорошо, как люди.

Однако, несмотря на все свои достижения, даже GPT-4 время от времени оказывается подвержен «галлюцинациям»: ИИ уверенно выдает утверждения, не имеющие ничего общего с реальностью161. Например, если попросить его кратко пересказать несуществующие новости, он может сочинить весьма правдоподобную сводку. А в ответ на просьбу указать источники достоверного научного факта нейросеть может перечислить несуществующие статьи. Сейчас ведется активная работа над устранением этой проблемы162, но пока неясно, насколько сложной она окажется в итоге. Появление таких ошибок лишний раз свидетельствует о том, что, как и в случае с Watson, современные мощные системы ИИ находят ответы путем сложных математических и статистических вычислений, что сильно отличается от привычного нам мышления.

Интуитивно нам это не нравится. Кажется, что Watson «должен» рассуждать, как человек. Но, на мой взгляд, это предрассудки. На самом деле нам важно, как разумное существо действует. Если к выдающемуся научному открытию или душещипательному сюжету его приведут иные мыслительные процессы, то что с того? А в случае, когда ИИ будет утверждать, что обладает сознанием, какие у нас будут основания настаивать, что только биологическая система, подобная нашей, может считаться по-настоящему разумным организмом? В этом смысле эмпирический тест Тьюринга предоставляет нам верные ориентиры.

Хотя тест Тьюринга может стать отличным инструментом для оценки прогресса ИИ, его прохождение не стоит считать единственно возможным критерием развитого интеллекта. Как показывают системы PaLM 2 и GPT-4, машины могут превосходить людей в решении сложных задач, при этом не научившись убедительно имитировать действия человека во всех возможных ситуациях. По моим прогнозам, в промежутке между 2023 и 2029 годами, когда будет пройден тест Тьюринга, компьютеры уже превзойдут людей в самых разных областях деятельности. Более того, не исключено, что ИИ научится самосовершенствоваться раньше, чем учитывать нюансы человеческого общения, необходимые для прохождения теста. Уверенности в этом нет, но сама возможность заставляет нас более тщательно рассмотреть определение «интеллект уровня человеческого». В этом определении немалую роль сыграет тест Тьюринга, но нам также необходимо разработать более сложные методы, чтобы понять, в чем разница между человеческим и машинным интеллектом и в чем они схожи.

Хотя не все согласны, что тест Тьюринга – это надежный способ определить, обладает ли машина интеллектом, сравнимым с человеческим, я убежден, что его успешное прохождение убедит наблюдателей и широкую публику в том, что они имеют дело с настоящим разумом, а не просто с имитацией. Как писал Тьюринг в 1950 году: «Разве не может внутри машины происходить процесс, не похожий на тот, что идет в голове человека, и который тем не менее иначе как мышлением не назовешь? <…> Но если при этом машина способна показать удовлетворительный результат в игре в имитацию, значит, аргумент о несхожести внутренних процессов мышления не должен нас беспокоить»163.

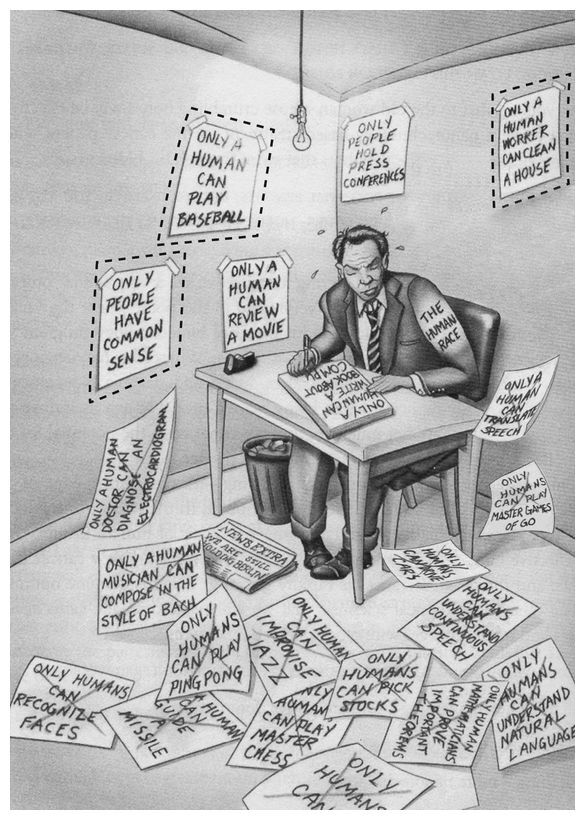

На этом рисунке представлены задачи, с которыми искусственному интеллекту еще предстоит справиться. Листки на полу символизируют уже освоенные ИИ навыки, а над теми, что пока висят на стене, очерченные пунктирными линиями, ведется активная работа. (Только человек может играть в бейсбол. Только у людей есть здравый смысл. Только человек может написать рецензию на фильм. Только люди проводят пресс-конференции. Только человек может навести порядок в доме. Человеческая раса. Только человек может написать книгу о компьютере. Только человек может переводить речь. Только люди могут мастерски играть в го. Только человек может поставить диагноз по ЭКГ. Прочие новости Мы все еще удерживаем Берлин. Только человек может сочинять музыку, подражая Баху. Только люди могут играть в настольный теннис. Только люди могут узнавать лица. Человек может управлять ракетой. Только люди могут импровизировать в джазе. Только люди могут мастерски играть в шахматы. Только люди могут инвестировать. Только человек может водить машину. Только люди могут понимать непрерывную речь. Только люди могут понимать естественный язык. Только люди могут доказать важные теоремы. Только люди могут…)

Важно отметить, что, если искусственный интеллект успешно пройдет строгий тест Тьюринга, это будет означать, что он способен продемонстрировать более высокие результаты, чем человек, на любом экзамене, проводимом на естественном языке164. Независимо от того, в какой области ИИ проявляет свои слабые стороны, письменный тест способен их обнаружить. Конечно, это возможно только при условии, что судьи и собеседники сами достаточно компетентны и внимательны. Не составит труда притвориться выпившим, сонным или не владеющим языком человеком165. Кроме того, ИИ, который сумеет обмануть судей, не знакомых с методикой тестирования его способностей, не будет считаться прошедшим тест.

Тьюринг считал, что такой тест подходит для оценки способностей ИИ в «любой из областей человеческой деятельности по нашему усмотрению». Находчивый экзаменатор может попросить ИИ объяснить сложную ситуацию в общении между людьми, сделать выводы на основе представленных научных данных, предложить смешную сцену для комедии. Таким образом, тест Тьюринга проверяет не просто понимание естественного языка, а наличие умственных способностей, которые мы проявляем посредством речи. Конечно, успешный ИИ не должен производить впечатление сверхчеловека. Если экзаменуемый будет мгновенно отвечать на все энциклопедические вопросы, быстро проверять числа на простоту и бегло говорить на сотне языков, станет ясно, что с нами общается не человек.

Кроме того, искусственный интеллект, который достигнет такого уровня, будет обладать способностями, значительно превосходящими человеческие, начиная с объема памяти и заканчивая скоростью мышления. Вообразите себе систему, умеющую читать на уровне человека и обладающую банком данных со всеми статьями из «Википедии» и полным архивом научных публикаций за всю историю. Пока что именно недостаточно глубокое понимание нашего языка не позволяет ИИ эффективно наращивать свой объем знаний. Прогресс людей же сдерживается низкой скоростью чтения, скромным объемом памяти и в целом слишком короткой жизнью. Компьютеры уже в состоянии обрабатывать данные с потрясающей скоростью: если человеку на чтение одной книги требуется в среднем около шести часов, сервис Talk to Books компании Google справляется с этой задачей в пять миллиардов раз быстрее166. Кроме того, объем памяти компьютеров практически не ограничен.

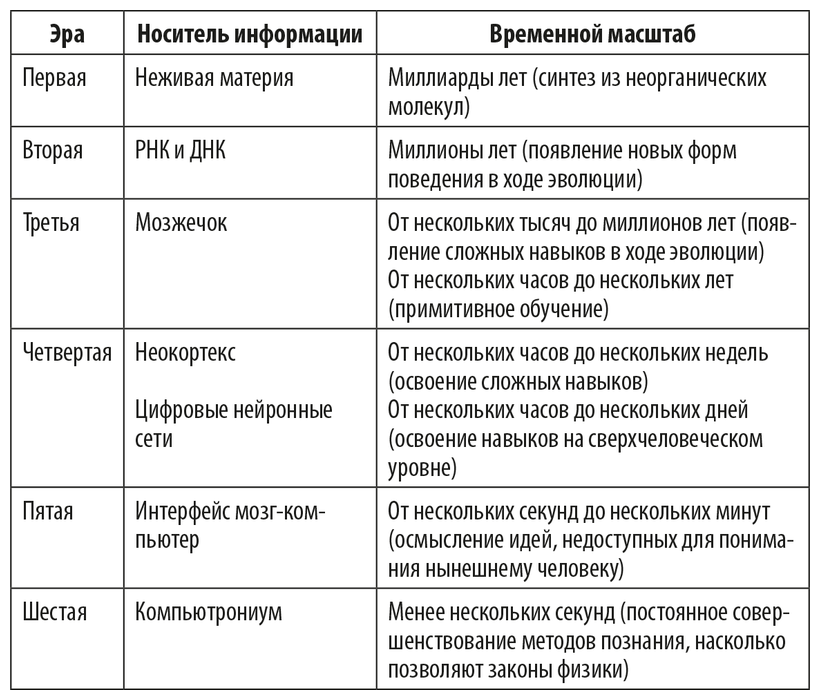

Смена парадигм обработки информации в процессе эволюции

Когда ИИ овладеет языком на уровне человека, ему не просто станет легче постепенно пополнять свои знания, скорее это приведет к взрывному росту его эрудиции. Чтобы пройти затем тест Тьюринга, ему буквально придется прикидываться дураком! В тех же задачах, где не будет нужды имитировать человеческое поведение, например в области медицины, химии, инженерии, ИИ уровня Тьюринга сможет достичь небывалых успехов.

К чему это приведет, мы обсудили в предыдущей главе, когда говорили о шести информационных эрах. В таблице «Смена парадигм обработки информации в процессе эволюции» кратко изложены основные моменты.