Глава 3

Данные

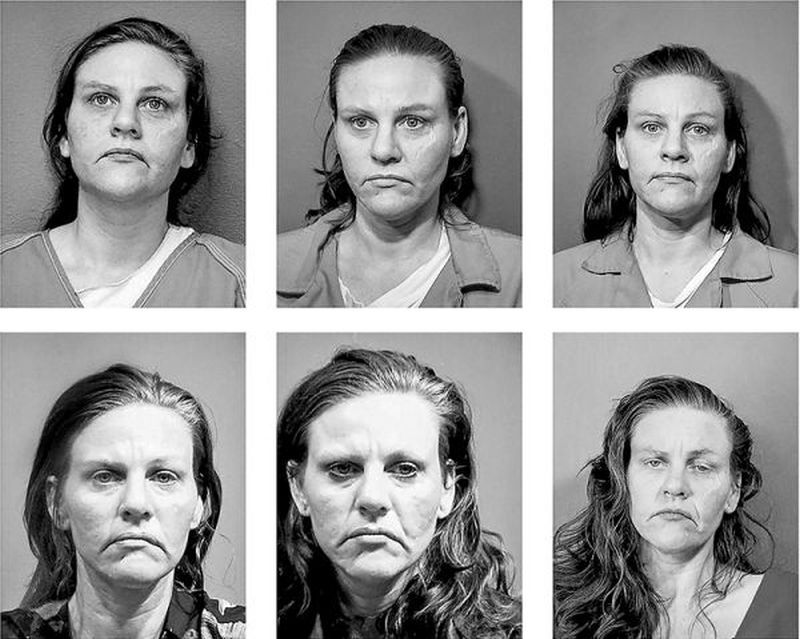

Молодая женщина смотрит вверх, глаза сфокусированы на чем-то за пределами кадра, как будто она отказывается признать камеру. На следующей фотографии ее взгляд устремлен вдаль. На другой фотографии она изображена с растрепанными волосами и угрюмым выражением лица. На протяжении всей последовательности снимков мы видим, как она со временем стареет, морщины вокруг рта опускаются и углубляются. На последнем кадре она выглядит обиженной и удрученной. Это фотографии женщины, арестованной на протяжении многих лет жизни. Ее изображения хранятся в коллекции, известной как NIST Special Database 32 – Multiple Encounter Dataset, размещенной в Интернете для исследователей, желающих протестировать программы распознавания лиц.

Эта база данных, поддерживаемая Национальным институтом стандартов и технологий (NIST), – одна из старейших и наиболее уважаемых лабораторий физических наук в США, которая в настоящее время входит в состав Министерства торговли. NIST был создан в 1901 году с целью укрепления измерительной инфраструктуры страны и создания стандартов, которые могли бы конкурировать с экономическими соперниками в промышленно развитом мире, такими как Германия и Великобритания. Все – от электронных медицинских карт до сейсмостойких небоскребов и атомных часов – находится в ведении NIST. Он стал агентством измерения: времени, протоколов связи, неорганических кристаллических структур, нанотехнологий. Цель NIST состоит в том, чтобы сделать системы совместимыми посредством определения и поддержки стандартов, и теперь это включает разработку стандартов для искусственного интеллекта. Одна из инфраструктур тестирования, которую он поддерживает, предназначена для биометрических данных.

Впервые я обнаружила базы данных снимков в 2017 году, изучая архивы NIST. Их биометрические коллекции довольно обширны. Более пятидесяти лет NIST сотрудничает с Федеральным бюро расследований в области автоматического распознавания отпечатков пальцев и разрабатывает методы оценки качества сканеров отпечатков и систем визуализации. После террористических атак 11 сентября 2001 года NIST стал частью национальных мер по созданию биометрических стандартов для проверки и отслеживания людей, въезжающих в США. Это стало поворотным моментом для исследований в области распознавания лиц; они расширились с фокуса на правоохранительные органы до контроля людей, пересекающих государственные границы.

Изображения, взятые из специальной базы данных NIST 32-Multiple Encounter Dataset (MEDS). Национальный институт стандартов и технологий, Министерство торговли США

Сами по себе снимки выглядят ужасно. У некоторых людей видны раны, синяки и подбитые глаза; другие расстроены и плачут. Кто-то безучастно смотрит в камеру. База содержит тысячи фотографий умерших людей с многочисленными арестами, поскольку они неоднократно сталкивались с системой уголовного правосудия. Люди представлены как точки данных; здесь нет ни историй, ни контекста, ни имен. Поскольку снимки сделаны в момент ареста, нам неясно, виновны они, оправданы или заключены в тюрьму. Все они представлены одинаково.

Включение этих снимков в базу данных NIST изменило их значение с использования для идентификации лиц в системах правоохранительных органов до превращения в техническую основу для тестирования коммерческих и академических систем искусственного интеллекта. В своем исследовании Аллан Секула утверждает, что фотографии являются частью традиции технического реализма, цель которого – «предоставить стандартный физиогномический портрет преступника» В истории полицейской фотографии, отмечает Секула, существует два различных подхода. Такие криминологи, как Альфонс Бертильон, который изобрел фоторобот, рассматривали его как своего рода биографическую машину идентификации, необходимую для выявления рецидивистов. С другой стороны, Фрэнсис Гальтон, статистик и основоположник евгеники, использовал составные портреты заключенных как способ выявления биологически обусловленного «преступного типа». Гальтон работал в рамках физиогномистской парадигмы, целью которой являлся поиск обобщенной внешности и выявление черт характера по внешним признакам. Когда фотороботы используются в качестве обучающих данных, они больше не являются инструментом идентификации, а скорее служат для тонкой настройки автоматизированной формы видения. Они используются для выявления основных математических компонентов лиц, чтобы «свести природу к геометрической сущности».

Снимки являются частью архива, используемого для тестирования алгоритмов распознавания лиц. Лица в базе данных Multiple Encounter Dataset стали стандартизированными изображениями, технической основой для сравнения точности алгоритмов. NIST в сотрудничестве с исследовательским агентством Intelligence Advanced Research Projects Activity (IARPA) проводит соревнования с фотографиями, в ходе которых исследователи конкурируют за самый быстрый и точный алгоритм. Команды стремятся победить друг друга в таких задачах, как установка идентичности или извлечение лица из кадра видеозаписи с камер наблюдения. Победители гордятся победами, поскольку они способны принести славу, предложения о работе и признание в отрасли.

Ни люди, изображенные на фотографиях, ни их семьи не имеют права голоса в отношении применения снимков и, скорее всего, даже не подозревают, что стали частью испытательного полигона ИИ. О людях, изображенных на фотографиях, редко задумываются, и лишь немногие инженеры когда-либо пристально их рассматривают. Как говорится в документе NIST, они существуют исключительно для «совершенствования инструментов, методов и процедур распознавания лиц в рамках поддержки идентификации следующего поколения (NGI), судебно-медицинского сравнения, обучения, анализа, соответствия изображений лиц и стандартов межведомственного обмена». В описании базы отмечается, что на многих людях заметны следы насилия, такие как шрамы, синяки и повязки. Но в документе делается вывод, что эти признаки «трудно интерпретировать из-за отсутствия базовой истины для сравнения с „чистым“ образцом». Эти люди рассматриваются не как личности, а как часть общего технического ресурса – всего лишь один компонент данных программы проверки распознавания лиц, золотого стандарта в этой области.

Я просмотрела сотни данных за годы исследований, выясняя, как создаются системы искусственного интеллекта, но базы данных NIST особенно тревожны, потому что они представляют собой модель того, что должно было произойти. Дело не только в непреодолимом пафосе самих изображений. Дело не только во вторжении в частную жизнь (подозреваемые и заключенные не имеют права отказаться от фотографирования). Дело в том, что базы данных NIST предвещают появление логики, которая сегодня прочно проникла в технологический сектор: непоколебимая вера в то, что все кругом – это данные, и их всегда можно взять. Неважно, где сделана фотография, отражает ли она момент уязвимости или боли или представляет собой форму пристыжения объекта. В индустрии стало настолько нормальным брать и использовать все, что доступно, что мало кто задумывается о лежащей в основе политике.

Снимки с места преступления являются уртекстом современного подхода к созданию ИИ. Контекст, который представляют изображения, считается неважным, потому что фотографии больше не существуют как отдельные элементы. Считается, что они не несут ни смысловую, ни этическую нагрузку. Личные, социальные и политические смыслы представляются нейтрализованными. Я считаю, что этот переход от изображения к инфраструктуре – где значение или забота, которые можно было бы придать изображению отдельного человека или контексту, – стирается в тот момент, когда снимок становится частью совокупной массы в обширной системе. Все это рассматривается как данные, которые нужно прогнать через функции ради улучшения технических характеристик. Это основная предпосылка идеологии извлечения данных.

Системы машинного обучения ежедневно тренируются на подобных изображениях – изображениях, взятых из Интернета или государственных учреждений без контекста и без согласия. Они не являются нейтральными. Они отражают личные истории, структурное неравенство и всю несправедливость, которая сопровождает наследие полицейской и тюремной систем в Соединенных Штатах. Но предположение, что эти изображения каким-то образом могут служить аполитичным, инертным материалом, влияет на то, как и что «видит» инструмент машинного обучения. Система компьютерного зрения способна определить лицо или здание, но не то, почему человек находится в полицейском участке, или какой-либо социальный и исторический контекст, окружающий этот момент. В конечном счете, конкретные случаи данных – например, фотография лица – не имеют значения для обучения модели ИИ. Все, что имеет значение, – это достаточно разнообразная совокупность. Любое отдельное изображение может быть легко заменено другим, и система будет работать так же. Согласно этому мировоззрению, из постоянно растущей и глобально распределенной сокровищницы интернета и платформ социальных сетей всегда можно собрать больше данных.

Человек, стоящий перед камерой в оранжевом комбинезоне, дегуманизируется как «данные». История этих изображений, то, как они получены, их институциональный, личный и политический контекст даже не рассматриваются. Коллекции снимков используются как любой другой практический ресурс свободных, хорошо освещенных изображений, как эталон для работы таких инструментов, как распознавание лиц. И, подобно затягивающемуся храповику, лица умерших, подозреваемых и заключенных собираются для улучшения систем полиции и пограничного контроля, которые затем используются для наблюдения и задержания большего количества людей.

Последнее десятилетие ознаменовалось резким увеличением объема цифрового материала для производства ИИ. Эти данные являются основой для осмысления, но не как классические представления мира с индивидуальным значением, а как массовый сбор данных для машинных абстракций и операций. Этот процесс стал настолько фундаментальным для сферы ИИ, что не вызывает сомнений. Как же мы к этому пришли? Какие способы восприятия способствовали лишению данных контекста, смысла и специфики? Как учебные данные приобретаются, понимаются и используются в машинном обучении? Каким образом обучающая информация ограничивает ИИ?

В этой главе я показываю, каким образом данные стали движущей силой успеха ИИ и его мифологии, и как они приобретаются. Стоит отметить, что более глубокие последствия этого стандартного подхода редко рассматриваются, хотя он способствует дальнейшей асимметрии власти. Индустрия ИИ поощряет своего рода безжалостный прагматизм, с минимальным контекстом, осторожностью или согласием на использование данных, в то время как продвигается идея, что массовый сбор необходим и оправдан для создания систем прибыльного вычислительного «интеллекта». Все это привело к тому, что любые формы изображения, текста, звука и видео являются просто необработанными данными для систем искусственного интеллекта, и считается, что цель оправдывает средства. Но мы должны задаться вопросом: кто выиграл от этой трансформации, и почему доминирующие нарративы о данных сохранились? Как мы видели в предыдущих главах, логика добычи, определившая отношение к земле и человеческому труду, также является определяющей чертой того, как данные используются и понимаются в ИИ. Внимательно рассмотрев обучающие данные как центральный пример в ансамбле машинного обучения, мы можем начать понимать, что стоит на кону в этой трансформации.

Обучение машин видеть

Будет полезно рассмотреть, почему системы машинного обучения требуют огромных объемов данных. Одним из примеров является компьютерное зрение – область искусственного интеллекта, занимающаяся обучением машин распознаванию и интерпретации изображений. По причинам, которые редко признаются в области компьютерных наук, проект интерпретации картинок является очень сложным и реляционным. Изображения – удивительно трудные элементы, отягощенные множеством потенциальных значений, неразрешимых вопросов и противоречий. Тем не менее, в настоящее время на первых этапах создания системы компьютерного зрения принято брать тысячи или даже миллионы изображений из интернета, создавать и упорядочивать их в ряд классификаций, и использовать это в качестве основы для того, как система будет воспринимать наблюдаемую реальность. Эти обширные коллекции называются обучающими наборами данных, и они представляют собой то, что разработчики ИИ часто называют «базовой истиной». Истина, таким образом, – это не столько фактическое представление или согласованная реальность, сколько нагромождение изображений, взятых из различных доступных онлайн-источников.

При контролируемом машинном обучении инженеры предоставляют компьютеру маркированные обучающие данные. Затем в игру вступают два различных типа алгоритмов: обучающие и классифицирующие. Обучающий алгоритм – это алгоритм, который учится на помеченных данных; он сообщает классификатору, как лучше проанализировать связь между новыми входными данными и желаемым конечным результатом (или предсказанием). Например, он может определить: содержится ли на изображении лицо, является ли электронное письмо спамом. Чем больше маркированных примеров, тем точнее будет алгоритм. Существует множество видов моделей машинного обучения, включая нейронные сети, логистическую регрессию и деревья решений. Инженеры выбирают модель в зависимости от того, что они создают – будь то система распознавания лиц или средство определения настроений в социальных сетях, – а затем подбирают ее под свои вычислительные ресурсы.

Рассмотрим задачу создания системы машинного обучения, способной определять разницу между изображениями яблок и апельсинов. Сначала разработчику необходимо собрать, пометить и обучить нейронную сеть на тысячах помеченных изображений яблок и апельсинов. С программной стороны алгоритмы проводят статистический анализ и разрабатывают модель для распознавания разницы между двумя классами. Если все идет по плану, обученная модель сможет различать изображения яблок и апельсинов, с которыми она никогда раньше не сталкивалась.

Если все учебные изображения яблок красные и ни одного зеленого, то система машинного обучения может сделать вывод, что «все яблоки красные». Это так называемый индуктивный вывод – открытая гипотеза, основанная на имеющихся данных, а не дедуктивный вывод, который логически следует из предпосылки. Учитывая то, как обучалась система, зеленое яблоко вообще не будет распознано как яблоко. Таким образом, обучающие наборы данных лежат в основе того, как большинство систем машинного обучения делают выводы. Они служат первичным исходным материалом, который системы ИИ используют для формирования основы своих прогнозов.

Обучающие данные определяют не только характеристики алгоритмов машинного обучения. Они также используются для оценки работы. Подобно породистым лошадям, алгоритмы машинного обучения постоянно соревнуются друг с другом на соревнованиях, чтобы выяснить, какие из них показывают наилучшие результаты при работе с определенным набором данных. Эти эталонные наборы становятся алфавитом, на котором основывается язык общения, когда множество лабораторий из разных стран сходятся вокруг канонических систем и пытаются превзойти друг друга. Одно из самых известных соревнований – ImageNet Challenge, где исследователи соперничают в том, чьи методы наиболее точно классифицируют и обнаруживают объекты и сцены.

Успешные обучающие наборы адаптируют, строят на их основе и расширяют. Как мы увидим в следующей главе, возникает своеобразная генеалогия: они наследуют логику обучения от предыдущих примеров, а затем порождают последующие. Например, ImageNet опирается на таксономию слов, унаследованную от лексической базы данных 1980-х годов, известной как WordNet; а WordNet наследует многие источники, включая Brown Corpus из одного миллиона слов, опубликованный в 1961 году.

Учебные базы данных стоят на плечах более старых классификаций и коллекций. Подобно расширяющейся энциклопедии, старые формы остаются, а новые элементы добавляются в течение десятилетий. Таким образом, обучающие данные – это фундамент, на котором строятся современные системы машинного обучения. Они определяют эпистемические границы, регулирующие работу ИИ, и, в этом смысле, создают границы того, как ИИ может «видеть» мир. Однако обучающие данные – это хрупкая форма базовой истины, и даже самые большие массивы данных не могут избежать фундаментальных ошибок, которые возникают, когда бесконечно сложный мир упрощается и нарезается на категории.

Краткая история спроса на данные

«Мир вступил в эпоху дешевых сложных устройств большой надежности; и из этого обязательно что-то выйдет». Так сказал Ванневар Буш, изобретатель и администратор, который руководил Манхэттенским проектом в качестве директора Управления научных исследований и разработок, а позднее участвовал в создании Национального научного фонда. Шел июль 1945 года; бомбы еще не были сброшены на Хиросиму и Нагасаки. У Буша имелась теория о новом виде системы передачи данных, которой еще только предстояло родиться. Он представлял себе «передовые арифметические машины будущего», которые будут работать на чрезвычайно высокой скорости, «выбирать собственные данные и манипулировать ими в соответствии с инструкциями». Но этим устройствам потребуются огромные объемы информации: «У них будет непомерный аппетит. Одна из таких машин будет принимать инструкции и данные от целой комнаты девушек, вооруженных клавиатурами, и каждые несколько минут выдавать листы с вычисленными результатами. В делах миллионов людей, занимающихся сложными задачами, всегда найдется множество вычислений».

Девушки, о которых говорил Буш, – это операторы, выполнявшие повседневную работу по вычислениям. Как показали историки Дженнифер Лайт и Мар Хикс, этих женщин часто воспринимали как устройства для ввода данных. На самом же деле их роль была столь же важна для обработки данных и обеспечения работы систем, как и роль инженеров, проектировавших цифровые компьютеры военного времени. Однако отношения между данными и обрабатывающими машинами уже представлялись как отношения бесконечного потребления. Машины будут жаждать данных, и перед ними, несомненно, откроются широкие горизонты материала, который можно будет извлечь из миллионов людей.

В 1970-х годах исследователи искусственного интеллекта в основном изучали так называемый подход экспертных систем: программирование на основе правил, направленное на сокращение поля возможных действий путем формулирования форм логических рассуждений. Тем не менее довольно быстро стало очевидно, что этот подход является хрупким и непрактичным в реальных условиях, где набор правил редко справляется с неопределенностью и сложностью. Требовались новые подходы. К середине 1980-х годов в исследовательских лабораториях стали использовать вероятностные подходы, основанные на применении грубой силы. Короче говоря, они использовали много вычислительных циклов для расчета как можно большего числа вариантов, чтобы найти оптимальный результат.

Одним из значимых примеров служит группа по распознаванию речи в IBM Research. Проблема распознавания речи решалась в основном с помощью лингвистических методов, но затем теоретики информации Фред Джелинек и Лалит Бахл сформировали новую группу, куда вошли Питер Браун и Роберт Мерсер (задолго до того, как Мерсер стал миллиардером, связанным с финансированием Cambridge Analytica, Breitbart News и президентской кампании Дональда Трампа в 2016 году). Они попробовали кое-что изменить. Их методы в конечном итоге стали предшественниками систем распознавания речи, лежащих в основе Siri и Dragon Dictate, а также систем машинного перевода, таких как Google Translate и Microsoft Translator.

Они начали использовать статистические методы, ориентированные на определение частоты появления слов по отношению друг к другу, вместо того чтобы пытаться научить компьютеры подходу, основанному на грамматических правилах или лингвистических особенностях. Для того чтобы этот статистический подход работал, потребовалось огромное количество реальных речевых и текстовых данных, или обучающих данных. В результате, как пишет исследователь медиа Сяочан Ли, потребовалось «радикальное сведение речи к данным, которые можно моделировать и интерпретировать в отсутствие лингвистических знаний или понимания. Речь как таковая перестала иметь значение». Этот сдвиг оказался невероятно значительным и в результате превратился в шаблон, повторявшийся десятилетиями: сведение контекста к данным, а смысла – к статистическому распознаванию образов. Ли объясняет:

Впрочем, опора на данные, а не на лингвистические принципы, создала новый вид проблем: статистические модели неизбежно определялись характеристиками обучающих данных. В результате их размер стал главной проблемой. Большие наборы данных о наблюдаемых исходах не только улучшают оценки вероятности для случайного процесса, но и увеличивают вероятность того, что данные будут отражать более редко встречающиеся исходы. Размер обучающих данных, по сути, был настолько важен для подхода IBM, что в 1985 году Роберт Мерсер объяснил перспективы группы, просто заявив: «Нет данных лучше, чем больше данных».

В течение нескольких десятилетий такой материал было очень трудно заполучить. Как описывает Лалит Бахл в интервью Ли: «В те времена… невозможно было найти даже миллион слов в читаемом компьютером тексте. Поэтому мы искали его повсюду». Они пробовали технические руководства IBM, детские книги, патенты на лазерные технологии, книги для слепых и даже напечатанную на машинке переписку сотрудника IBM Дика Гарвина, который создал первый проект водородной бомбы. Их метод странным образом перекликался с рассказом писателя-фантаста Станислава Лема, где человек по имени Трурль решает построить машину, пишущую стихи. Он начинает с «восьмисот двадцати тонн книг по кибернетике и двенадцати тысяч тонн самой лучшей поэзии». Но Трурль понимает, что для программирования автономной поэтической машины нужно «повторить Вселенную с самого начала – или хотя бы большую часть».

В конечном итоге группа IBM Continuous Speech Recognition нашла свой «лакомый кусочек». В 1969 году против IBM был подан крупный федеральный антимонопольный иск; разбирательство, в ходе которого было вызвано почти тысяча свидетелей, длилось тринадцать лет. IBM наняла большой штат сотрудников лишь для того, чтобы оцифровать все стенограммы показаний на перфокарты Холлерита. В итоге к середине 1980-х годов был создан корпус из ста миллионов слов. Печально известный антиправительственный журнал Mercer назвал это «случаем полезности, случайно созданной правительством вопреки самому себе».

IBM оказалась не единственной группой, начавшей собирать слова. С 1989 по 1992 год группа лингвистов и компьютерщиков из Университета Пенсильвании работала над проектом Penn Treebank – аннотированной базой данных текстов. Они собрали четыре с половиной миллиона слов американского английского языка с целью обучения систем обработки естественного языка. Их источники включали рефераты Министерства энергетики, статьи из новостной ленты Доу Джонса и сообщения Федеральной службы новостей о «террористической деятельности» в Южной Америке. Появляющиеся коллекции текстов заимствовали из более ранних коллекций, а затем добавляли новые источники. Начали появляться генеалогии коллекций данных, каждая из которых основывалась на предыдущей и часто импортировала те же особенности, проблемы или упущения.

Другой классический свод текстов появился в ходе расследования мошенничества корпорации Enron после объявления ею крупнейшего банкротства в американской истории. Федеральная комиссия по регулированию энергетики изъяла электронную почту 158 сотрудников в целях судебного расследования. Она также решила опубликовать эти электронные письма в Интернете, поскольку «право общества на раскрытие информации перевешивает право человека на частную жизнь». Коллекция получилась необычной. Более полумиллиона фраз повседневной речи отныне можно было использовать в качестве лингвистической шахты, которая, тем не менее, отражала гендерные, расовые и профессиональные различия этих 158 работников. База Enron цитировалась в тысячах научных работ. Но несмотря на ее популярность, ее редко рассматривают с пристальным вниманием: New Yorker описал ее как «канонический исследовательский текст, который на самом деле никто не читал». Такое построение и опора на обучающие данные предвосхитили новый способ работы. Оно изменило область обработки естественного языка и заложило основы того, что станет обычной практикой в машинном обучении.

Семена последующих проблем зарождались именно здесь. Текстовые архивы рассматривались как нейтральные коллекции языка, как будто существует общая эквивалентность между словами в техническом руководстве и тем, как люди пишут коллегам по электронной почте. Весь текст подлежал повторному использованию и замене до тех пор, пока его было достаточно для обучения языковой модели, чтобы с высокой степенью успешности предсказывать, какое слово может следовать за другим. Как и изображения, текстовые корпуса работают на основе предположения, что все обучающие данные взаимозаменяемы. Но язык – это не инертная субстанция, которая действует одинаково независимо от положения. Предложения, взятые из Reddit, отличаются от тех, что составлены руководителями Enron. Перекосы, пробелы и предубеждения в собранном тексте встроены в более крупную систему, и если языковая модель основана на типах слов, сгруппированных вместе, то становится важным, откуда эти слова взяты. Не существует нейтральной языковой среды. Более того, все коллекции текстов также являются свидетельствами времени, места, культуры и политики. Языки, которые имеют меньше доступных данных, не обслуживаются этими подходами и поэтому часто остаются за бортом.

Очевидно, что существует множество историй и контекстов, сочетающихся в учебных данных IBM, архиве Enron или Penn Treebank. Как понять, что является и что не является значимым для понимания этих наборов данных? Как передать предупреждения типа: «База, скорее всего, отражает перекосы, потому что основана на новостях о южноамериканских террористах в 1980-х годах»? Происхождение данных, лежащих в основе системы, может иметь невероятно важное значение, и все же спустя тридцать лет все еще не существует стандартизированной практики, позволяющей отметить, откуда взялись все эти данные или как они были получены, не говоря уже о том, какие предубеждения или классификационную политику они содержат.

Распознавание лиц

В то время как для распознавания речи все больше ценился читаемый компьютером текст, для создания систем распознавания лиц основное внимание уделялось человеческому лицу. Один из центральных примеров появился в последнем десятилетии двадцатого века и финансировался Управлением программы развития технологий борьбы с наркотиками Министерства обороны. Управление спонсировало программу (feret) для разработки автоматического метода идентификации в сфере разведки и правоохранительных органов. До начала программы feret существовало мало обучающих данных о человеческих лицах, только несколько коллекций из пятидесяти или около того снимков, чего, безусловно, недостаточно для масштабного распознавания. Исследовательская лаборатория армии США возглавила технический проект по созданию обучающего набора портретов более тысячи человек в разных позах, чтобы в общей сложности получилось 14126 изображений. Как и коллекция фотороботов NIST, feret стал эталоном – общим измерительным инструментом для сравнения подходов к распознаванию лиц.

Задачи, для решения которых была создана инфраструктура feret, включали, опять же, автоматизированный поиск по фотороботам, а также мониторинг аэропортов и пограничных пунктов, поиск по базам данных водительских прав для «выявления мошенничества» (многочисленные заявления на получение социального обеспечения были конкретным примером, упомянутым в исследовательских работах feret). Существовало два основных сценария тестирования. В первом сценарии алгоритму представлялся электронный журнал известных людей, который должен был найти ближайшие совпадения из большой галереи. Второй сценарий ориентировался на пограничный контроль и контроль в аэропортах: выявление известного человека – «контрабандистов, террористов или других преступников» – из большой популяции неизвестных людей.

Эти фотографии по своему виду являются машиночитаемыми и не предназначены для человеческих глаз, однако они представляют собой замечательное зрелище. Изображения удивительно красивы – фотографии высокого разрешения, сделанные в стиле портрета. На снимках, сделанных 35-мм камерами в Университете Джорджа Мейсона, изображены самые разные люди, некоторые из которых, кажется, одеты по случаю, с тщательно уложенными волосами, украшениями и макияжем. Первая серия фотографий, сделанных в 1993–1994 годах, представляет собой капсулу времени с прическами и модой начала девяностых годов. Испытуемых просили повернуть голову в разные положения; пролистывая изображения, можно увидеть снимки в профиль, фронтальные снимки, разные уровни освещения, а иногда и разные наряды. Некоторые испытуемые фотографировались в течение нескольких лет, чтобы запустить изучение процесса старения. Каждого испытуемого ознакомили с проектом, и он подписал форму разрешения, одобренную университетским советом по этике. Испытуемые знали, в чем они участвуют, и дали полное согласие. В последующие годы такой уровень согласия станет редкостью.

Feret стала высшей точкой формального стиля «сбора данных», до того, как Интернет начал предлагать массовую добычу без каких-либо разрешений или тщательной работы с камерой. Однако даже на этой ранней стадии существовали проблемы, связанные с недостаточным разнообразием собранных лиц. В документе Feret от 1996 года отмечается, что в ходе исследования «поднимались некоторые вопросы о возрастном, расовом и половом распределении базы данных», но «на данном этапе программы ключевым вопросом стала производительность алгоритма на базе данных большого количества людей». В конечном счете feret оказалась чрезвычайно полезной. Поскольку интерес к обнаружению террористов усилился, а финансирование инфраструктур для распознавания лиц распознавания лиц резко возросло после 11 сентября, feret превратилась в наиболее часто используемый эталон. С этого момента биометрические системы слежения и автоматизированного видения стали быстро расширяться в масштабах и амбициях.

От Интернета к ImageNet

Интернет, во многих отношениях, изменил все; он стал рассматриваться в области исследований ИИ как нечто сродни природному ресурсу. По мере того как все больше людей стали загружать фотографии на веб-сайты, в сервисы обмена фотографиями и, в конечном итоге, на платформы социальных сетей, началось самое настоящее разграбление. Обучающие наборы данных достигли таких размеров, которые ученые 1980-х годов и представить себе не могли. Исчезла необходимость устраивать фотосессии с использованием множества условий освещения, контролируемых параметров и устройств для позиционирования лица. Теперь существовали миллионы селфи во всех возможных условиях освещения, положения и глубины резкости. Люди начали делиться своими детскими фотографиями, семейными снимками и изображениями того, как они выглядели десять лет назад – идеальный ресурс для отслеживания генетического сходства и старения лица. Ежедневно публиковались триллионы строк текста, содержащего как формальные, так и неформальные формы речи. Все это служило зерном для мельниц машинного обучения. Для примера: в среднем в день в 2019 году в Facebook было загружено около 350 миллионов фотографий и отправлено 500 миллионов твитов. И это только две платформы, расположенные в США. Сети по всему миру были готовы стать обучающим набором для ИИ.

Титаны технологической индустрии теперь находились в сильной позиции: у них появился конвейер бесконечно обновляемых изображений и текстов, и чем больше людей делились контентом, тем больше росло могущество технологической индустрии. Люди с радостью и бесплатно отмечали свои фотографии именами и местоположением, и этот неоплачиваемый труд привел к получению более точных, маркированных данных для машинного зрения и языковых моделей.

В отрасли эти коллекции имеют высокую ценность. Они являются частной собственностью, которой редко делятся, учитывая как вопросы конфиденциальности, так и конкурентные преимущества. Но те, кто не работает в отрасли, например, ведущие лаборатории компьютерных наук в академических кругах, хотят получить те же возможности. Как собирать данные людей и вручную маркировать их с помощью добровольных участников? Вот тогда-то и зародились новые идеи: объединить изображения и текст, взятые из Интернета, трудом низкооплачиваемых краудворкеров.

Одним из наиболее значимых обучающих наборов в искусственном интеллекте является ImageNet. Впервые он был разработан в 2006 году, когда профессор Фей-Фей Ли решил создать огромный набор данных для распознавания объектов. «Мы решили сделать нечто исторически беспрецедентное, – сказал Ли. – Мы составим карту объектов всего мира». Прорывной исследовательский плакат был опубликован командой ImageNet на конференции по компьютерному зрению в 2009 году. Он открывался таким описанием:

«Цифровая эра породила колоссальный взрыв данных. По последним оценкам, число фотографий на Flickr превышает 3 миллиарда, аналогичное число видеоклипов выгружено на YouTube и еще большее число изображений – в базе данных Google Image Search. Используя эту информацию, можно предложить более сложные и надежные модели и алгоритмы, что приведет к созданию более совершенных приложений для пользователей, позволяющих индексировать, извлекать, организовывать и взаимодействовать с этими данными».

С самого начала данные характеризовались как нечто объемное, неорганизованное, обезличенное и готовое к использованию. По словам авторов, «как именно можно использовать и организовать такие данные – проблема, которую еще предстоит решить». Извлекая миллионы изображений из Интернета, в основном из поисковых систем с помощью опции поиска изображений, команда создала «крупномасштабную онтологию», которая должна была служить ресурсом для «обеспечения критически важных данных для обучения и сравнения» алгоритмов распознавания объектов и изображений. Используя этот подход, ImageNet выросла до огромных размеров. Команда собрала более четырнадцати миллионов изображений из Интернета, которые затем были распределены по более чем двадцати тысячам категорий. Этические проблемы, связанные с получением данных людей, не были упомянуты ни в одной из исследовательских работ команды, даже несмотря на то, что тысячи изображений носили личный и компрометирующий характер.

После того как фотографии были взяты из Интернета, возникла серьезная проблема: кто будет их маркировать и объединять в понятные категории? Как рассказывает Ли, первый план команды состоял в том, чтобы нанять студентов старших курсов за десять долларов в час для поиска изображений вручную и добавления их в набор данных. Но она поняла, что с их бюджетом на завершение проекта уйдет более девяноста лет. Ответ нашелся, когда один из студентов рассказал Ли о новом сервисе: Amazon Mechanical Turk. Как мы видели во второй главе, эта платформа подразумевала возможность привлечения распределенной рабочей силы для выполнения онлайн-задач, таких как маркировка и сортировка изображений, в широких масштабах и по низкой цене. «Он показал мне сайт, и буквально в тот же день мне стало ясно, что проект ImageNet будет реализован, – говорит Ли. – Внезапно мы нашли инструмент, о котором и мечтать не могли: мы наняли студентов старших курсов Принстона». Неудивительно, что выпускники не получили работу.

ImageNet на некоторое время стала крупнейшим в мире академическим пользователем Mechanical Turk, задействовав армию разнорабочих для сортировки в среднем пятидесяти изображений в минуту по тысячам категорий. Существовали категории для яблок и самолетов, аквалангистов и борцов сумо. Но были и жестокие, оскорбительные и расистские ярлыки: фотографии людей классифицировались по таким категориям, как «алкоголик», «человек-обезьяна», «сумасшедший», «проститутка» и «косоглазый». Все эти термины были взяты из лексической базы данных WordNet и предоставлены участникам для сопоставления с изображениями. За десять лет ImageNet превратилась в эталон распознавания объектов для машинного обучения. Подход, при котором массовое извлечение данных без согласия и маркировка осуществлялись низкооплачиваемыми работниками, стал стандартной практикой, и сотни новых обучающих наборов данных последовали примеру ImageNet. Как мы увидим в следующей главе, эти методы и созданные ими маркированные данные в конечном итоге стали преследовать проект.

Конец согласия

В первые годы двадцать первого века произошел отказ от сбора данных по согласию. Помимо отказа от постановочных фотосессий, стала распространяться идея, что содержимое Интернета является их собственностью, не требуя соглашений, подписанных релизов и этических экспертиз. С тех пор начали появляться еще более тревожные практики извлечения информации. Например, в кампусе Колорадо-Спрингс Университета Колорадо профессор установил камеру на главной аллее кампуса и тайно сделал фотографии более 1700 студентов и преподавателей – все для того, чтобы обучить собственную систему распознавания лиц. В рамках аналогичного проекта в Университете Дьюка без ведома учащихся были собраны кадры более двух тысяч студентов, когда они шли с занятий на занятия, а затем результаты появились в Интернете. База данных, названная DukeMTMC (для многоцелевого, многокамерного распознавания лиц), финансировалась Управлением армейских исследований США и Национальным научным фондом.

Проект DukeMTMC подвергся резкой критике после того, как расследовательский проект художников и исследователей Адама Харви и Жюля Лапласа показал, что китайское правительство использует изображения для обучения систем наблюдения за этническими меньшинствами. Это послужило толчком к проведению расследования наблюдательным советом, который решил, что подобный метод – это «значительное отклонение» от приемлемой практики. Набор данных был удален из Интернета.

Но то, что произошло в Университете Колорадо и Дьюке, далеко не единичные случаи. В Стэнфордском университете исследователи заполучили веб-камеру популярного кафе в Сан-Франциско, чтобы получить почти двенадцать тысяч изображений «повседневной жизни оживленного кафе в центре города» без чьего-либо согласия. Снова и снова данные, полученные без разрешения или согласия, загружались для исследователей машинного обучения, которые затем использовали их в качестве инфраструктуры для автоматизированных систем визуализации.

Другой пример – знаковая обучающая база данных MS-Celeb компании Microsoft, которая в 2016 году собрала из Интернета около десяти миллионов фотографий ста тысяч знаменитостей. На тот момент это была крупнейшая в мире публичная база данных распознавания лиц, в которую вошли не только известные актеры и политики, но и журналисты, активисты и художники. По иронии судьбы, некоторые из тех, кто попал в базу без согласия, известны своей работой, критикующей слежку и само распознавание лиц, включая режиссера-документалиста Лору Пойтрас, активистку за цифровые права Джиллиан Йорк, критика Евгения Морозова и автора книги «Капитализм слежки» Шошану Зубофф.

Даже когда наборы данных очищаются от личной информации и публикуются с большой осторожностью, люди повторно идентифицируются, разоблачая детали. Например, в 2013 году Нью-Йоркская городская комиссия по такси и лимузинам опубликовала данные о 173 миллионах индивидуальных поездок на такси, которые включали время заезда и выезда, местоположение, стоимость проезда и размер чаевых. Номера таксистов были скрыты, однако проблема была быстро устранена, что позволило исследователям вывести такую конфиденциальную информацию, как годовой доход и домашний адрес. После объединения с публичной информацией из таких источников, как блоги знаменитостей, удалось идентифицировать некоторых актеров и политиков, а также вывести адреса людей, посещающих стриптиз-клубы. Помимо индивидуального вреда, такие базы данных генерируют «прогнозируемый вред конфиденциальности» для целых групп или сообществ. Например, один и тот же набор данных о такси в Нью-Йорке использовали для того, чтобы предположить, какие таксисты являются мусульманами, наблюдая за тем, когда они останавливаются во время молитвы.

Из любой, казалось бы, безобидной и обезличенной базы может появиться множество неожиданных и очень личных форм информации, однако этот факт не помешал сбору изображений и текста. Поскольку успех машинного обучения зависит от более обширных наборов данных, все больше людей стремятся их получить. Но почему широкое поле ИИ принимает эту практику, несмотря на этические, политические и эпистемологические проблемы и потенциальный вред? Какие убеждения, оправдания и экономические стимулы нормализовали это массовое получение и общую эквивалентность данных?

Мифы и метафоры о данных

В часто цитируемой истории искусственного интеллекта, написанной профессором ИИ Нильсом Нильсоном, изложено несколько основополагающих мифов о данных в машинном обучении. Он хорошо иллюстрирует, как данные обычно описываются в технических дисциплинах: «Огромный объем необработанных данных требует эффективных методов „добычи“ для классификации, количественной оценки и извлечения полезной информации. Методы машинного обучения играют все более важную роль в анализе данных, поскольку они могут работать с огромными объемами. Фактически, чем больше данных, тем лучше».

Вторя Роберту Мерсеру десятилетиями ранее, Нильсон считал, что данные находятся везде, где только можно, и тем лучше для массовой классификации алгоритмами машинного обучения. Это было настолько распространенное убеждение, что оно стало аксиомой: данные существуют для того, чтобы их приобретали, уточняли и делали ценными.

Вместе с тем, корыстные интересы старательно создавали и поддерживали эту веру на протяжении долгого времени. Как отмечают социологи Марион Фуркад и Киран Хили, предписание собирать данные исходило не только от специалистов по сбору данных, но и от их институтов и технологий:

Институциональная команда, исходящая от технологии, является самой мощной из всех: мы занимаемся этими задачами, потому что мы можем… Профессионалы рекомендуют, институциональная среда требует, а технология позволяет организациям собирать как можно больше индивидуальных данных. Неважно, что собранные объемы могут значительно превышать возможности воображения или аналитической хватки компании. Предполагается, что в конечном итоге они окажутся полезными, т. е. ценными… Современные организации как в культурном плане руководствуются императивом данных, так и располагают новыми инструментами для его реализации.

Это породило своего рода моральный императив сбора данных, независимо от возможных негативных последствий. За сомнительной верой в то, что «больше – значит лучше», стоит глубокая идея: человека можно понять, когда будет собрано достаточно разрозненных данных. Но что считается данными?

Историк Лиза Гительман отмечает, что каждая дисциплина и институт «имеют свои собственные нормы и стандарты для воображения данных». В двадцать первом веке данные стали всем, что можно собрать.

Такие термины как «извлечение данных» и фразы типа «данные – это новая нефть» являются частью риторического хода, который сместил понятие данных с чего-то личного, интимного или подлежащего индивидуальному владению и контролю на что-то более инертное и нечеловеческое. Данные стали описывать как ресурс, который нужно потреблять, поток, который нужно контролировать, или инвестиции, которые нужно использовать. Выражение «данные как нефть» стало общепринятым, и хотя оно наводит на мысль о сыром материале, его редко используют, чтобы подчеркнуть издержки нефтяной и горнодобывающей промышленности: подневольный труд, геополитические конфликты, истощение ресурсов и последствия, выходящие за рамки человеческих временных масштабов.

В конечном итоге «данные» стали бескровным словом; оно маскирует как их материальное происхождение, так и цели. А если данные рассматриваются как абстрактные и нематериальные, то они легче выходят за рамки традиционного понимания и ответственности за заботу, согласие или риск.

Как утверждают исследователи Люк Старк и Анна Лорен Хоффман, метафора данных как «природного ресурса», который только и ждет, чтобы его добыли, является устоявшимся риторическим приемом, веками используемым колониальными державами. Добыча оправдана, если она происходит из примитивного и «нерафинированного» источника. Если данные представляют как нефть, которая только и ждет, чтобы ее добыли, то машинное обучение стало рассматриваться как процесс ее необходимой очистки. Данные стали также рассматриваться как капитал, что соответствует более широкому неолиберальному видению рынков как первичных форм организации стоимости. Когда человеческая деятельность выражается в цифровых следах, а затем подсчитывается и ранжируется, она функционирует как способ извлечения стоимости. Как отмечают Фуркад и Хили, те, кто имеет правильные сигналы данных, получают такие преимущества, как страхование и более высокое положение на рынке. Те, кто добился высоких результатов в основной экономике, как правило, преуспевают и в экономике, основанной на подсчете данных, в то время как самые бедные становятся объектами самых вредных форм наблюдения и извлечения. Социолог Джэтан Садовски также утверждает, что данные теперь функционируют как форма капитала. Он считает, что такой подход оправдывает цикл постоянно растущего сбора информации: «Таким образом, сбор данных обусловлен вечным циклом накопления капитала, который, в свою очередь, заставляет капитал строить мир, где все состоит из данных, и полагаться на него». Предполагаемая универсальность данных преобразует любые процессы в область действия капитализма. Если вселенная воспринимается как потенциально бесконечный запас информации, то это означает, что накопление и циркуляция данных может поддерживаться вечно.

Это стремление к накоплению и циркуляции является мощной идеологией, лежащей в основе данных. Массовое извлечение – это «новая граница накопления и следующий шаг капитализма», – предполагает Садовски, и это тот основополагающий слой, который обеспечивает функционирование ИИ. Таким образом, существуют целые отрасли, институты и отдельные люди, которые не хотят, чтобы эта граница – где данные находятся в свободном доступе – была поставлена под сомнение или дестабилизирована.

Модели машинного обучения требуют постоянного притока данных для повышения точности. Однако машины никогда не достигают этой точности, что заставляет обосновывать необходимость получения большего количества информации от как можно большего числа людей для подпитки нефтеперерабатывающих заводов ИИ. Это привело к отходу от таких идей, как «субъекты-люди» – концепции, возникшей в ходе дебатов по этике в XX веке, – и к созданию «субъектов данных», скоплений точек информации без субъективности, контекста или четко определенных прав.

Этика на расстоянии вытянутой руки

Подавляющее большинство университетских исследований в области ИИ проводится без какой-либо этической экспертизы. Но если методы машинного обучения используются для принятия решений в таких важных областях, как образование и здравоохранение, то почему они не подвергаются более тщательному рассмотрению? Чтобы понять, нам нужно обратиться к дисциплинам-предшественникам искусственного интеллекта. До появления машинного обучения, науки о данных в области прикладной математики, статистики и информатики не считались формами исследований, проводимыми на людях.

В первые десятилетия развития ИИ исследования с использованием человеческих данных считались минимально опасными. Несмотря на то, что данные в машинном обучении зачастую поступают от людей и предоставляют сведения о их жизни, исследования, использующие полученную информацию, рассматривались скорее как форма прикладной математики с незначительными последствиями для людей. Инфраструктуры этической защиты, такие как университетские институциональные наблюдательные советы (IRBs), на протяжении многих лет принимали эту позицию. Изначально в этом был смысл; IRBs в подавляющем большинстве случаев фокусировались на методах, характерных для биомедицинских и психологических экспериментов, в которых вмешательство несет явные риски для отдельных субъектов. Компьютерная наука считалась гораздо более абстрактной.

Как только ИИ вышел из лабораторных условий 1980-х и 1990-х годов и перешел в реальные ситуации – например, в попытки предсказать, кто из преступников совершит повторное преступление или кто должен получать социальные пособия, – потенциальный вред расширился. Кроме того, этот вред затрагивает как целые сообщества, так и отдельных людей. Однако до сих пор существует убеждение, будто общедоступные наборы данных представляют минимальный риск и поэтому должны быть освобождены от этической экспертизы. Эта идея является продуктом более ранней эпохи, когда было сложнее перемещать данные из одного места в другое и очень дорого их хранить. Эти ранние предположения не соответствуют тому, что происходит в машинном обучении сейчас. Теперь наборы данных легче соединяются между собой, их можно бесконечно перепрофилировать, постоянно обновлять и часто удалять из контекста сбора.

Профиль риска ИИ быстро меняется по мере того, как его инструменты становятся все более инвазивными, а исследователи все чаще получают доступ к данным без взаимодействия с испытуемыми. Например, группа исследователей машинного обучения опубликовала работу, в которой утверждалось, что они разработали «автоматическую систему для классификации преступлений». В частности, их внимание сосредоточилось на том, связано ли насильственное преступление с бандой, что, как они утверждали, их нейронная сеть могла предсказать всего по четырем деталям преступления: оружие, количество подозреваемых, район и местоположение. Для этого они использовали набор данных о преступлениях из Департамента полиции Лос-Анджелеса, который включал тысячи преступлений, помеченных полицией как связанные с бандами.

Данные о бандах, как известно, искажены и изобилуют ошибками, однако исследователи используют ее и другие подобные базы в качестве окончательного источника для обучения прогностических систем ИИ. База данных CalGang, например, широко используется полицией в Калифорнии, и, как показал опыт, имеет значительные неточности. Аудитор штата обнаружил, что 23 процента из сотен проверенных им записей не имели достаточных оснований для включения их в базу. Также там содержалось сорок два ребенка, двадцать восемь из которых попали туда за то, что «признали себя членами банды». Большинство взрослых, включенных в список, никогда ни в чем не обвинялись, но если они попадали туда, исключить их имя было невозможно. Причины внесения могут быть самыми простыми: например, красная рубашка. Из-за таких пустяковых критериев в список часто попадали чернокожие и латиноамериканцы.

Когда исследователи представили свой проект по прогнозированию преступности среди банд на конференции, некоторые слушатели встревожились. Как сообщает Science, вопросы из зала звучали так: «Откуда команда знает, что учебные данные изначально объективные?», «Что происходит, когда кого-то ошибочно называют членом банды?» Хау Чан, ученый-компьютерщик, работающий сейчас в Гарвардском университете, ответил, что он не мог знать, как будет использоваться новый инструмент. «На подобного рода этические вопросы я не знаю, как правильно ответить», – сказал он, будучи всего лишь «исследователем». Один из участников конференции ответил цитатой из сатирической песни Тома Лерера о ракетчике военного времени Вернере фон Брауне: «Когда ракеты взлетают, кого волнует, куда они опускаются?».

Такое отделение этических вопросов от технических отражает более широкую проблему в данной области, когда ответственность за причинение вреда либо не признается, либо рассматривается как выходящая за рамки исследования. Как пишет Анна Лорен Хоффман: «Проблема заключается не только в необъективных наборах данных или несправедливых алгоритмах и непреднамеренных последствиях. Она также свидетельствует о более постоянной проблеме, когда исследователи активно воспроизводят идеи, наносящие ущерб уязвимым сообществам и усиливающие и без того существующую несправедливость». Даже если предложенная гарвардской командой система идентификации бандитизма никогда не будет реализована, разве не был уже нанесен определенный вред? Разве их проект сам по себе не является актом культурного насилия? Отстранение от вопросов этики вредно само по себе, оно закрепляет ложную идею о том, что научные исследования происходят в вакууме, без ответственности за идеи, которые они распространяют.

Распространение вредных идей особенно опасно в наше время, когда ИИ превратился из экспериментальной дисциплины, используемой только в лабораториях, в масштабное тестирование на миллионах людей. Технические подходы могут быстро перейти от докладов на конференциях к внедрению в производственные системы, где вредные предположения могут укорениться, и их трудно отменить.

Методы машинного обучения и науки о данных могут создать абстрактные отношения между исследователями и испытуемыми, когда работа ведется на расстоянии, вдали от сообществ и людей, подверженных риску причинения вреда. Такие отношения исследователей ИИ с людьми, чья жизнь отражается в базах данных, являются давно сложившейся практикой. Еще в 1976 году, когда ученый в области ИИ Джозеф Вейзенбаум написал свою язвительную критику этой области, он заметил, что компьютерная наука уже стремится обойти все человеческие контексты. Он утверждал, что системы данных позволяют ученым в военное время работать на психологическом расстоянии от людей, «которые будут искалечены и убиты системами вооружений, созданными на основе их идей». Ответ, по мнению Вейценбаума, заключается в прямом противостоянии тому, что на самом деле представляют собой данные: «Следовательно, урок заключается в том, что ученый и технолог должен посредством волевых актов и воображения активно стремиться сократить психологические расстояния, противостоять силам, стремящимся отстранить его от последствий действий. Он должен – если так можно сказать – думать о том, что он на самом деле делает».

Вейзенбаум надеялся, что ученые и технологи станут задумываться о последствиях работы и о том, кто может подвергнуться риску. Однако, в области ИИ такой подход не стал стандартом. Вместо этого данные чаще всего рассматриваются как нечто, что можно брать по своему усмотрению, использовать без ограничений и интерпретировать без контекста. В мире практикуется хищническая культура сбора данных, которая носит эксплуатационный и инвазивный характер, и может нанести долгосрочный вред. Кроме того, многие отрасли, учреждения и отдельные лица заинтересованы в поддержании такого колониального отношения – когда данные находятся в свободном доступе, – и они не хотят, чтобы этот процесс подвергался сомнению или как-то регулировался.

Захват общественного достояния

Нынешняя повсеместная культура извлечения данных продолжает расти, несмотря на опасения по поводу конфиденциальности, этики и безопасности. Изучая тысячи наборов данных, которые находятся в свободном доступе для разработки ИИ, я получила представление о возможностях технических систем распознавания, а также о способах отображения мира для компьютеров, крайне редких для человека. Существуют гигантские базы данных, полные селфи людей, татуировок, родителей, гуляющих с детьми, жестов рук, людей за рулем автомобилей, людей, совершающих преступления на камерах видеонаблюдения, и сотен повседневных действий человека, таких как сесть, помахать рукой, поднять бокал или заплакать. Любая форма биоданных, включая криминалистические, биометрические, социометрические и психометрические, фиксируется и заносится в базы данных, чтобы системы искусственного интеллекта могли находить закономерности и делать оценки.

Учебные базы данных поднимают сложные вопросы с этической, методологической и эпистемологической точек зрения. Многие из снимков сделаны без ведома или согласия людей и собраны из таких онлайн-источников, как Flickr, поиск изображений Google и YouTube, или предоставлены правительственными агентствами, такими как ФБР. Эти данные используются для расширения систем распознавания лиц, регулирования тарифов медицинского страхования, наказания водителей, отвлекающихся от управления транспортным средством, а также для создания инструментов предиктивного полицейского контроля. Однако практика извлечения данных проникает все глубже в те сферы человеческой жизни, которые раньше были недоступны или слишком дороги. Чтобы завоевать новые рубежи, технологические компании используют различные подходы. Голосовые данные собираются с устройств, расположенных на кухонных стойках или тумбочках в спальне; физические данные поступают с часов на запястьях и телефонов в карманах; данные о прочитанных книгах и газетах поступают с планшетов и ноутбуков; жесты и мимика собираются и оцениваются на рабочих местах и в аудиториях.

Сбор данных о людях для создания систем искусственного интеллекта вызывает явные опасения в отношении конфиденциальности. Возьмем, к примеру, сделку, которую британский фонд Royal Free National Health Service Foundation Trust заключил с дочерней компанией Google DeepMind, чтобы поделиться данными о пациентах (1,6 миллиона человек). Национальная служба здравоохранения в Великобритании является почитаемым учреждением, которому доверено предоставлять бесплатное медицинское обслуживание для всех, обеспечивая при этом безопасность данных пациентов. Но когда соглашение с DeepMind расследовали, выяснилось, что компания нарушила законы о защите данных, недостаточно информировав пациентов. В своих выводах комиссар отметила, что «ценой инноваций не должно служить разрушение основных прав на частную жизнь».

Однако существуют и другие серьезные проблемы, которым уделяется меньше внимания, чем конфиденциальности. Практика извлечения данных и создания учебных баз данных основана на коммерческом захвате того, что ранее являлось частью общего достояния. Эта особая форма эрозии представляет собой приватизацию исподтишка, извлечение ценности знаний из общественных благ. Набор данных может оставаться общедоступным, но их ценность при этом является частной собственностью. Безусловно, с помощью открытой информации можно сделать много полезного. Но существует социальное и, в некоторой степени, техническое ожидание того, что ценность данных, распространяемых через общественные учреждения и общественные пространства в Интернете, должна возвращаться к общественному благу в других формах пользования. Вместо этого мы видим горстку частных компаний, которые сегодня обладают огромными возможностями для извлечения информации и прибыли из этих источников. Новая золотая лихорадка ИИ состоит в том, чтобы заключить различные области человеческого знания, чувств и действий – все типы доступных данных – в экспансионистскую логику бесконечного сбора. Это превратилось в разграбление общественного пространства.

По сути, практика накопления данных на протяжении многих лет способствовала формированию мощной экстрактивной логики – логики, которая сегодня является основной характеристикой работы в области ИИ. Эта логика обогатила технологические компании с самыми большими массивами данных, в то время как пространство, свободное от сбора данных, резко сократилось. Как предвидел Ванневар Буш, у машин огромные аппетиты. Но то, как и чем их кормят, оказывает огромное влияние на их восприятие мира, а приоритеты их хозяев всегда будут определять способы монетизации этого видения. Рассматривая слои обучающих данных, которые формируют модели и алгоритмы ИИ, мы видим, что сбор и маркировка информации о мире – это социальное и политическое вмешательство, даже если оно маскируется под чисто техническое.

Способ понимания, фиксации, классификации и наименования данных – это, по сути, акт создания и удержания мира. Он имеет огромные последствия с точки зрения функционирования искусственного интеллекта в мире и того, на какие сообщества он оказывает наибольшее влияние. Миф о сборе данных как о благотворной практике в компьютерных науках затушевывать операции власти, защищая тех, кто получает наибольшую выгоду, избегая ответственности за их последствия.