Философия коэволюции нейронных сетей

Нейронные сети – базовая технология искусственного интеллекта и глубокого обучения. Развитие технологии, имитирующей механизм работы человеческого мозга, определяет темп развития искусственного интеллекта и сходно с процессом биологической эволюции.

Конкуренция или сотрудничество? С этими концептуальными проблемами часто сталкивается человечество, но не природа. В последние годы все чаще звучат упоминания концепции коэволюции. Ярким примером являются отношения между данаидой монархом (бабочка монарх) и ваточником.

Закрытая структура ваточника затрудняет распространение пыльцы по ветру, но сок растения привлекает бабочек монарха, которые его опыляют. Гусеницы бабочки питаются молодыми стеблями и листьями, которые защищают их от токсинов пыльцы. Но если гусеницы поглотят чрезмерное количество стеблей и листьев, растение погибнет или мутирует в более закрытую структуру, что воспрепятствует опылению. Некоторые бабочки монарха развивают способность проникать к тычинке. Таким образом, ваточнику и монарху приходится уживаться. Данаида монарх не питается другими растениями, ваточник не приветствует других насекомых. В их отношениях не может участвовать третья сторона. Также в Интернете сосуществуют вирус и антивирусное программное обеспечение, хакерская и антихакерская работа. В настоящее время глубокое обучение применяется в сфере сетевой безопасности, и его эффективность значительно улучшилась по сравнению с прошлыми файерволами. Коэволюция не предполагает выбора между жизнью и смертью. Это совместная эволюция, которая рождается из противостояния.

Искусственный интеллект тоже находится в процессе коэволюции, которая ярко проявляется в тысячах изменений нейронных сетей. Ниже приведем идеи двух новых нейронных сетей.

Противостояние генеративным сетям

Глубокое обучение подразумевает, что входные данные и результаты вывода имеют семантические теги. Для людей это может быть как правильно, так и неправильно. Но многие ученые считают, что неконтролируемое обучение – ключ к будущему развитию. Машина должна научиться самостоятельно выявлять законы из исходных данных. Уже появилось множество методов глубокого обучения в различных условиях, а противостояние превратилось в норму развития Интернета.

Ян Гудфеллоу, изобретатель сети генерации, обучался у Йошуа Бенджио и теперь работает в лаборатории OpenAI Lab, созданной Маском. Известный эксперт по глубокому обучению Ян Ле Кун высоко оценил его сеть генерации, так как она отражает характеристики «эволюции».

Исследования сети были впервые опубликованы Кристианом Сегеди и командой на ICLR2014 (Международная конференция по изучению исследований). В документе представлен обзор примеров. Исследователи намеренно создавали помехи для формирования конечного результата и провоцировали нейронную сеть прийти к ошибочному выводу. Ошибка очевидна для людей, но машина попадала в ловушку неоднократно.

Ян Гудфеллоу, Джонатон Шленс и Кристиан Сегеди в статье «Объяснение и применение смежных примеров» приводят следующий пример:

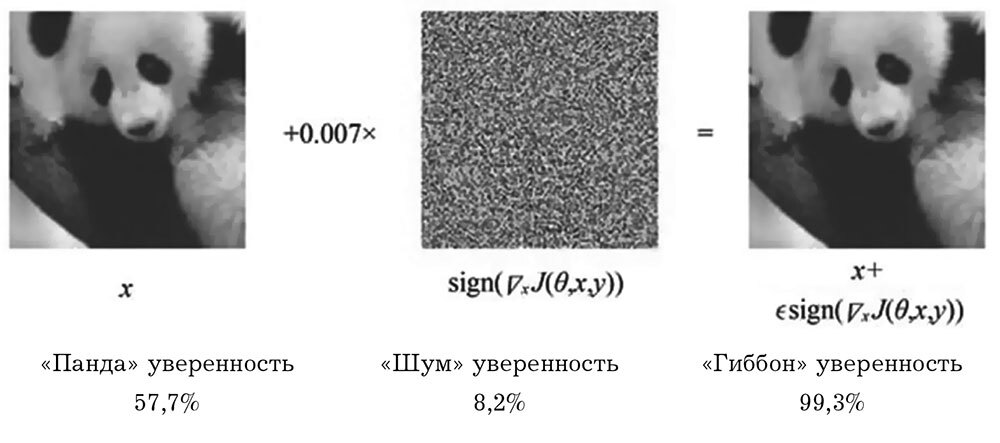

На первом снимке изображена панда и нейронная сеть определяет изображение как панду с уверенностью в 57,7 %.

Затем добавляем помехи на изображение – шум на втором снимке. Модификации выполняются 32-битными значениями с плавающей запятой и не влияют на 8-битное изображение.

Наконец, получаем третью картину. Человеческий глаз не видит разницу между первым и третьим снимком. А нейронная сеть видит гиббона с уверенностью в 99,3 %.

Рис. 9-4. Глубокое изучение образца

Источник: https://arxiv.org/pdf/1412.6572v3.pdf

Поскольку система допускает ошибки распознавания, некоторые люди считают, что система глубокого обучения обладает существенными недостатками. Но Захари Чейз Липтон из Калифорнийского университета в Сан-Диего опубликовал статью в KDNuggets (крупный американский источник) под названием «Глубокие недостатки глубокого обучения» («Deep Learning’s Deep Flaws»), в которой утверждает, что ошибки распознавания в глубоком обучении не уникальны и распространены во многих моделях машинного обучения. Дальнейшие исследования алгоритмов анализа антагонистических образцов будут способствовать развитию всего поля машинного обучения.

Ученые ухватились за хрупкую природу «эволюции» и допускают ошибки в методах обучения, создавая себе препятствия. Эволюция природы очень хрупка. Бесчисленные биологические «программы» устраняются природой ввиду их «ошибочности». Ошибка – это тоже инструмент эволюции.

Генеративная сеть представляет собой нейронную сеть, аналогичную человеческой, которая предназначена для активного создания помех в обучении сети. Состязательная генеративная сеть состоит из двух частей: одна – генератор, а другая – дискриминатор. Генератор похож на спекулянта, который продает поддельные товары, но может и усовершенствовать их в зависимости от условий на рынке. Его задача – найти способы обмануть покупателя (создать образец конфронтации). Дискриминатор должен идентифицировать подлинность товара и на этом опыте снизить вероятность следующего обмана. Обе стороны стремятся к достижению своих целей и взаимосовершенствуются в процессе. Этот процесс похож на боевые учения – противостояние повышает возможности обеих сторон.

Это еще один пример «коэволюции». Философия эволюции заключается не в войне и не в запутанности. Ее суть «поддерживать равновесие без разрушения».

Что более важно в конфронтации – зрелый покупатель или превосходый спекулянт? Для совместной эволюции оба элемента важны в равной степени.

Какая польза от спекулянтов? Мы сталкиваемся с нехваткой данных во многих случаях, но можем дополнить их созданием моделей. Образцы создают видимость контролируемого обучения. Но на самом деле, это обучение не контролируется.

Вэй Ли, Родрих Гросс из британского Университета Шеффилда и Мелвин Гаучи из Гарвардского университета в США разработали новый вид состязательных сетей, основанный на методе Тьюринга для изучения поведения группы. Например, в группу рыб попала представительница другой группы, которая имитирует их поведение. Как судить о достоверности имитации поведения? Используя традиционные методы индукции, трудно выявить определенные характеристики движения группы рыб, так как движения не всегда схожи. Команда поставила перед машиной задачу построить групповую модель поведения объектов и ее имитации. Глубокое обучение задействовало две группы компьютерных программ одновременно – одна отвечала за создание модели поведения группы, другая – за ее имитацию.

Исследователи создали три группы роботов. Первые выполняли сложные движения в соответствии с заданными правилами. Вторые должны были смешаться с первой группой, т. е. изучить их движения и приспособиться к поведению. Третьи – оценщики. Их задача – выявить имитаторов. По мере совершенствования способностей оценщиков будут возрастать и возможности имитаторов. Мы можем использовать этот опыт для создания реалистичной модели имитации группы. Например, обучить модель движениям толпы на популярных праздничных мероприятиях по записям с камер. И спрогнозировать на ее основе движение людей, вероятные аварии и заторы на дорогах.

Эволюция машин в сотни миллионов раз быстрее, чем эволюция природы. В этом виде логика машин выходит далеко за пределы человеческого понимания и может стать «черным ящиком». Как избежать опасности, которую он в себе таит?