Проблемы ИИ

Безусловно, у ИИ есть противники и критики не только среди гражданских, но и внутри военного сообщества. Их подходы отличаются, поскольку одни обеспокоены этической стороной применения ИИ, другие боятся технологических неудач и возможных сбоев, а третьи больше сфокусированы на стратегических решениях.

Конечно же, несмотря на красивый образ войны будущего в теории, на практике могут произойти самые неприятные и банальные вещи:

– ошибка чтения карты;

– ошибка в наборе или считывании пин-кода, включая его блокирование;

– проблемы с сертификатом аутентификации;

– сбои искусственного интеллекта, используемого для военных коммуникаций и боевых роботов. Часто бывает, что рабочая программа не отвечает, а когда она закрывается, то информация не сохраняется. Если сбой произойдет в режиме реального времени и в полевых условиях, скорее всего, произойдет потеря боевой единицы, либо будет произведено ошибочное целеуказание (включая огонь по своим), или отключение канала коммуникации;

– перезагрузка системы (автоматическая или по запросу) в самый неподходящий момент.

Среди сложностей применения ИИ американские специалисты видят препятствия для операций в рамках какого-то альянса, например, НАТО. «На оперативном уровне ИИ может осложнить распределение бремени и совместимость вооруженных сил альянса. Развитие и интеграция технологии искусственного интеллекта в области безопасности ставит три задачи координации во время военных операций альянса. Во-первых, не все государства будут разрабатывать военные приложения ИИ с одинаковой скоростью. В рамках альянса некоторые государства будут обладать и эффективно использовать возможности с поддержкой ИИ, а другие – нет. Такое неравномерное распределение технологий может препятствовать распределению нагрузки и совместимости. Во-вторых, союзники должны будут решить политические и технические проблемы, связанные с разработкой совместимых систем с поддержкой ИИ и обменом данными, которые лежат в основе технологии ИИ. Данными часто трудно делиться, и государства часто не хотят делиться конфиденциальной информацией. В-третьих, противники могут использовать ИИ для срыва военных действий союзников».

10 декабря 2019 г. вышел Федеральный план по исследованию и стратегическому развитию в области кибербезопасности, подготовленный Национальным советом по науке и технологии при президенте США. ИИ в данном документе был обозначен как один из важных приоритетов. При этом отмечаются проблемные аспекты применения ИИ.

Указано, что:

• ИИ влияет на оперативную скорость и масштаб. Системы искусственного интеллекта работают на скоростях и масштабах, превышающих человеческие и текущие технологические возможности. Это вызывает озабоченность в тех областях, где злоумышленные действия с помощью ИИ могут привести к все более асимметричному взаимодействию между злоумышленниками и защитниками, если ИИ также не используется для киберзащиты. В общем, системы ИИ усилят сложную и автоматизированную киберзащиту, и если она не реализована с соответствующими средствами управления, то может также использоваться для совершения злонамеренных действий.

• Интерпретируемость, объяснимость и прозрачность ИИ. Рассуждения, используемые в системах ИИ, сильно отличаются от того, что используется людьми, и не всегда интуитивно понятны людям. Хотя некоторые отдельные алгоритмы, используемые в ИИ, могут быть понятными, их коллективное поведение не всегда является таковым. Следовательно, способность понимать, интерпретировать, объяснять и предвидеть результаты ИИ с прозрачностью сложно. Оценка отклонений в данных или алгоритмах ИИ и защита от их потенциальных отклонений без ущерба для конфиденциальности будет способствовать созданию заслуживающего доверия ИИ, а также повышению точности, отказоустойчивости, безопасности, надежности, объективности и безопасности ИИ. Это поднимает такие вопросы, как моделирование и измерение доверия к системам ИИ, и какими уровнями уверенности следует руководствоваться при развертывании этих типов систем. Это вызывает озабоченность в таких областях кибербезопасности, как ситуационная осведомленность, оценка и управление угрозами и рисками, снижение риска приватности и распределение ресурсов.

• Уязвимость систем с компонентами ИИ. Многие алгоритмы машинного обучения являются субъектами атак на протяжении их жизненных циклов. Следующие виды атак могут иметь место на любой стадии. Хотя уязвимость ИИ и машинного обучения еще не совсем понятна, ее необходимо учитывать при реализации ИИ/машинного обучения. В этом отношении модели угроз для систем ИИ отличаются от традиционных программных и/ или аппаратных угроз.

• Оценка эффективности систем кибербезопасности ИИ. ИИ все больше становится частью технологий, которые являются центральными в нашей повседневной жизни, такие как здравоохранение и транспорт. Границы между кибер, физической, социальной и экономической средами все более размыты. Хотя это приводит к повышению эффективности, это также увеличивает зависимость и увеличивает подверженность естественным, искусственным и программным авариям и угрозам. Это повышает вероятность системных рисков и каскада вреда от угроз в одном домене, перетекающих в другие домены. ИИ вводит больше сложности в дополнение к существующему, недостаточному пониманию эффективности современных технологий кибербезопасности, например, сколько безопасности можно получить, инвестируя в определенные средства управления, и какие средства управления лучше всего снизят риск. Измерение многомерных причинно-следственных связей между средствами контроля безопасности на основе ИИ, уровнями результирующей безопасности и результатами перед лицом угроз является серьезной проблемой.

Также существует мнение, что «такие технологии, как ИИ, требуют значительных инвестиций и изменений, прежде чем они смогут дать результаты. Новые технологии могут поддерживать старые стратегии, но только до тех пор, пока эти старые стратегии не будут оспорены и не потерпят поражение. Соединенные Штаты сохраняют «врожденные» преимущества перед своими оппонентами, хотя растет признание недостатков стратегии; но, глядя на более ранние поколения технических гигантов, нужно признать, что для того, чтобы оставаться конкурентоспособными, скорее нужны новые стратегии, а не новые технологии».

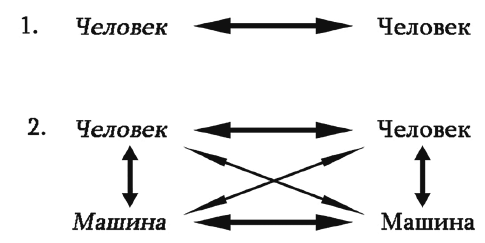

Корпорация RAND в 2020 г. издала исследование, посвященное изучению того, как мыслительные машины влияют на сдерживание. В нем на основе результатов проведенных игр было показано, что действия, предпринятые одной из сторон, которые оба игрока воспринимали как деэскалационные, были немедленно восприняты ИИ в качестве угрозы. Когда игрок-человек выводил силы для деэскалации, машины, скорее всего, воспринимали тактическое преимущество, которое нужно было закрепить; когда человек-игрок двигал силы вперед в явной (но не враждебной) демонстрации решимости, машины имели тенденцию воспринимать неизбежную угрозу и принимали соответствующее решение (рис. 7). В отчете указывалось, что людям приходится сталкиваться с замешательством не только в том, что думает противник, но и с восприятием ИИ противника. Кроме того, игрокам приходилось бороться с тем, как их собственный ИИ может неверно истолковать человеческие намерения (дружеские или вражеские).

Рис 7. Разница в механизмах принятия решений между традиционным сдерживанием и сдерживанием с применением автономных систем ИИ.

По этим и многим другим причинам «туман и трение, вероятно, будут столь же распространены в эпоху мыслящих машин, как и в любое другое время в истории. Военные США должны с большим скептицизмом относиться к любым оптимистичным заявлениям о том, что новые технологии устранят туман войны. Вместо этого, придерживаясь более реалистичного взгляда на то, что туман и трение сохранятся, военные США могут сосредоточиться на обучении своих лидеров, настоящих и будущих, чтобы ориентироваться в растущей сложности и динамичности поля боя, работающего на машинных скоростях. Эти переходы сложны, но они были успешно пройдены ранее. Вкладывая капитал в будущих лидеров и их образование, Соединенные Штаты могут сделать это снова».