Оценивая влияние научной коммуникации

Подходы к оценке

Введение

В повседневном употреблении термин «оценка» применяется в широком разнообразии контекстов, чтобы обозначить акт выражения суждения о какой-либо деятельности. Это естественное проявление, которое, кажется, не требует ни тщательного размышления, ни особых навыков: мы оцениваем, когда решаем, использовать ту или иную технологию, хорошо или плохо выполнил коллега свою работу, понял ли наш собеседник то, что мы хотели сказать.

Оставляя в стороне разнообразие объектов, к которым ее можно применить, оценка означает установление степени, по крайней мере приблизительной, в которой данное действие производит эффект, отвечающий цели, ради которой оно было предпринято. Это определение остается в силе, когда оценка из будничной сферы превращается в набор действий, выполняемых для того, чтобы оценить результаты более сложных и структурированных действий — а также более амбициозных, — чем те, что составляют повседневную рутину. Таким образом мы оцениваем качество образования, влияние на общество конкретного политического решения, качество коммунальных услуг, заявленные преимущества технических средств или эффекты коммуникационной кампании. В этой главе мы дадим обзор оценок программ общественной коммуникации по науке и технике (1).

Потребность в оценке процессов научной коммуникации возрастает вследствие нескольких тенденций. Многие организации изменили свои коммуникационные стратегии, перейдя от «сообщения, предопределенного институционально подтвержденными научными фактами, способствующего созданию пространства для исследования допущений, лежащих в основе оценочных суждений и интересов в конкурирующих определениях риска, принадлежащих разным акторам, вовлеченным в технологическую и экологическую полемику» (Maeseele 2012: 69). Есть и запрос на улучшение общественной коммуникации о науке и обучение с целью улучшения знаний и навыков, необходимых для того, чтобы более эффективно связывать науку и общество (Wehrmann and De Bakker 2012). Улучшение качества коммуникации предлагают рассматривать с помощью системы оценок в рамках «рефлективного цикла» (Stevenson and Rea 2012; ср. McKenzie 2012).

С этой точки зрения оценка становится структурированной и формальной деятельностью, систематичным исследованием, применяющим особые процедуры сбора и анализа информации о содержании, структуре и результатах проекта, программы или планируемой кампании (Guba and Lincoln 1989).

Оценка может также играть политическую роль в поддержке процессов принятия решений и выбора программ и образа действия, стремясь снизить уровень неопределенности (Patton 1986: 14). Поэтому задача оценки — предоставить систематические данные на основе опыта и суждения, снабдив всех участников программы набором вариантов (Weiss 1998). Проще говоря, оценка соотносится с тем, что определяет или объясняет успех либо провал того или иного задуманного и предпринятого действия по отношению к первоначально поставленным целям.

Стадии оценки и выбор

Организация кампании по коммуникации, планирование выставки, публикация материала в СМИ, создание веб-сайта или центра науки — деятельность, связанная с общественной коммуникацией по науке и технике (ОКНТ), развивалась на протяжении долгого времени. Ее оценку можно разделить на три стадии: проектирование (ex-ante), выполнение (in itinere) и завершение (ex-post). Хотя это и явное упрощение, тем не менее такое разделение остается важным средством, чтобы отметить определенные критические аспекты оценки (см. Grant 2011).

На стадии проектирования оценивается соответствие доступных ресурсов поставленным задачам. Производится оценка не только возможных затрат средств, времени и человеческих ресурсов, но также и того, способна ли принятая стратегия коммуникации достичь целевой аудитории. Поэтому критически важным становится знание принципиальных особенностей посредников, включенных в процесс коммуникации (Storksdieck and Falk 2004), и оно также может быть важным для последующей оценки результатов (2).

Оценка in itinere в большой степени соответствует формативной оценке, то есть оценке, направленной на то, чтобы понять, что работает, а что нет, и в ходе текущей деятельности сообразно с этим скорректировать процесс (Scriven 1991). Для этого необходим анализ схемы взаимодействия между участниками, определение препятствий и непредвиденных эффектов, отслеживание использования доступных ресурсов. При оценке in itinere часто применяются контент-анализ и этнографические наблюдения. Предметом оценки может быть, например, ход публичной встречи ученых с представителями общественности — как в случае консенсусной конференции (3) — или то, способствует ли посещение музея или центра науки не только просвещению, но и зарождению новых социальных связей, пробуждению чувств и развлечению (Kotler and Kotler 1998; Storksdieck and Falk 2004) (4). Информация может быть собрана и в ходе самого процесса общения, что дает возможность провести «теоретически обоснованную оценку», то есть «оценку, выводящую на поверхность глубинные допущения о том, почему программа будет работать. В дальнейшем она отслеживает эти допущения на всех стадиях процесса сбора и анализа данных вплоть до окончательных результатов. Оценивается каждая ступень, чтобы понять, действительно ли события, предполагавшиеся программой, имели место» (Weiss 2001: 103; см. также Gascoigne and Metcalfe 2001).

Пример эффективной формативной оценки в коммуникации через интернет относится к интеграции технологии в университетский курс (Bowman 2013). Был запланирован рассчитанный на семестр Wiki-проект, который оценивался с помощью формативного подхода. Оценка показывала будущие структурные и коммуникативные модификации с учетом предложений студентов. Для проверки знания содержания, «лучшего понимания эффективности реальных инструментов с помощью Wiki-проекта, их недостатков и/или проблем» использовалась анкета открытого типа (там же: 4).

Хороший пример формирующей оценки можно найти в Коммуникационном проекте Большого адронного коллайдера, организованном Британским советом по физике элементарных частиц и астрономическим исследованиям. Целью проекта было «привлечь внимание общественности к физике элементарных частиц, разработать четырехлетнюю программу, рассчитанную и на просвещение широкой общественности, и на поддержку физики элементарных частиц, и на поощрение молодежи к выбору курса физики в 16 лет и на последующих сроках принятия решений» (PSP 2006). Оценивались уровни знания и понимания физики элементарных частиц и базовые научные положения, лежащие в основе работы коллайдера. В ходе оценки выяснялось отношение общественности к проекту и задавались вопросы, способствующие улучшению процесса коммуникации. Работа была направлена на две целевые группы: часть широкой публики, интересующуюся наукой, и учащихся и преподавателей. Формативная оценка, полученная на основе работы фокус-групп, интервью, анкеты и обсуждения помогли уточнить методы и содержание коммуникации в ходе выполнения проекта.

Самое очевидное место оценки — в конце процесса коммуникации, т.е. ex-post, поскольку задачей ее является определение и объяснение успеха или провала мероприятия по отношению к целям, которых планировалось достичь. Когда оценка производится по итогам программы ОКНТ и сфокусирована на ее результатах, ее можно назвать суммативной оценкой (в противоположность формативной оценке). Инструментарий суммативной оценки по определению журналистских навыков ученых, проходящих курс подготовки в общественной коммуникации науки, был применен в недавнем исследовании (Baram-Tsabari and Lewenstein 2013). Оценивалась письменная коммуникация в аналитических рамках; целью работы было лучшее понимание навыков, которыми располагают ученые, и выяснилось, что в некотором смысле им необходимо изучить новый язык науки, то есть «дискурс коммуникации науки с обществом» (там же: 80) как средство привлечь внимание общественности.

В суммативной оценке, как правило, различают результат и эффективность (output и outcome). В предыдущем примере результат определялся как эффективное выполнение того, что предполагалось первоначальным планом; таким образом, в привилегированное положение ставилась точка зрения организаторов коммуникации. В последнем случае, напротив, результаты рассматривались как перемены, возникшие в ходе коммуникации, поэтому внимание — по крайней мере потенциально — было направлено на всех участников процесса. Оценка в этих двух случаях может быть противоположной, но, что более важно, хорошие результаты не дают никаких гарантий с точки зрения эффективности.

Прежде чем коснуться проблем, связанных с оценкой программ ОКНТ, мы уделим внимание условиям, которые фактически делают их возможными. Можно отметить определенное расхождение между широко распространенным убеждением о необходимости и пользе оценки и тем фактом, что оценка производится далеко не всегда.

Чтобы оценить программу ОКНТ, необходимо: с самого начала и как можно точнее определить цели этой программы; направить на это существенные ресурсы (деньги, время, персонал); убедиться, что процесс оценки и люди, которые его проводят, гарантируют достаточную легитимность.

Вполне естественно, что те, кто прокручивает тысячи дел и постоянно сталкивается с ситуациями, требующими немедленного решения, сочтет бесполезной тратой время, ушедшее на прояснение того, чтó кто-то надеялся достичь очередной программой в ОКНТ. Можно, однако, подойти и с противоположной стороны: время, первоначально потерянное на точное определение целей, может вознаграждаться по-разному, не в последнюю очередь как прочная основа опыта, который будет получен посредством этой оценки.

Первоначальное определение целей программы и планирование ее оценки также позволяют выделить необходимые ресурсы для процесса оценки без риска того, что этим придется заниматься добровольно и в свободное время. Как и другие виды деятельности, оценка требует денег, времени и труда.

Не следует недооценивать тот факт, что оценка может оказаться утомительной работой, грозящей провалом и ответственностью за провал, особенно когда речь идет о сложных и разнообразных инициативах, таких как программы ОКНТ. Если, кроме того, оценка воспринимается как простая проверка, которой некто подвергает кого-то другого (например, авторы программы — свою целевую аудиторию или их спонсоры — исполнителей проекта), тогда возрастает риск, что она никогда не будет завершена. Оценка — деликатный процесс, и есть множество способов его саботировать.

Учитывая эти особенности, очень важно решить, кто должен производить оценку коммуникационных процессов. Как следует производить оценку, чтобы она была эффективной, — извне или изнутри? Несколько работ утверждают, что внутренняя оценка позволяет развивать уверенность в своих силах, обогащает и развивает навыки разработчиков коммуникационных программ (Irwin 2009; Jensen 2011). Держа это в уме, менеджеры и исполнители проектов оказываются привилегированными игроками, способными проводить анализ и определять подходящие показатели и целевые группы. Оценка, проводимая внутренним персоналом, ведет к эффективному использованию ресурсов, быстрому проведению большей части доступной экспертизы и извлечению преимуществ из стремления улучшать формы коммуникации и экспериментировать с ними.

С другой стороны, оценка извне часто рекомендуется специальными исследованиями в сфере оценивания. Стандартные тексты (например, Rossi et al. 1999) подчеркивают значение использования приглашенного персонала, чтобы обеспечить беспристрастность оценки: внешние оценщики не подвержены влиянию заинтересованных лиц и способны взглянуть на ситуацию со стороны, заметив то, что могут упустить из виду участники процесса. Конечно, внешним оценщикам потребуется больше времени, чтобы разработать план оценки, определить масштаб работы, целевые группы и процессы и результаты, которые надо исследовать.

Решение оценивать коммуникационную деятельность с помощью внутренних или внешних оценщиков в любом случае должно приниматься, исходя из способности оценщиков анализировать коммуникационный процесс и его результаты и давать этому как формативную, так и суммативную оценку, а также из их компетентности как критиков, способных высказать суждения, направленные на улучшение программы. Короче говоря, всем участникам программы следует признать оценку ее интегральной и существенной частью, и это не должно быть предписано свыше, но, насколько это возможно, должно стать итогом согласия между всеми игроками. Ее ценность должна быть очевидна всем участникам, все должны внести вклад в ее выполнение и получить от нее пользу. Допустив формативную (а не просто суммативную) оценку, создав устойчивую обратную связь, которая сосредоточена не только на результатах, мы увеличиваем возможность ее реализации и ее ценность.

Оценка как особый вид социологического исследования

Неслучайно оценку и социологические исследования объединяет ряд ключевых терминов: например, анализ, понимание, измерение, объяснение. Фактически оценка — не что иное, как социологическое исследование, которое проводят в упомянутых выше целях.

Поэтому оценка должна обращаться к эпистемологическим и методологическим проблемам, касающимся социологических исследований в целом. Понятно, что в рамках этой главы невозможно детально рассмотреть эти вопросы. Тем не менее их следует кратко обсудить и выделить аспекты, имеющие особое значение для проведения оценочных исследований.

Рассмотрим, например, программу «Генно-модифицированная нация?» (GM Nation?), реализованную британским правительством в 2002 и 2003 гг. и включавшую самые разные мероприятия — предварительные семинары, специальный веб-сайт, фокус-группы и опрос, выяснявший реакцию участников (36 553 заполненных анкеты). Все это должно было «содействовать инновационной и эффективной программе дискуссий о сельском хозяйстве и окружающей среде в случае возможного коммерческого выращивания ГМ-культур в Великобритании» (PDSB 2003: 11). Главной целью программы было привлечение общественности к принятию важных решений, касающихся регулирования биотехнологий в аграрном и пищевом секторе, а также предоставление общественности информации, необходимой для участия в дебатах.

Все это потребовало крупного вложения средств (приблизительно £1 млн) и вызвало полемику вокруг оценки результатов программы. Смогла ли она обеспечить реальное участие общественности, дать возможность выразить все позиции и определить направление работы законодателей? (5) В ходе полемики был поднят ряд вопросов, например: что подразумевается под участием? Что такое общественность? Как определить репрезентативность позиций? Как и до какой степени можно установить, оказалась ли программа успешной?

Тот факт, что по завершении программы не было достигнуто согласия по этим вопросам, говорит об отсутствии достаточно четкого ex-ante определения ее целей. Очевидно, что все участники преследовали разные цели или придавали разное значение словам, в которых эти цели были сформулированы (Rowe et al. 2005). Иначе говоря, все участники наблюдали — и, следовательно, оценивали — процесс и его результаты с разных точек зрения.

Не существует единственного критерия, с помощью которого можно было бы решить так называемую проблему точки зрения, у каждого решения есть свои за и против. Но именно по этой причине (хотя это все еще остается результатом предпочтений и переговоров) оценочные исследования будут способны опираться на какие-то относительные параметры, с помощью которых можно будет установить, какую точку зрения следует принять. Оценка дает значимые результаты только по отношению к контексту, в котором они были получены — начиная с целей проекта, — а не в абсолютном смысле.

Еще одна методологическая проблема, роднящая оценивание с социологическими исследованиями, связана с оппозицией количественных методов (главным образом опросов со стандартизированными анкетами) и качественных (дискурсивные интервью, этнографические наблюдения, фокус-группы и т.д.). Прежние методы отдавали предпочтение типу отношений исследователя и наблюдаемого феномена, который можно определить как беспристрастность, нейтральность и разделение; более поздние подчеркивают включение, непосредственные связи и род конструктивного взаимодействия (6).

Тем не менее, если мы взглянем на список оценочных исследований, мы ясно увидим, что жестко противопоставлять количественные и качественные методы не слишком продуктивно. Например, при оценке Кембриджского фестиваля науки в 2009 г. приглашенные исследователи использовали и количественный, и качественный методы (Jensen 2009). В этом случае сложность контекста пытались преодолеть, используя «методологическую триангуляцию, и чтобы уравновесить сильные и слабые стороны, присущие тому или другому методу сбора данных, применяли оба метода к одним и тем же темам» (там же: 4). Использование разных инструментов — хорошая стратегия, улучшающая адекватность оценки в соответствии с природой и контекстом коммуникационной программы (Joubert 2007).

В ходе проекта Blast! («Взрыв!») Открытый университет и корпорация Би-би-си подготовили широкий спектр научных программ, способствующих участию общественности в науке. Успешность, с которой каждая программа (подкаст, мероприятие, видео и т.д.) распространяла научные знания, оценивалась с использованием различных инструментов. Смешанные методы способствовали оценке и разработке этих мероприятий (BLAST! 2005).

Британская стратегическая программа по организации музеев и галерей использует другой интересный опыт смешанной оценки. Работу программы оценивали эксперты со стороны, используя сочетание анкет, интервью, осмотров и кабинетных исследований, собирая количественные и качественные данные. В итоговом докладе были представлены и количественные данные, и качественная оценка результатов, проиллюстрированная 13 специальными исследованиями (RCMG 2007).

Мы применили похожую схему при изучении на общеевропейском уровне группы научных организаций, выясняя, изменило ли распространение мероприятий по привлечению общественности повседневную организацию работы научных учреждений (Neresini and Bucchi 2011). На первой стадии использовался опросник количественного характера, далее следовала детальная оценка веб-сайтов организаций. На второй стадии были проведены глубинные интервью качественного характера с четырьмя типами информантов в каждой организации. Такая схема исследования обеспечила широкий анализ ресурсов, процессов и результатов работы по привлечению участия общественности.

Каковы особенности оценки программ по ОКНТ?

Зависимость оценочных исследований от целей программ и рода деятельности, направленной на достижение этих целей, ставит следующие вопросы: отличается ли оценка работы по ОКНТ от оценки других форм деятельности и каково отношение между способами интерпретации ОКНТ и оценкой следующей за ней деятельности? Это не то же самое, что оценка работы по ОКНТ, целью которой является передача знаний, поскольку в рассматриваемом нами случае оценивается то, чья цель — способствовать обсуждению определенной проблемы между разными социальными партнерами. В первом случае результаты в значительной мере предопределены, во втором итоги могут быть открытыми. Если работа по ОКНТ имеет цель вызвать определенное отношение, привести к переменам в поведении и уровне знаний, оценка также должна принимать это во внимание. Существует множество доступных методологий, и их выбор зависит от типа трансформации, который ожидается как результат работы по ОКНТ. Оценка количества и качества перемен влечет за собой методологический выбор и оценочные техники, отличающиеся от оценивания изменений в отношении или поведении.

Интересный случай оценивания в контексте касается использования интерактивного планшета в Гарвардском музее естественной истории (Horn et al. 2012). При изучении взаимодействия между посетителями и медиа использовались видеозаписи и наблюдения. Разработка соответствующего процесса оценивания позволила судить о характере взаимодействия и способности посетителей к сотрудничеству. Процесс также позволил усовершенствовать сами применяемые инструменты оценки.

Фокусируя внимание на объекте оценки, можно соединить между собой различные цели программ по ОКНТ, разные виды коммуникации, продвигаемые с их помощью, и их оценку. Деятельность, в основном посвященная передаче знаний или убеждения общественности, будет оцениваться с точки зрения тех перемен, которые она производит в данной группе. Если же цель также состоит в поддержке диалога или участия общественности, участвующие в работе по коммуникации сами оказываются объектами наблюдения. Так случилось, например, с проектом BIOPOP, в ходе которого молодые европейские биотехнологи разрабатывали инновационные модели рассказа о различных биологических дисциплинах во время фестивалей в Болонье (Италия) или Дельфте (Нидерланды). В шатрах, установленных на главных площадях этих городов, молодые ученые говорили с людьми о биотехнологии, начиная с самых простых приемов вроде приглашения посмотреть в микроскоп, поиграть в компьютерные игры и собрать модель органических молекул (см.: www.biopop-eu.org). Поскольку задачи проекта концентрировались на диалоге, при оценке следовало принимать во внимание не только эффекты участия широкой публики в мероприятиях, но также и то, какой эффект это оказывает на молодых ученых, занятых в проекте.

При оценке серии консенсусных конференций в Нидерландах в 1994–1995 гг. в расчет принималось, с одной стороны, влияние на участников с точки зрения знаний и отношения, с другой стороны — на политиков (Mayer et al. 1995). Такая методика позволила собрать данные о неожиданных эффектах, как в случае конференции граждан по генетической диагностике, проводившейся в 2001 г. в Дрездене немецким Музеем гигиены:

Результаты в целом были позитивными, хотя политики и ученые остались не удовлетворены итогом конференции: участники не только не согласились с некоторыми диагностическими техниками, но стали относиться к ним еще более критически (Storksdieck and Falk 2004: 100–101).

И все же оценка работы по ОКНТ, направленной на диалог и участие общественности — даже если приходится иметь дело с широким спектром разных функций, — часто обнаруживает интересные проблемы, относящиеся не только к общественности (Joss and Durant 1995; Rowe and Frewer 2004).

Оценка эффектов коммуникации

В коммуникации есть парадоксальные черты, также демонстрируемые другими аспектами повседневной жизни, если взглянуть на нее глазами социолога. Хотя коммуникация — это практика, определяющая отношения в обществе, а также индивидуальный опыт и хотя она была предметом многочисленных исследований, это все еще весьма непонятный феномен. Например, до сих пор нет общепринятого определения коммуникации вообще и ОКНТ в частности (Bucchi 2004). Как бы мы ни определяли коммуникацию, всегда есть некоторое согласие в том, что это процесс, способный породить изменения в людях, которые в нем участвуют (7). Это вызывает интригующий вопрос: когда мы можем сказать, что коммуникация произошла? Ответ весьма прост: когда мы можем сказать, что что-то изменилось в участниках коммуникационного процесса. Это особенно важно в отношении оценки. Ведь если коммуникация производит перемены, тогда целью оценки должно быть установление степени и природы этих перемен.

Присущая коммуникации способность производить перемены в тех, кто в ней участвует, делает понимание ее эффектов особенно важным и интересным. И неслучайно проблема эффектов коммуникации привлекает пристальное внимание ученых, изучающих массмедиа: «если нужно назвать только одну проблему, вдохновляющую изучение медиа, то это проблема “эффектов”» (Jensen 2002: 138). В самом деле, все ученые, интересующиеся социальными взаимодействиями — на микро- и на макроуровне, — рано или поздно сталкиваются с этой проблемой.

Если и есть какая-то надежда на успех в оценке эффектов коммуникации, то следует иметь представление — общее и поэтому далеко не точное — о том, каких произведенных коммуникацией перемен можно ожидать. Как указано выше, обычно они группируются вокруг знания, отношения или поведения.

Различие между тремя этими типами изменений далеко не однозначно. Может показаться довольно очевидным, что перемены на уровне знаний связаны с обучением (теперь я знаю, что молекула воды состоит из двух атомов водорода и одного атома кислорода); в то же время ясно, что изменение способа понимания данного аспекта нашего опыта — в сущности, изменение способа, которым мы выражаем суждения, — относится к уровню отношения или точки зрения (вопреки тому, что я думал раньше, теперь я считаю, что ученые — ответственные люди), а если я начинаю делать что-то, чего не делал раньше (смотреть программы о науке по телевидению, ходить в научное кафе, поддерживать своего ребенка в стремлении записаться на курс естественных наук), то это уже связано с уровнем поведения. Как бы то ни было, обучение не сводится только к получению информации; оно также связано с переменами в наших схемах интерпретации (когнитивных моделях) смысла критериев, на которых мы основываем свои суждения. Выражение суждения также является формой поведения и включает определенный набор знаний, а выполнение действий имеет мотивационное измерение, состоящее из убеждений, компетенций и знания (Michael 2002).

Хотя эти определения вызывают серьезные сомнения, как и реальность приведенной выше классификации, все же полезно различать изменения на уровне знаний, убеждений и поведения, когда речь идет об оценке коммуникации.

Определение и понимание этих трех типов изменений вызывает несколько иные методологические проблемы. Важен не столько поиск оптимального решения, сколько знание о достоинствах и недостатках каждой применяемой для этого техники. Так, если получение информации может быть измерено с помощью стандартного вопросника, перемены в моделях интерпретации лучше наблюдать, используя более гибкие приемы, такие как глубинные интервью. Этнографическое наблюдение удобно для документирования посетителей центра науки, возможно с использованием теневой техники (см. Fletcher 1999; Sachs 1993). Если же нас интересует перемены в убеждениях, наилучшие преимущества дают фокус-группы.

Однако есть несколько аспектов, которые следует держать в уме. Жесткость стандартизированных анкет вместе с хорошо известной зависимостью респондентов от контекста, в котором используется анкета, и от формулировки вопросов, может внести значительные искажения в данные, используемые для оценки. Разработка дискурсивного интервью во многом зависит от опыта интервьюера и условий, в которых проводится интервью. Данные, полученные посредством фокус-групп, могут отражать, помимо всего прочего, то, как были организованы обсуждения в группах. Все это следует учитывать и в этнографическом исследовании.

Является ли целью ОКНТ стремление передать информацию или установить контакт между учеными и общественностью, главная проблема оценки все та же: как различить изменения, вызванные процессом коммуникации? На первый взгляд, простейшее и самое очевидное решение называется экспериментальной схемой (experimental design), то есть сравнением положения до события коммуникации с положением после него и предположением, что любые наблюдаемые перемены связаны с имевшей место коммуникацией. С этой точки зрения, одна группа участвует в коммуникационном процессе (например, просмотре научно-популярной телепередачи), а другая — нет; если две группы сформированы методом случайного отбора, их возможные отличия, наблюдаемые ex-post, будут считаться следствием опыта коммуникации. Тот же результат может быть получен при сравнении определенных характеристик, скажем, группы, представляющей целевую аудиторию информационной кампании или посетителей центра науки, с контрольной группой, не включенной в процесс. И в этом случае любые изменения могут быть приписаны коммуникации. Например, в ходе коммуникационной кампании, посвященной информированию об опасности сальмонеллы, сравнение такого рода было применено, чтобы измерить эффект на группе людей, которым адресовалась эта кампания (Tiozzo et al. 2011).

Хотя решения на основе экспериментальных схем на первый взгляд привлекательны, они чреваты проблемами, возникающими из-за невозможности привести их в согласие с требованиями, лежащими в основе каждого типа экспериментальных исследований — или квазиэкспериментальных, — а именно соблюсти равные условия (ceteris paribus). Например, если принято решение сравнивать знания (или убеждения, или поведение) посетителей музея науки до и после их визитов, сама работа по сбору данных ex-ante вызовет изменения, возможно, подтолкнув посетителей обратить более пристальное внимание на те части экспозиции, мимо которых они прошли бы в иной ситуации. По этой причине то, что можно наблюдать после выхода посетителей из музея, может вовсе не быть разницей между тем, что они знали до этого, и тем, что они узнали благодаря осмотру экспозиции, но представлять собой разницу между тем, что посетители знали раньше и узнали благодаря тому, что оказались вовлечены в коммуникационный процесс, стимулированный экспозицией и теми вопросами, которые им задавали при входе. Анкетирование или проведение интервью также представляет собой коммуникационный процесс, способный изменить его участников.

Если попытаться преодолеть эту трудность посредством сравнения с контрольной группой в квазиэкспериментальном исследовании, то возникает другая, почти неразрешимая проблема — невозможность подобрать две полностью идентичные или, в более мягкой версии проблемы, достаточно сходные группы, где «достаточно» означает равенство по наиболее релевантным характеристикам, касающимся изменений, которые намерены наблюдать. Посещение веб-сайта научной организации или просмотр научных видео на YouTube имеет немного общего с отношением к науке или знанием теории эволюции, но выслушивание нотаций от родителей, требующих хороших оценок в школе, безусловно к этому относится, хотя едва ли кто-то собирает данные об этом.

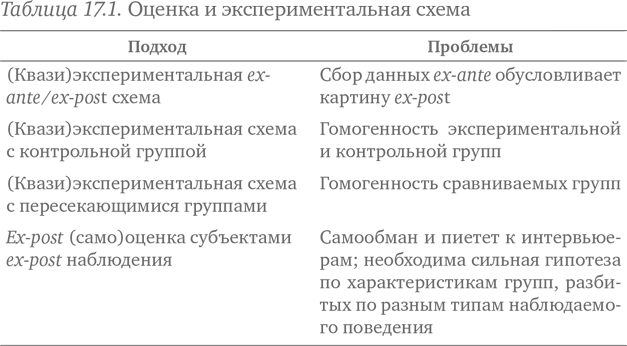

Задача также касается более тонких методологических решений, подобных тем, что отображены в таблице 17.1 в виде квазиэкспериментального исследования с пересекающимися группами, для которого проблема гомогенности сравниваемых групп не решена.

Согласно этому эксперименту, целевая аудитория программы по научной коммуникации — например, учащиеся конкретной школы, — в которой ожидаются изменения параметров A и B, разделяется на две гомогенные группы, состоящие из учеников-четвероклассников (ALPHA и BETA). Перед началом работы анализируется состояние параметров A и B, но для группы ALPHA — только по A, а для группы BETA — только по B. Далее, по окончании работы для группы ALPHA анализируется состояние только параметра B, а для группы BETA — только параметра A. Таким образом становится возможным сравнение положения ex-ante и ex-post применительно к A в двух разных, но гомогенных группах, облегчая задачу приведения к требуемым условиям посредством наложения данных, собранных ex-ante, на данные, полученные ex-post. Однако и в этом случае трудно добиться полной гомогенности сравниваемых групп. Хороший пример такого исследования применительно к оценке работы по ОКНТ — проект IN3B, задача которого — понять эффекты посещения лабораторий и больших научных центров (Neresini et al. 2009).

И вновь, похоже, оптимального решения не существует, даже если отбросить (квази)экспериментальный подход и принять «наблюдение ex-post». Теперь исследователь может не столько сравнивать ситуации ex-ante и ex-post, но и исследовать только параметры ex-post, интерпретируя их как индикаторы изменений, вызванных коммуникацией. В этом случае целевая аудитория — например, учителя, посещающие курс повышения квалификации, — сама производит оценку коммуникационных программ при помощи стандартизированных анкет и глубинных интервью. В обоих случаях, однако, существуют потенциальные проблемы самообмана и пиетета к интервьюерам. Более того, исследователь, определяя любые возможные изменения, вынужден действовать без необходимой точки отсчета (в ситуации ex-ante).

Альтернативный вариант: исследователь может попытаться измерить индикаторы изменений косвенным образом и после этого удостовериться, отличаются ли их значения в разных сегментах выборки, определенных переменными, относящимися к ожидаемым изменениям. Например, отслеживая коммуникационную кампанию, исследователь может проверить индикаторы интереса к нанотехнологии, а затем определить, сильно ли их значения отличаются у лиц с высоким и низким уровнем образования, если другие данные показывают, что уровень образования — это дискриминационная переменная по отношению к интересу к науке. Если менее образованная группа продолжает проявлять мало интереса к науке, а более образованная по-прежнему сильно интересуется, то можно сделать вывод, что коммуникационная кампания не привела к большим изменениям или просто укрепила уже существовавшее отношение. В этом случае главное ограничение заключается в потребности детально знать об отношении между определенными параметрами целевой аудитории и теми параметрами, которые намечено изменить в ходе кампании.

Мы не должны недооценивать трудности, вырастающие из того факта, что по большей части коммуникативные события длятся недолго, хотя мы часто ожидаем, что они вызовут большие перемены в знаниях, убеждениях и поведении. Другими словами, существует явная диспропорция между встречами ученых и широкой публики, даже если такая встреча продолжается целый день, и обретением новых знаний, новых моделей интерпретации и новых привычек. Еще более серьезная диспропорция возникает, когда коммуникационный процесс заключается в просмотре телепередачи, чтении статьи, общении в соцсети или посещении центра науки. Оценка должна учитывать этот аспект (Storksdieck and Falk 2004, Robillard et al. 2013), и знание о факторе времени привело к разработке разных исследовательских стратегий. Наиболее известные из них:

- анализ краткосрочных эффектов, с учетом того, что они очень нестабильны (я многое запомнил, посетив выставку о кварках, но многое ли я вспомню через несколько месяцев?);

- изучение эффектов, вызванных постоянным участием в многочисленных коммуникационных мероприятиях одного и того же типа (эта идея лежит в основе многочисленных исследований долгосрочного воздействия СМИ);

- исследовательские проекты, предусматривающие по крайней мере одно последующее обследование, чтобы определить, какие из зафиксированных краткосрочных изменений все еще наблюдаются некоторое время спустя;

- анализ результатов и выводов в конкретных коммуникативных контекстах: неформальные группы, игры, социальные сети.

Эти заметки не претендуют на то, чтобы определить метод социологических исследований, который был бы всегда применим в оценке. Чего действительно требует оценка, так это адекватного понимания преимуществ и недостатков методологий, с помощью которых можно наблюдать изменения, вызванные коммуникацией. Важно, с одной стороны, не изолировать эффекты коммуникации, а с другой — их причины. Скорее, важно понимание способов, какими они соединяются. В стремлении обнаружить несуществующее оптимальное решение есть серьезная опасность, что от окончательной оценки откажутся, поскольку сочтут ее невыполнимой.

В этом отношении особенно полезным может быть различение последовательной причинности и порождающей причинности. В предыдущем случае — следуя Поусону и Тилли (Pawson and Tilley 1997) — оценка стремится удостовериться, может ли конкретный результат с полным основанием быть приписан данному воздействию, если допустить, что определенное таким образом отношение «причина — эффект» может быть применено к другим ситуациям. В последнем случае вместо этого важно понять, как наблюдаемый результат мог произойти из-за данного воздействия, подчеркивая роль, которую в получении результата играет контекст — конечно, в сочетании с первоначальным воздействием.

Оценка посещения научной организации в день открытых дверей не устанавливает причинной связи между тем, что видели посетители, и изменениями в их знаниях, убеждениях или поведении. Скорее, это может соотнести тип коммуникационного опыта, ставшего возможным в этом контексте, с наблюдаемыми эффектами, если принять во внимание неизбежные недостатки такого наблюдения. Конечно, может выясниться, что наблюдение само по себе, в том смысле, что оно было частью всего коммуникативного процесса во время дня открытых дверей, прямо повлияло на выявленные эффекты.

Заключительные замечания

Несмотря на ограничения, трудности и, возможно, даже противоречия, оценка общественной коммуникации в сфере науки полезна и необходима. Как мы уже говорили, оценка подразумевает, что цели общественной коммуникации в сфере науки должны быть ясными, с уточнением, особенно теми, кто ее продвигает, каких результатов можно ожидать от обоснованной программы. Это означает выявление скрытых предположений, чтобы они могли быть тщательно изучены.

Эти предположения одновременно и необходимы, поскольку устанавливают мотивационную основу деятельности по ОКНТ, и непроверяемы, поскольку продемонстрировать их истинность или ложность невозможно, можно лишь говорить о большей или меньшей их убедительности. Предположения, на которых строится дефицитная модель (знание порождает убеждения, а они определяют поведение), можно легко обнаружить в основании многих коммуникационных программ, даже если в их целях говорится иное, и их можно подвергнуть более тщательному изучению. Это не значит, что, например, общественная коммуникация в сфере науки должна не стремиться к распространению знаний, а лишь вызывать интерес к науке; у такого предположения есть собственные недостатки, и оно не намного лучше дефицитной модели. Оценка не решает проблему раз и навсегда. Так же, как и наука в публичной полемике (Von Schomberg 1995; Grove-White et al. 2000), оценка не может разрубить гордиев узел, связывающий истину и ложь, но может повысить нашу осведомленность о часто парадоксальных эффектах наших действий (Boudon 1977, 1995).

Это не ограничение, а возможность, еще одна хорошая причина применить логику оценки на практике, поскольку оценка есть не что иное, как обучение на опыте, более систематическое и эффективное, чем спонтанное. В последние годы этот практический подход привел научные организации и деятелей науки к быстрому развитию общественной коммуникации в сфере науки, выстроив новые отношения с медиа. Так называемый эффект «медиализации» (Weingart 2012) создал новые способы коммуникации, а ученые освоили новые роли в публичной сфере. Эти перемены требуют новых подходов и особой оценки.

Включение адекватной оценки в программы по ОКНТ позволит решить эти проблемы и подчеркнуть их сильные и слабые стороны, не только снизив риск продвижения в неверном направлении, но также очистив наше понимание от того, что эти программы стремятся достичь (Gammon and Burch 2006). ОКНТ склонна следовать сиюминутной моде, пренебрегая тем, что быстрое распространение похожих программ не обязательно указывает на их успешность и то, что работало в одном контексте, необязательно принесет те же результаты в другом.

Оценка может оказаться очень полезной в качестве защиты от соблазна повторения. Это должно быть особенно эффективно при растущем запросе на участие граждан в науке (scientific citizenship), когда общественная коммуникация в сфере науки становится критически важной для определения общественного блага (например, в проблемах изменения климата или атомных электростанций).

Уточнение границ между реальными ожиданиями и необоснованными надеждами, точное отражение достижений, проверка наших первоначальных допущений — только это может гарантировать, что нынешняя эйфория вокруг общественной коммуникации в сфере науки не приведет нас к разочарованиям из-за неисполнившихся ожиданий.

Ключевые вопросы

- Каковы обязательные условия, гарантирующие, что оценка программы по ОКНТ действительно произведена?

- Какие факторы отличают оценку программ по ОКНТ от оценки других типов коммуникационных программ?

- Приведите пример известной вам программы по ОКНТ. Можете ли вы определить, какие изменения ожидаются и кого они затронут в результате программы?

- Каковы основные методологические проблемы, связанные с суммативной оценкой данной программы ОКНТ? Как эти проблемы можно решить или свести к минимуму?

Примечания

- Новая редакция главы включает ссылки на исследования последних пяти лет и обращает внимание на идущую ныне полемику по такой, например, теме, как разные уровни вовлеченности в коммуникативную деятельность. Объяснение ключевых терминов и стадий оценки поможет читателям следить за обсуждением преимуществ и недостатков разных методов и подходов.

- См. в этом отношении руководство Eng et al. (1999). Эти руководства представляют собой адаптацию тех, что ранее выпускал Национальный институт рака (National Cancer Institute 1989).

- См., например Barnes (1999), Mayer et al. (1995). Обсуждение общих предпосылок оценки программ: Rowe and Frewer (2004).

- Об исследовании см. Piscitelli and Anderson (2000), Persson (2000), Garnett (2002). О значимости контекста, в котором происходит коммуникация, помимо прочего, см.: Falk and Dierking (2000); Schiele and Koster (1998).

- См., например Barbagallo and Nelson (2005), Horlick-Jones et al. (2006), Irwin (2006).

- Поэтому инструменты, применяемые в количественных методах исследования, более стандартизированные; качественные методы, напротив, более гибкие, что позволяет приспосабливать их к конкретной ситуации. См., например, Silverman (2004), Strauss and Corbin (1998).

- См. Bateson (1972), Maturana and Varela (1980), Von Foerster (1981), Watzlawick et al. (1967).

Литература

Baram-Tsabari, A. and Lewenstein, B. V. (2013) ‘An instrument for assessing scientists’ written skills in public communication of science’, Science Communication, 35, 1: 56–85.

Barbagallo, F. and Nelson, J. (2005) ‘Report: UK GM dialogue’, Science Communication, 26, 3: 318–325.

Barnes, M. (1999) Building a Deliberative Democracy: An Evaluation of Two Citizens’ Juries, London: Institute for Public Policy Research.

Bateson, G. (1972) Steps to an Ecology of Mind, New York: Ballantine Books.

BLAST! (2005) Broadcast-Linked Activities in Science and Technology; www.open.ac.uk / science / main / citizen-science / projects / blast.

Boudon, R. (1977) Effets pervers et ordre social, Paris: PUF.

Boudon, R. (1995) Le juste et le vrai. Études sur l’objectivité des valeurs et de la connaissance, Paris: Fayard.

Bowman, S. W. (2013) ‘A formative evaluation of WIKI’s as a learning tool in a face to face juvenile justice course’, Educational Technology Research and Development, 61, 1: 3–24.

Bucchi, M. (2004) ‘Can genetics help us rethink communication? Public communication of science as a “double helix”’, New Genetics and Society, 23, 3: 269–283.

Eng, T., Gustafson, D. H., Henderson, J., Jimison, H. and Patrick, K. (1999) ‘Introduction of evaluation of interactive health communication applications’, American Journal of Preventive Medicine, 16, 1: 10–14.

Falk, J. H. and Dierking, L. D. (2000) Learning from Museums, Walnut Creek: Altamira Press.

Fletcher, J. K. (1999) Disappearing Acts: Gender, Power and Relational Practice at Work, Cambridge, MA: MIT Press.

Gammon, B. and Burch, A. (2006) ‘A guide for successfully evaluating science engagement events’, in J. Turney (ed.) Engaging Science: Thoughts, Deeds, Analysis and Action, London: Wellcome Trust, 80–85.

Garnett, R. (2002) The Impact of Science Centers / Museums on Their Surrounding Communities; www.astc.org / resource / case / Impact_Study02.pdf.

Gascoigne, T. and Metcalfe, J. (2001) ‘The evaluation of national programs of science awareness’, Science Communication, 23, 1: 66–76.

Grant, L. (2011) ‘Evaluating success: how to find out what worked (and what didn’t)’, in D. J. Bennett and R. C. Jennings (eds) Successful Science Communication, Cambridge: Cambridge University Press, 403–422.

Grove-White, R., Macnaghten, P. and Wynne, B. (2000) Wising Up: The Public and New Technologies, Research report, CSEC, Lancaster: Lancaster University.

Guba, E. and Lincoln, Y. (1989) Fourth Generation Evaluation, Newbury Park CA: Sage.

Horlick-Jones, T., Walls, J., Rowe, G., Pidgeon, N., Poortinga, W. and O’Riordan, T. (2006) ‘On evaluating the GM Nation? public debate about the commercialisation of transgenic crops in Britain’, New Genetics and Society, 25, 3: 265–288.

Horn, M. S., Leong, Z. A., Block, F., Diamond, J., Evans, E. M., Phillips, B. and Shen, C. (2012) ‘Of BATs and APEs: an interactive tabletop game for natural history museums’, in Proceedings of the ACM Conference on Human Factors in Computing Systems CHI’12. ACM Press, 2059–2068.

Irwin, A. (2006) ‘Public deliberation and governance: engaging with science and technology in contemporary Europe’, Minerva, 44, 2: 167–184.

Irwin, A. (2009) ‘Moving forwards or in circles? Science communication and scientific governance in an age of innovation’, in R. Holliman, E. Whitelegg, E. Scanlon, S. Smidt and J. Thomas (eds) Investigating Science Communication In The Information Age: Implications For Public Engagement And Popular Media, Oxford: Oxford University Press, 3–17.

Jensen, K. B. (2002) The Qualitative Research Process. A Handbook Of Media And Communication Research: Qualitative And Quantitative Methodologies, London: Routledge.

Jensen, E. (2009) 2009 Cambridge Science Festival: External Evaluation Report, Cambridge: Anglia Ruskin University.

Jensen, E. (2011) ‘Evaluate impact of communication’, Nature, 469, 7329: 162.

Joss, S. and Durant, J. (1995) Public participation in science: the role of consensus conferences in Europe, London: Science Museum.

Joubert, M. (2007) ‘Evaluating science communication projects’, Scidev.net; www.scidev.net / ms / sci_comm/.

Kotler, N. and Kotler, P. (1998) Museum Strategy and Marketing: Designing Missions, Building Audiences, Generating Revenue and Resources, San Francisco: Jossey Bass.

McKenzie, M. J. (2012) ‘Science communication e(value)ation: understanding best practice’, in M. Bucchi and B. Trench (eds) Quality, Honesty and Beauty in Science and Technology Communication, PCST 2012 Book of Papers, Vicenza: Observa Science in Society, 264–267.

Maeseele, P. (2012) ‘Science communication and democratic debate: friends or foes?’ in M. Bucchi and B. Trench (eds) Quality, Honesty and Beauty in Science and Technology Communication, PCST 2012 Book of Papers, Vicenza: Observa Science in Society, 67–71.

Maturana, H. and Varela, F. (1980) Autopoiesis and Cognition: The Realization of Living, Dordrecht: Riedel.

Mayer, I., de Vries, J. and Guerts, J. (1995) ‘An evaluation of the effects of participation in a consensus conference’, in S. Joss and J. Durant (eds) Public Participation In Science: The Role Of Consensus Conferences in Europe, London: The Science Museum, 201–223.

Michael, M. (2002) ‘Comprehension, apprehension, prehension: heterogeneity and the public understanding of science’, Science, Technology and Human Values, 27, 3: 357–378.

National Cancer Institute (1989) Making Health Communication Programs Work: NIH Publication No. 89–1493, Bethesda, MD: National Institutes of Health.

Neresini, F. and Bucchi, M. (2011) ‘Which indicators for the new public engagement activities? An exploratory study of European research institutions’, Public Understanding of Science, 20, 1: 64–79.

Neresini F., Dimopoulos, K., Kallfass, M. and Peters, H. P. (2009) ‘Exploring a black box: cross-national study of visits effects on visitors to large physics research centers in Europe’, Science Communication, 30, 4: 506–533.

Patton, M. Q. (1986) Utilization-Focused Evaluation, Newbury Park, CA: Sage.

Pawson, R. and Tilley, N. (1997) Realistic Evaluation, London: Sage.

PDSB (2003) GM Nation? The Findings of the Public Debate: Final Report of the GM Public Debate Steering Board, London: Clarity.

Persson, P. E. (2000) ‘Science centers are thriving and going strong’, Public Understanding of Science, 9, 4: 449–460.

Piscitelli, B. and Anderson, D. (2000) ‘Young children’s learning in museums settings’, Visitor Studies, 3, 3: 3–10.

PSP (2006) Formative Evaluation of the LHC Communication Project; www.peoplescienceandpolicy.com / projects / hadron_collider.php.

RCMG (2007) Inspiration, Identity, Learning: The Value of Museums. Second study, Leicester: University of Leicester; www2.le.ac.uk / departments / museumstudies / rcmg / projects / inspiration-identity-learning-2 / IIL.pdf.

Robillard, J. M., Whiteley, L., Johnson, T. W., Lim, J., Wasserman, W. W. and Illes, J. (2013) ‘Utilizing social media to study information-seeking and ethical issues in gene therapy’, Journal of Medical Internet Research, 15, 3: e44.

Rossi, P. H., Freeman, H. E. and Lipsey, M. W. (1999) Evaluation: A Systematic Approach, sixth edition, Thousand Oaks: Sage.

Rowe, G. and Frewer, L. J. (2004) ‘Evaluating public-participation exercises: a research agenda’, Science Technology & Human Values, 29, 4: 512–557.

Rowe, G., Horlick-Jones, T., Walls, J. and Pidgeon, N. (2005) ‘Difficulties in evaluating public engagement initiatives: reflections on an evaluation of the UK GM Nation? public debate about transgenic crops’, Public Understanding of Science, 14, 4: 331–352.

Sachs, P. (1993) ‘Shadows in the soup: conceptions of work and nature of evidence’, The Quarterly Newsletter of the Laboratory of Human Cognition, 15, 4: 125–132.

Schiele, B. and Koster, E. (eds) (1998) La revolution de la muséologie des sciences: vers le musée du XXIe siècle?, Lyon, France: Presses universitaires de Lyon.

Scriven, M. (1991) Evaluation Thesaurus, fourth edition, Thousand Oaks, CA: Sage.

Silverman, D. (2004) Qualitative Research: Theory, Method and Practice, second edition, London: Sage.

Stevenson, E. and Rea, H. (2012) ‘What does quality mean in public engagement of science?’, in M. Bucchi and B. Trench (eds) Quality, Honesty and Beauty in Science and Technology Communication, PCST 2012 Book of Papers, Vicenza: Observa Science in Society, 207–211.

Storksdieck, M. and Falk, J. H. (2004) ‘Evaluating public understanding of research projects and initiatives’, in D. Chittenden, G. Farmelo and B. Lewenstein (eds) Creating Connections, Walnut Creek, CA: Alta Mira Press, 87–108.

Strauss, A. L. and Corbin, J. M. (1998) Basics of Qualitative Research: Techniques and Procedures for Developing Grounded Theory, second edition, Thousand Oaks, CA: Sage.

Tiozzo B., Mari, S., Magaudda, P., Arzenton, A., Capozza, D., Neresini, F. and Ravarotto, L. (2011) ‘Development and evaluation of a risk-communication campaign on salmonellosis’, Food Control, 22, 1: 109–117.

Von Foerster, H. (1981) Observing Systems: Selected Papers of Heinz von Foerster, Seaside, CA: Intersystems Publications.

Von Schomberg, R. (1995) Contested Technology. Ethics, Risks And Public Debate, Tilburg: International Centre for Human and Public Affairs.

Watzlawick, P., Beavin, J. H. and Jackson, D. D. (1967) Pragmatics of Human Communication. A Study of Interactional Patterns, Pathologies and Paradoxes, New York: Norton & Co.

Wehrmann, C. and De Bakker, E. P. H. M. (2012) ‘How to educate and train scientists and science communication students to perform well in science communication activities’, in M. Bucchi and B. Trench (eds) Quality, Honesty and Beauty in Science and Technology Communication, PCST 2012 Book of Papers, Vicenza: Observa Science in Society, 92–95.

Weingart, P. (2012) ‘The lure of the mass media and its repercussions on science. theoretical considerations on the “medialization of Science”’, in S. Rödder, M. Franzen and P. Weingart (eds) The Sciences’ Media Connection: Communication to the Public and its Repercussions. Sociology of the Sciences Yearbook, Dordrecht: Springer, 17–32.

Weiss, C. H. (1998) ‘Have we learned anything new about the use of evaluation?’, American Journal of Evaluation, 19, 1: 21–33.

Weiss, C. H. (2001) ‘Theory-based evaluation: theories of change for poverty reduction programs’, in O. Feinstein and R. Picciotto (eds) Evaluation and Poverty Reduction, Washington DC: World Bank.