Книга: Ценность ваших данных

Назад: Глава 16. Организационные аспекты управления данными

Дальше: Глава 18. Основные тренды будущего

Глава 17. Использование данных и расширение возможностей применения

В главах 10–15 нами были рассмотрены почти все элементы рамочной структуры функций управления данными в привязке к их жизненному циклу (рис. 9.4). Мы сравнили эти элементы с функциональными блоками модели управления цепями поставок (SCOR-модель) и убедились, что схема на рисунке 9.4 вполне отражает модель управления цепочками поставок данных.

Вначале мы подробно остановились на деятельности по осуществлению руководящих и контрольных полномочий в области управления данными – руководстве данными.

Затем был сделан обзор функций, обеспечивающих управление данными на первых двух фазах их жизненного цикла.

1. Планирование и проектирование данных.

2. Обеспечение доступности и обслуживание данных.

Наконец, мы рассмотрели базовые направления деятельности по управлению данными, которые распространяются на весь жизненный цикл информационных активов:

● управление безопасностью данных;

● управление метаданными;

● управление качеством данных.

Все рассмотренные функциональные элементы вносят существенный вклад в цепочку ценности данных и в подготовку информационных активов к ключевой фазе их жизненного цикла – практическому использованию и расширению возможностей применения для достижения целей организации. В этой главе мы остановимся на основных направлениях деятельности в этой фазе, которые играют главную роль в повышении ценности данных и ее извлечении. К ним относятся (см. рис. 9.4):

● использование основных данных;

● бизнес-аналитика;

● наука о данных.

В предлагаемой Дагласом Лейни упрощенной модели цепочки поставок данных перечисленные направления относятся к завершающему этапу цепочки – «Применению» (см. рис. 7.3).

Заметим, что на рисунке 9.4 к фазе использования данных и расширения возможностей их применения отнесена также функция «Управление документами и контентом». Однако у нас (это уже отмечалось в главе 12) она рассматривается в рамках фазы обеспечения доступности и обслуживания, как это сделано в книге Себастьян-Коулман.

Нужно также заметить, что здесь мы не обсуждаем монетизацию данных (хотя она выделена на рис. 9.4), поскольку эта тема очень подробно раскрыта в книге Лейни.

В завершение главы мы поговорим о развитии платформенных решений в области управления данными, играющих важную роль в расширении возможностей их применения.

17.1. Использование основных данных

Вопросы управления основными данными мы довольно подробно рассматривали в главах 12 и 13, здесь лишь еще раз отметим следующее.

Работа с основными данными служит хорошей иллюстрацией того, как использование данных напрямую связано с расширением возможностей их применения. Налаженное управление основными данными позволяет организации лучше понимать особенности объектов и лиц (клиентов, заказчиков, поставщиков, продуктов и т. д.), с которыми она взаимодействует и осуществляет операции.

В процессе своей деятельности организация узнает больше об этих объектах и лицах: что они покупают, что продают, как лучше всего с ними связаться. Новые сведения могут храниться на уровне данных о транзакциях, но организация также должна специально отслеживать и собирать поступающие изменения для поддержания в актуальном состоянии своих основных данных (например, изменения адреса или обновления контактной информации). Транзакционные данные также позволяют им получать дополнительные сведения (например, предпочтения заказчиков или клиентов и истории покупок), которые могут расширить возможности применения основных данных. Взаимосвязи между различными элементами данных и сферами их применения должны учитываться при планировании в любой области управления данными, однако в отношении управления основными данными это предмет особого внимания.

17.2. Бизнес-аналитика

О бизнес-аналитике мы уже немного поговорили в главе 14. Ее инструменты стремительно развиваются и совершенствуются, открывая возможности для перехода от стандартизированной отчетности, диктуемой спецификой используемых информационных технологий, к самостоятельному исследованию данных по направлениям, интересующим бизнес. Можно выделить следующие основные направления развития инструментов BI,.

● Операционная отчетность позволяет выявлять и анализировать краткосрочные (помесячные) и среднесрочные (годовые) тенденции и закономерности. Эти инструменты относятся к сфере тактического бизнес-анализа (Tactical BI) и используются для выработки и принятия краткосрочных решений в сфере оперативного управления бизнесом.

● Управление эффективностью бизнеса позволяет производить формальную оценку измеримых показателей, соответствующих целям организации. Осуществляется, как правило, на уровне высшего руководства. Эти инструменты относятся к сфере стратегического бизнес-анализа (Strategic BI) и используются для формулировки долгосрочных целей и задач.

● Приложения для оперативного анализа предлагают решения для оптимизации различных функциональных областей.

17.2.1. Операционная отчетность

Средства операционной отчетности позволяют генерировать и выводить отчеты непосредственно из транзакционных систем, рабочих приложений или хранилищ данных. Обычно реализуются как функционалы приложений. Очень часто первоначальное применение средств BI – генерирование операционной отчетности, особенно если высокоуровневое распоряжение DW/BI не налажено или в DW содержатся дополнительные по отношению к оперативным или транзакционным данным, учет которых необходим или полезен. Часто операционные отчеты внешне похожи на результаты обработки нестандартных запросов, а на деле представляют собой простые отчеты или вводные для какого-либо рабочего процесса. С точки зрения управления данными ключевым в таких случаях является вопрос о том, достаточно ли приложению собственных данных для генерирования отчета, или же ему требуются еще и дополнительные данные из DW или ODS (см. главу 14).

Инструменты исследования данных и формирования отчетности иногда еще называют средствами создания произвольных запросов, поскольку они позволяют пользователям создавать «авторские» отчеты или выборки данных, предназначенных для использования в качестве вводных другими пользователями или процессами. Строгого соблюдения каких-либо стандартных требований к структуре или формату документа в данном случае не предъявляется, поскольку речь идет не о счетах-фактурах или чем-то подобном. Зато пользователям часто интуитивно хочется включать в такие отчеты графики и таблицы. Зачастую созданные бизнес-пользователями с помощью произвольных запросов отчеты оказываются настолько удачными, что утверждаются в качестве стандартной формы внутриорганизационной отчетности по затрагиваемому в них кругу вопросов.

Требующиеся бизнесу операционные отчеты часто не совпадают с отчетами, генерируемыми по стандартным запросам, которые обычно используют в качестве источника DW или как предназначенную для соответствующего бизнес-подразделения витрину данных. Кроме того, стандартные отчеты обычно разрабатываются ИТ-специалистами, а произвольные – продвинутыми бизнес-пользователями с помощью программных средств построения запросов. При необходимости созданные пользователями запросы и отчеты можно утверждать к регулярному использованию в рамках отдела или всего предприятия.

Производственная отчетность часто выходит за рамки DW или BI и включает запросы к транзакционным системам с целью получения вводных для таких оперативных документов, как счета-фактуры или банковские выписки. Запросы и форматы производственных отчетов обычно разрабатываются ИТ-специалистами.

Традиционные инструменты BI включают ряд стандартных средств наглядного представления данных в виде таблиц, секторных и линейных графиков, столбцов или гистограмм. Помимо статичных форматов визуализации, используемых в отчетах для публикации, возможны также динамические и даже интерактивные форматы в онлайновых отчетах, вплоть до поддерживающих масштабирование, навигацию по уровням детализации и применение фильтров с целью упрощения анализа данных в визуализированном представлении. Может быть предусмотрено также и пользовательское переключение между различными типами графиков или режимами их отображения.

17.2.2 Управление эффективностью бизнеса

Управление эффективностью бизнеса (Business Performance Management, BPM) – это набор интегрированных процессов организации и приложений, разработанных для оптимизации исполнения бизнес-стратегии. Стандартный набор поддерживает формирование бюджета, планирование, бухгалтерский учет и сводную финансовую отчетность. Наработки в этом сегменте имеются огромные, поскольку производители программного обеспечения как для управления предприятием (ERP), так и для BI видят в данной области огромные резервы роста, к тому же грань между бизнес-аналитикой и управлением эффективностью все более стирается. Частота приобретения клиентами решений в области BI и управления эффективностью от одного и того же разработчика зависит от возможностей поставляемых им продуктов.

Технология BPM позволяет приводить процессы в соответствие с организационными целями. Ключевые элементы BPM – измерения и петля положительной обратной связи. В сфере BI это приняло форму множества приложений для различных стратегических областей деятельности предприятия – бюджетного планирования, прогнозирования и планирования ресурсов. Другая специализация BI сформировалась строго внутри этой области и включает создание карт балльной оценки в связке с приборными панелями для интерактивного информирования пользователей. Как и в автомобиле, на приборную панель, находящуюся в поле зрения конечного пользователя, выводится сводка текущих значений важнейших показателей.

17.2.3. Приложения для оперативного анализа

Аналитические приложения работают по принципу извлечения данных из хорошо известных систем, таких как стандартные ERP или модели данных для представления в витринах, и переработки их в предустановленные показатели и форматы для вывода в отчеты или на информационные панели. По сути, бизнесу предлагаются готовые решения для оптимизации различных функциональных областей (например, управления персоналом) или встраивания в отраслевую вертикаль (например, аналитика розничного рынка). Приложения различных типов могут включать функции анализа клиентов, финансов, цепочек поставок, организации производства или управления персоналом.

Как отмечалось в главе 14, cреди приложений для оперативного анализа особо выделяются инструменты онлайновой аналитической обработки (online analytical processing, OLAP), обеспечивающие высокопроизводительную обработку многомерных аналитических запросов. Термин OLAP возник отчасти в противовес термину OLTP, использующемуся для обозначения онлайновой обработки транзакций. Обычно выдача данных в ответ на запросы OLAP происходит в матричном формате. Измерения определяются столбцами и строками матрицы, на пересечении которых выводятся факторы или значения. Концептуально это представление иллюстрируется как куб данных. Многомерный анализ с кубами особенно полезен там, где у аналитиков имеется хорошее представление об общей картине и структуре данных, а разобраться хочется с динамикой и сводной статистикой.

Традиционная область применения OLAP – финансовый анализ, ведь специалисты в этой области привыкли иметь дело со сводными таблицами данных, упорядоченными в рамках хорошо известных иерархий, выискивая и анализируя тенденции и закономерности; а кубы данных позволяют с легкостью переходить на иную шкалу измерений или масштабов даты и времени (годичные, квартальные, месячные, недельные, суточные, почасовые показатели), организационной структуры (мир, регион, страна, отрасль, компания, подразделение) или иерархии продуктов (категория, линия, наименование продукта). Многие пакеты программного обеспечения для BI сегодня используют OLAP-кубы в качестве одной из базовых моделей.

Краткие сведения об основных архитектурах OLAP-систем и принципах организации портфеля BI-приложений приведены в главе 14.

17.3. Наука о данных

В главе 14 был описан процесс осуществления деятельности в области науки о данных. Здесь мы рассмотрим наиболее важные из применяемых учеными по данным методов:

● машинное обучение;

● анализ настроений;

● интеллектуальный анализ данных и текстов;

● предиктивная аналитика;

● предписывающая аналитика;

● методы анализа неструктурированных данных;

● визуализация данных;

● объединение данных.

17.3.1. Машинное обучение

Машинное обучение исследует методы построения алгоритмов, реализованных в программном обеспечении. Можно рассматривать машинное обучение как синтез методов неконтролируемого самообучения (часто называемых извлечением информации – data mining) и методов контролируемого, или управляемого, обучения, которые имеют глубокие математические корни, в том числе из статистики, комбинаторики и оптимизации систем. Начала формироваться и третья ветвь – так называемое обучение с подкреплением без учителя: задаются целевые параметры, и система упражняется в их соблюдении (пример: автопилот транспортного средства). Программирование машин на быстрое усвоение повторяющихся структур запросов и адаптацию к изменениям наборов данных привело к появлению одноименного раздела «машинное обучение» и в области больших данных, где эта концепция получила новое применение. Процессы прогоняются, результаты сохраняются, а затем используются при последующих прогонах для уточненной настройки процесса, и такие итерации повторяются до получения результата желаемого уровня точности и детализации.

Машинное обучение занимается структурным построением алгоритмов познания и усвоения знаний. Выделяют три типа таких алгоритмов.

1. Обучение с учителем основано на применении обобщенных правил (пример: настраиваемый фильтр спама в почтовом приложении).

2. Обучение без учителя основано на выявлении скрытых паттернов, связей, закономерностей (т. е. собственно интеллектуальный анализ данных).

3. Обучение с подкреплением основано на достижении цели (например, выигрыша шахматной партии).

Статистическое моделирование и машинное обучение используют также для автоматизации нереализуемых или слишком затратных процессов в рамках исследовательских и проектных работ, когда требуется, например, методом проб и ошибок подобрать ключ к огромному набору данных, повторяя цикл экспериментальной обработки, анализа результатов и исправления ошибок. Такой подход позволяет значительно ускорить получение ответа, что и стимулирует организации к инициативам по поиску глубинных закономерностей посредством многократного повторения затратно эффективных процессов.

Хотя машинное обучение и использует весьма новые способы получения данных, в этой новой области знания должны соблюдаться все традиционные принципы этичного обращения с данными, в частности и прежде всего – принцип прозрачности. Появились научные доказательства того, что метод обучения нейронных сетей с помощью глубокого погружения работает. Они учатся и постигают мир. Однако не всегда ясны механизмы их обучаемости. Чем сложнее алгоритмы, лежащие в основе этих процессов, тем менее они прозрачны – и начинают функционировать в режиме «черного ящика». Чем больше переменных учитывают самообучаемые нейронные сети и чем более абстрактными делаются сами эти переменные, тем больше реализуемые ими алгоритмы испытывают пределы возможностей человека понимать и интерпретировать логику машинного мышления. Необходимость обеспечения прозрачности принятия решений по мере дальнейшего совершенствования функциональности неконтролируемого самообучения и его применения во все более широком спектре ситуаций, вероятно, будет только возрастать,.

17.3.2. Анализ настроений

Мониторинг медиа и анализ текста относятся к автоматизированным методам извлечения аналитической информации из больших массивов неструктурированных и слабо структурированных данных, включая страницы отзывов, соцмедиа, блоги и новостные веб-сайты. Делается это для того, чтобы понять и обобщить мнения людей и выявить преобладающее в различных социальных группах отношение к брендам, продуктам или услугам, а также любым другим темам или явлениям. Используя алгоритмы обработки естественного языка, синтаксического и лексического разбора предложений или формулировок, средства семантического анализа позволяют выявлять не только доминирующую в высказываниях эмоциональную окраску, но и динамику ее изменения во времени, что открывает возможность предсказывать вероятные сценарии дальнейшего развития событий.

Проиллюстрируем этот подход на простейшем примере поиска и подсчета статистики частоты употребления ключевых слов в опубликованных отзывах о продукте. Если в комментарии присутствуют слова «отличный», «восторг» или «замечательно», вероятно, это позитивный отклик, а присутствие слов «плохой», «дрянь», «гадость» может служить признаком негативного отношения. Распределив отзывы по категориям, можно выяснить преобладающее в целевом сообществе (например, в данной соцсети или блоге) отношение. Но реальные чувства и эмоции, вызываемые предметом обсуждения, не так легко бывает уловить по причине того, что любое ключевое слово, будучи вырванным из контекста, может быть интерпретировано неверно. Например, слово «ужасно» вроде бы указывает на негативное отношение к ресторану, а в отзыве написано: «Ужасно вкусно!» А формально позитивную характеристику «сказочно» можно найти в возмущенном отзыве: «Сказочно нерасторопное обслуживание!» Поэтому семантический анализ эмоциональной окраски должен интерпретировать слова только в контексте. А это уже требует понимания смыслового значения отзыва или комментария. Для правильной интерпретации смысла написанного часто требуются функции обработки естественного языка, реализованные на сегодняшний день лишь в суперсистемах уровня IBM Watson,.

17.3.3. Интеллектуальный анализ данных и текстов

Интеллектуальным анализом данных (или извлечением информации, data mining) принято называть применение к массивам разнородных данных разнообразных алгоритмов выявления скрытых структурных закономерностей. Интеллектуальный анализ данных постепенно отделился от машинного обучения и сделался отдельной подобластью исследований по созданию искусственного интеллекта. Теория интеллектуального анализа данных формально относится к методологии статистического анализа, известной под названием «обучение без учителя», которая предусматривает применение к набору данных неких алгоритмов изучения, никак не связанных с ожидаемым или желаемым результатом. В то время как стандартные средства генерации запросов и отчетов формулируют вполне конкретные требования к данным, средства интеллектуального анализа данных помогают раскрывать неизвестные ранее взаимосвязи через выявление повторяющихся структур (паттернов). Извлечение данных – ключевое направление работ на этапе первичного изыскания возможностей, поскольку позволяет оперативно идентифицировать поддающиеся изучению элементы обрабатываемого массива данных, выявлять ранее неизвестные и уточнять нечеткие или неклассифицированные связи, закладывая структурную основу классификации элементов изучаемых данных.

В сочетании с семантическим и структурно-лингвистическим анализом текстовой информации интеллектуальный анализ данных позволяет автоматически классифицировать данные по признакам их содержания и интегрировать полученные классификации в онтологии, составляемые по мере накопления данных под общим руководством экспертов в предметной области. Таким образом, появляется возможность анализа электронных текстов в различных средах и форматах без их реструктурирования или конвертирования. Накапливаемые онтологии можно подключать к информационно-поисковым системам, что даст пользователям и приложениям возможность получать доступ к этим документам через поисковые запросы.

Извлечение данных и интеллектуальный анализ текстов основаны на использовании ряда стандартных технических приемов, включая описанные ниже.

Профилирование заключается в описании характерных типов поведения людей, групп или организаций и используется для определения признаков нормального поведения с целью выявления серьезных отклонений от нормы, например в приложениях по отслеживанию мошеннических операций или попыток проникновения в системы. Результаты профилирования служат входными данными для многих компонентов, работающих по принципу самообучения.

Сокращение избыточных данных позволяет заменять исходные, излишне детализированные наборы данных обобщенными, где сохраняются лишь ключевые характеристики или категории, что заметно ускоряет и упрощает обработку и анализ.

Ассоциирование часто встречающихся в связке друг с другом элементов – еще один стандартный алгоритм выявления взаимосвязей, применяемый в интеллектуальном анализе данных. Ассоциативные связи могут использоваться, например, для накопления статистики часто встречающихся наборов элементов, выявления скрытых правил, анализа конъюнктуры локальных рынков. А рекомендательные системы в интернете без использования подобных алгоритмов не обходятся.

Кластеризация: группировка элементов в кластеры по признаку близкого сродства или общности неких характеристик упрощает и ускоряет статистический анализ типичных схем и стереотипов поведения. Классический пример кластеризации – сегментация потребительского рынка.

Самоорганизующиеся карты – метод кластерного анализа нейронных сетей, известный также под названием самоорганизующихся карт Кохонена или топологически упорядоченных карт. Их использование позволяет снизить размерность пространства оценки без ущерба для результатов аппроксимации. Устранение избыточных пространственных измерений, отметим, по эффективности не уступает изъятию вырожденных переменных из алгебраических уравнений – и решать проще, и результат нагляднее,.

17.3.4. Предиктивная аналитика

Предиктивной аналитикой называют подраздел обучения с учителем, в рамках которого пользователи пытаются смоделировать элементы данных и предсказать будущие исходы по оцениваемым вероятностям событий. В методах теории вероятностей и математической статистики прогнозная аналитика, однако, имеет много общего с обучением без учителя в части прописывания, например, предельно допустимых отклонений полученных результатов от предполагаемых, после чего требуется пересмотр гипотез.

Таким образом, предиктивная аналитика основана на использовании обычных вероятностных (стохастических) моделей обработки вводных данных (включая исторические) для определения вероятности будущих событий (покупок, ценовых изменений). При получении информации, выходящей за рамки текущей модели, сама же модель и запрашивает у организации порядок дальнейших действий. Фактором запуска может служить любое событие: заказ в интернет-магазине, текст в новостной ленте, образ в системе распознавания лиц, непредвиденный всплеск спроса на услуги. Пусковым моментом могут являться и внешние факторы. Например, появление негативных материалов о компании в СМИ – верный признак скорого снижения биржевых котировок ее акций. А способность прогнозировать динамику биржевых котировок по новостям – отличное функциональное свойство средств аналитики данных с точки зрения игроков на фондовых рынках.

Зачастую превышение критического порога потока каких-либо характерных данных в режиме реального времени (например, биржевых сделок или обращений в экстренную службу) служит причиной для запуска цепи всевозможных последствий в динамично меняющейся и нестабильной среде. Мониторинг потока событийных данных позволяет устанавливать пороги счетчиков критических событий, определяемых в рамках модели и служащих сигналом для выдачи предупреждения или запуска каких-либо действий.

Запас времени, которое остается в распоряжении у получателей сигнала о прогнозируемом событии до фактического наступления этого события, нередко бывает мизерным (вплоть до долей секунды). Поэтому инвестиции в технологии быстрого реагирования (в частности, резидентные базы данных, широкополосные каналы связи и даже физический перенос ЦОД в непосредственную близость к объекту – источнику данных) оправдываются, если позволяют реально повысить способность к прогнозированию и оперативному реагированию на прогноз.

Простейшая модель прогнозирования – статистическая. Существует множество методик статистического прогнозирования, основанных на выявлении тенденций с экстраполяцией или регрессионном анализе, но в любом случае требуется сглаживание. Простейший вариант сглаживания данных реализуется путем расчета скользящего среднего или средневзвешенного значения. В специфических случаях могут применяться более сложные техники сглаживания, такие как расчет экспоненциального скользящего среднего, что позволяет управлять коэффициентом сглаживания (фильтрации флуктуаций). Для начала можно применить один из методов регрессионного анализа – метод наименьших квадратов, но в любом случае требуется несколько пробных прогонов для подбора оптимального коэффициента сглаживания. Существуют модели с двумя и более фильтрами экспоненциального сглаживания, позволяющие учитывать, например, недельные колебания на фоне сезонных,.

17.3.5. Предписывающая аналитика

Предписывающим анализом называют прогнозный анализ, дополненный определениями корректирующих воздействий на ситуацию с целью изменения конечных результатов, а не ограничивающийся простым их прогнозированием. Таким образом, предписывающая аналитика позволяет предсказывать, что случится, когда это случится и по совокупности каких факторов это случится. Будучи способным демонстрировать последствия различных сочетаний решений, предписывающий анализ позволяет моделировать их комбинации с целью максимизации выигрыша или минимизации риска. Методы предписывающего анализа удобны тем, что предусматривают возможность непрерывной подачи на вход скорректированных вводных и перерасчета прогнозов с выдачей скорректированных предписаний. Это повышает и точность прогноза, и результативность предписаний,.

17.3.6. Методы анализа неструктурированных данных

Анализ неструктурированных данных основан на сочетании различных методов анализа текстов, ассоциаций, кластеров и прочих вышеописанных методов обучения без учителя, помогающих кодифицировать большие наборы слабо структурированных данных. Могут использоваться и методы обучения с учителем – например, чтобы задать направление, ориентацию и наставления машинному мышлению на правильный подход к кодированию выявляемых структурных зависимостей – и часто лишь человеческое вмешательство позволяет избежать невнятности формулировок или разрешить неоднозначности.

Значение анализа неструктурированных данных возрастает пропорционально нарастанию их доли в мировом информационном пространстве. Бывает, что анализ какого-либо явления просто невозможен без включения в аналитическую модель неструктурированных данных. Однако анализ неструктурированных данных осложняется необходимостью предварительного отделения интересующих исследователей данных от лишних элементов.

Сканирование и тегирование – единственный способ выуживания полезных неструктурированных данных из озера, позволяющий отфильтровать их от воды и привязать к структурированным данным. Тем не менее тут возникает следующая проблема: какими тегами маркировать данные, не зная заранее их содержания, и как определить условия тегирования? Ответ может быть получен только итерационным путем: по мере выявления реальных условий тегирования уточняются и начинают присваиваться теги, а по мере поглощения и освоения тегированных данных аналитики проверяют правильность условий тегирования, анализируют выловленные данные – и постепенно уточняются и согласуются все условия тегирования и структура тегов, а по мере надобности могут добавляться и новые теги,.

17.3.7. Визуализация данных

Визуализация данных – процесс интерпретации концепций, идей и фактов через наглядные представления, включая фотографии, рисунки, коллажи и всевозможные графики, а также схемы. Визуализация упрощает понимание иллюстрируемых данных, обеспечивая наглядность и лаконичность их сводного (например, графического) представления. Визуализация позволяет предельно сжато и доходчиво отображать наиболее характерные данные с целью навести зрителей на полезные выводы о скрытых возможностях, рисках или смыслах.

Визуальные представления могут быть как статичными (например, в формате иллюстрированного отчета), так и анимированными, динамично обновляемыми и даже интерактивными, т. е. позволяющими конечному пользователю переходить на различные уровни детализации, накладывать фильтры и иным образом упрощать себе визуальный анализ данных. В качестве варианта может предусматриваться и переключение пользователем режима отображения данных в инновационные форматы, такие как интерактивные географические карты и динамические ландшафтные пейзажи данных.

Анализ данных уже давно немыслим без средств визуализации. Все традиционные инструменты бизнес-анализа обязательно включают широкий выбор средств визуального представления данных: таблицы, всевозможные линейные и круговые, плоскостные и объемные, столбчатые и полосчатые графики, гистограммы. С ростом спроса на наглядные данные безостановочно совершенствуются средства их визуализации.

По мере роста зрелости информационной аналитики новые способы визуального отображения данных становятся важным стратегическим преимуществом. Новый взгляд на данные позволяет выявить новые связи и закономерности, а следовательно, и новые возможности для бизнеса. По мере дальнейшего развития и совершенствования средств визуализации организациям придется взращивать такие команды бизнес-аналитиков, которые смогут обеспечивать им конкурентоспособность во все более компьютерно-управляемом в потоковом режиме мире. И вот тогда бизнес-аналитическими отделами будут крайне востребованы эксперты с навыками визуализации – знатоки данных, художники данных, визионеры данных – в дополнение к традиционно ценящимся архитекторам и разработчикам моделей данных. Это будет более чем оправданно, если помнить о рисках, проистекающих от искажающих восприятие обманчивых визуальных представлений,.

17.3.8. Объединение данных

Средства получения данных из различных источников и служб позволяют создавать различные агрегированные представления данных для нужд визуализации или анализа. Многие инструменты виртуализации поддерживают агрегирование через функциональность связывания данных из различных источников объединяющими элементами, т. е., по сути, тем же приемом, который традиционно использовался в реляционных моделях для связывания, к примеру, объекта и описания через внешний ключ. Техническая возможность создания различных данных весьма полезна для получения пользовательских представлений и идеально подходит для реализации задач, которые возникают на фазах раскрытия источников или разведки ресурсов данных, позволяя получать быстрые и наглядные результаты. Этот метод может быть применен в веб-приложении, поскольку позволяет организовывать обмен защищенными нарезками, содержащими персональные или конфиденциальные данные, между поставщиками или провайдерами информационных услуг. В сочетании с алгоритмами обучения искусственного интеллекта такие агрегированные представления помогают выявлять интернет-сервисы, оснащенные интерфейсами с поддержкой обработки естественного языка,.

17.4. Развитие платформенных решений в области управления данными

Если продолжать разговор о расширении возможностей применения данных, то следует сказать о том, что в последние несколько лет наблюдается следующая тенденция: технологические компании переходят от отдельных решений и сервисов к платформенным решениям, т. е. решениям построения технологических экосистем. Это позволяет существенно расширить функциональность своих сервисов и быстро вводить новые услуги для своих абонентов/подписчиков, а также обеспечить сторонним решениям площадку для размещения и доступа сервисов для своих абонентов.

Этот эволюционный путь, основу которому положили такие гиганты, как Apple и Google, развивался все последние годы. Теперь же, с появлением COVID-19, многие технологические компании приняли такой путь как существенное преимущество для своих продуктов и сервисов. Все встали перед сложным выбором: либо оставаться в своей нише и опираться на внешние платформенные решения, что существенно ограничивает возможности развития бизнеса и требует серьезных усилий для борьбы с возрастающей конкуренцией, либо развивать свои экосистемы и платформенные решения, что позволяет быстрее расти, но требует серьезных инвестиций. Помимо этого, при выборе второго подхода очень велик риск того, что без технологичной основы создание цифровых сервисов может стать очень дорогим и даже разорительным.

Речь идет о программном обеспечении, которое предоставляет большое количество услуг и функциональных возможностей в рамках одного продукта, а зачастую предлагает платформу для включения сервисов для внешних разработчиков. Самые известные платформы это Apple iOS, Google Apps для пользовательского сегмента (B2C); SAP, ORACLE, «Юнидата» для корпоративного (B2B). Создание платформенных решений для отдельных продуктов становится существенным конкурентным преимуществом, позволяющим быстро выводить на рынок новые продукты и сервисы, обеспечивать эффективную интеграцию между отдельными решениями и оптимизировать единые требования к стеку используемых технологий.

Платформенные решения также позволяют пользоваться своей богатой функциональностью и уже реализованными сервисами как собственным разработчикам, так и внешним компаниям и специалистам. Одним из значимых преимуществ для новых сервисов при размещении его на платформе является мгновенный доступ к клиентам, уже использующим решение, либо в режиме реального времени, либо при выходе очередного релиза (версии ПО).

Важнейшее преимущество использования платформенных технологий – возможность работать с единым массивом данных, формирующихся во всех функциональных блоках, подсистемах и приложениях. Архитектура сложных платформ может быть сформирована из нескольких функциональных решений и отдельных платформенных решений. Например, решения класса маркет-приложений, помимо той ее части, которая доступна конечному пользователю, включает в себя платежные платформы, платформы разработчиков, платформу управления данными и другие. Стоит отметить, что управление данными во многих решениях становится ключевым конкурентным преимуществом. Более того, введение подобных систем – необходимый критерий существования любой компании на рынке. И роль системы управления данными будет возрастать.

Объем обрабатываемых данных в некоторых платформах только в части критически важных записей (основных данных) уже составляет миллиарды объектов, а объем связанных с ними записей – сотни миллиардов единиц. При этом транзакционных данных обрабатывается на порядки больше, и их привязка к основным данным осуществляется в режиме реального времени (онлайн). Подобный беспрецедентный объем данных предъявляет уникальные технологические, архитектурные, функциональные требования к платформам управления данными, в первую очередь в части полноты, качества и инструментария работы с основными данными, являющимися по сути скелетом работы с данными.

Консолидация данных в подобных объемах позволяет получить значительный синергетический эффект, обеспечивающий большое количество инновационных сервисов, удобство пользовательских интерфейсов, формирование различных цифровых профилей, оптимальную архитектуру решений, технологическую и экономическую эффективность ее модернизации и развития, повышение качества интеграционных процессов и другие преимущества. Вместе с тем широкое распространение платформенных решений уже запустило процесс глобального изменения бизнес-процессов целых отраслей, а в будущем кардинально изменит также и экономическую модель работы многих национальных и международных компаний, что приведет к формированию совершенно новой структуры мировой экономики. Об этом мы более подробно писали в предыдущем разделе.

В качестве очень красноречивого и близкого каждому пользователю мобильных устройств примера рассмотрим возможный сценарий развития магазина приложений, используемых в смартфонах (речь идет об App Store в случае смартфонов под управлением операционной системы iOS и Google Play в случае смартфонов на Android). Компании Apple и Google весьма четко определили модель функционирования своих решений и возможности получения доходов не только от компаний – разработчиков сторонних приложений, оплачивающих размещение своих продуктов, сервисов в магазине приложений и впоследствии работающих в смартфонах в операционных системах, но и с моделью монетизации собственных сервисов. В основу создания собственных сервисов Apple и Google был положен принцип «близости к абоненту», ведь тот кто ближе к пользователю, тот и управляет его потребностями и желаниями.

Более 20 лет назад эта модель бизнеса позволила операторам мобильной связи быстро вытеснить с рынка предоставления услуг связи операторов фиксированной связи, вынудив их активно развивать новые сегменты услуг, в первую очередь телекоммуникационных, используя и модернизируя свои сети, что привело фактически к переходу операторов связи в сегмент предоставления услуг высокоскоростного доступа в интернет для домашних хозяйств и офисов. В то же время многие люди практически полностью перестали пользоваться домашним телефоном, окончательно переведя свое общение на мобильный телефон.

Мобильные операторы связи в конце 1990-х – начале 2000-х годов с учетом технологических ограничений, могли предложить исключительно голосовую связь и короткие СМС-сообщения. По мере развития телекоммуникационных технологий и увеличения скорости передачи данных сети мобильной связи существенно повысили свои возможности, что отразилось в первую очередь на расширении функциональных возможностей абонентских устройств, и постепенно только появившиеся смартфоны вытеснили телефоны сотовой связи. В дальнейшем развитие телекоммуникационных технологий позволило абонентам мобильной связи пользоваться все большим количеством сервисов, которые были доступны посредством версий интернет-браузеров для мобильных устройств. Это время как раз и стало периодом зарождения новой технологической концепции, именно тогда заговорили о том, что телекоммуникационные сети – это фактически трубы для высокоскоростной передачи данных, а производители абонентских устройств становятся гораздо ближе к абоненту.

Именно тогда крупнейшие технологические компании мира (разработчики программного обеспечения, производители смартфонов, телекоммуникационные компании) приступили к активной разработке своих операционных систем для смартфонов, поскольку телекоммуникационные сети уже стали «трубой», а смартфоны ожидало будущее просто «аппаратной абонентской части этой трубы». Сложно оценить объем инвестиций, направленных на создание этих операционных систем, но порядок выделенных средств, вне всяких сомнений, измерялся десятками миллиардов долларов. Столь существенные инвестиции объясняются огромными затратами на всех стадиях исследований и разработок, а также крайне высокой важностью задачи, поскольку для многих компаний речь шла фактически о жизни и смерти или о дальнейшем динамичном развитии на протяжении многих лет, либо стагнации на долгие годы.

В этой крайне дорогой гонке технологий победу одержали компании Apple и Google с той разницей, что iOS установлена исключительно на продукции Apple, а Android используется большинством производителей смартфонов. Конечно, и другие крупные технологические компании не оставили попыток создать свои операционные системы для мобильных устройств, и, возможно, в ближайшем будущем мы станем свидетелями широкого распространения решений, разработанных компаниями Microsoft, Huawei, Samsung, NTT Docomo и других технологических лидеров, но в настоящее время разрыв с двумя лидерами рынка огромен.

Чем же обусловлено такое внимание крупнейших компаний к этой области? Дело в том, что, как мы уже говорили, тенденция, обусловленная принципом «тот, кто ближе к абоненту/пользователю, тот и управляет его потребностями/желаниями», была основным подходом в индустрии, а учитывая темпы развития цифровых технологий и увеличение скоростей передачи данных в сетях мобильной связи, многие люди стали использовать свои смартфоны в качестве инструментария для получения многих онлайн-сервисов, которые ранее были доступны исключительно в офлайн-формате. Сейчас смартфон для многих уже стал платежным средством, навигатором, переводчиком, устройством доступа к социальной сети, агрегатором новостей, инструментом для работы, клиентом почтовых сервисов, средой для получения государственных цифровых сервисов, средством покупки в интернет-магазинах и продвинутым средством общения, а зачастую и игровым устройством. И функциональные возможности благодаря выходу все новых и новых приложений продолжают расширяться. При этом компании продолжают вкладывать значительные инвестиции в развитие своих платформ, расширяя не только технологические и функциональные возможности, но и свое географическое присутствие.

В настоящее время Apple и Google накопили столь значительный опыт и объем данных о своих клиентах и разработчиках, что анализ этих знаний позволяет им оперативно корректировать стратегию развития решений. Эти уникальные знания предоставляют им возможность точечно планировать свои огромные инвестиции в самые востребованные и экономически выгодные сервисы, зачастую подменяя внешние приложения на сервисы, встраиваемые в платформу, такие как приложения, способные собирать различные данные об активности пользователей, медиаприложения, новостные агрегаторы, платежные системы, электронные книги, навигационные сервисы, почтовые клиенты и многие другие. В будущем накопленный объем данных о пользователях, а также возможности инвестирования огромных средств приведет к появлению в платформенных решениях Apple и Google большинства самых востребованных сервисов в виде встроенных возможностей. В самое ближайшее время пользователи мобильных устройств Apple и операционной системы Google смогут отказаться от продуктов онлайн-банков в пользу платежных и банковских приложений Apple и Google. Также два технологических лидера смогут предложить пользователям сервисы такси, электронных магазинов, медиабиблиотек, сервисы бытовых услуг, сферы туризма и гостеприимства, транспорта, аренды различных транспортных средств, покупки и аренды недвижимости, сферы питания и сервисов доставки.

Речь идет о совершенно новом качестве предоставляемых услуг, не имеющих географических границ, совершенно ином уровне удобства пользователей. Все это позволит, с учетом агрегации огромных денежных средств, предоставить уникальную программу лояльности, объединяя все сервисы для каждого конкретного цифрового пользователя, собирая еще больше данных о своих клиентах, обогащая цифровой профиль информацией о предпочтениях пользователей, профиле их потребления, поездках, и многих других аспектах жизни клиентов. Все эти изменения в экономических моделях большинства пользовательских сервисов и переход их к цифровому формату и глобализации приведет к кардинальным изменениям деятельности большинства компаний. Компании, способные уже сейчас перестраивать свою работу, окажутся в более выгодном положении. Одновременно многие компании будут вынуждены прекратить свою деятельность.

В ближайшее время нас также ждет увеличение разрыва между национальными компаниями и глобальными корпорациями практически во всех сферах деятельности: в масштабах исследований и разработок, развития технологических решений и платформ, сфере поглощений и слияний, проведении маркетинговых исследований и программ, выведении на рынок новых продуктов и их развитии, управлении стоимостью решений.

Параллельно стоимость развития высокотехнологических решений будет расти. Однако стоимость создания новых решений на базе платформ существенно ниже обособленных решений, создаваемых фактически с нуля и не опирающихся на ранее созданные технологии платформы. К тому же платформы используют огромный синергетический эффект от консолидации данных различных технологических и функциональных подсистем. Учитывая все это, можно констатировать, что будущие глобальные технологические лидеры – это компании, строящие и развивающие платформенные решения во всех направлениях высоких технологий. В ближайшее время национальные и локальные технологические решения и платформенные системы с большей долей вероятности либо станут неконкурентоспособными и исчезнут, либо станут составной частью глобальных компаний, за исключением уникальных решений, формирующих новые технологические сферы и рынки потребления.

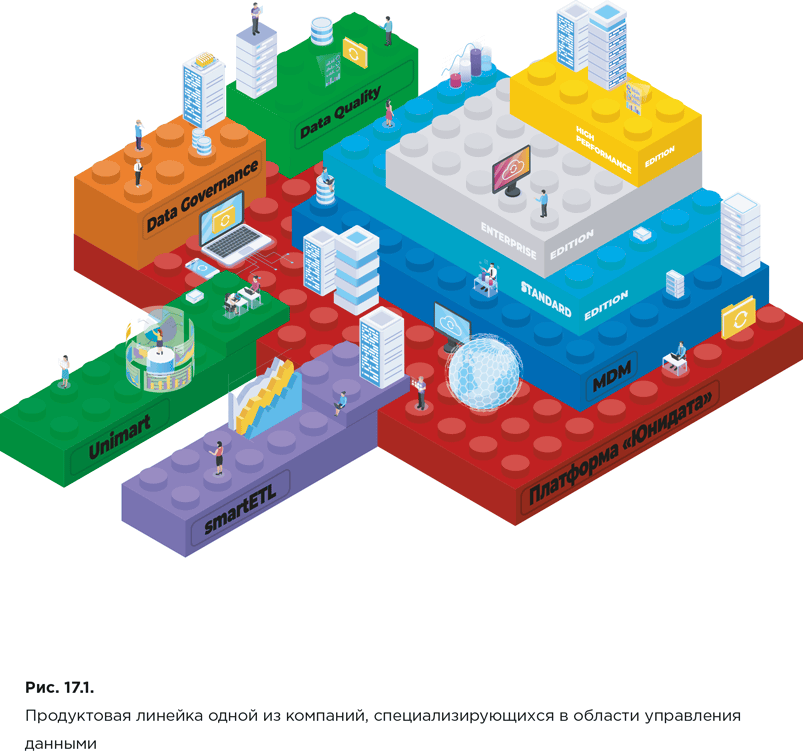

На примере Apple и Google мы уже рассмотрели тенденции, заметные в сегменте продуктов/сервисов для потребителей (B2C). Похожие изменения происходят в сегменте бизнеса для бизнеса (B2B). Для корпоративного сегмента платформы больше напоминают конструктор Lego, где заказчик имеет возможность использовать различные функциональные подсистемы по мере необходимости, расширяя их масштаб, учитывая быстродействие и дополняя новыми подсистемами. В решениях для B2B платформенный слой – важнейшая составляющая, поскольку обеспечивает все подсистемы универсальной и общей для всей системы интеграционной составляющей, инструментарием для работы с данными, базовой аналитикой и другой общесистемной функциональностью. При этом в корпоративных решениях вопросы интеграции как на уровне взаимодействия функциональных подсистем, так и на уровне данных критически важны, они позволяют не только корректно работать функциональным подсистемам, но и обеспечивать качественную работу всей платформы как единого механизма с единым массивом качественных, полных и непротиворечивых данных, едиными для всей платформы бизнес-процессами, единым инструментарием настройки отдельных подсистем и системы в целом.

Еще один основополагающий слой работы современных платформенных решений – инструментарий работы с данными. Более того, в самом ближайшем будущем это, видимо, и станет фундаментом всех без исключения платформ. Именно эта основа позволяет функционировать всей системе, поскольку любая функциональность, даже самая продвинутая, без данных не актуальна, да и любые ошибки в данных в корпоративном сегменте могут привести к катастрофическим последствиям. Во многом по этим причинам роль решений по работе с данными с каждым годом возрастает, и если раньше эту предметную область воспринимали как составную часть крупных ИТ-решений, то сейчас это уже отдельная область знаний, далеко вышедшая за рамки прежних стандартов. Так, большинство глобальных и национальных высокотехнологических компаний, работающих в области корпоративного программного обеспечения, уже предлагают заказчикам решения в области управления данными, среди них такие компании, как IBM, SAP, Oracle, Informatica, «Юнидата» и другие.

По мнению многих аналитиков, в будущем навыки работы с инструментарием по управлению данными станут обязательным требованием большинства работодателей не только для ИТ-специалистов, но и для людей других профессий, поскольку в современном мире практически все так или иначе состоит из данных. В этой области, как и в сегменте B2C, но с небольшим отставанием, заметны те же тенденции усиления конкурентной борьбы и формирование компаний/решений – глобальных лидеров. От платформенных решений, функционирующих на уровне предприятий и корпораций, уже сейчас по большей части зависит эффективность этих организаций, а работоспособность этих систем – один из ключевых критических условий деятельности, поскольку любые существенные неисправности могут привести к огромным потерям, измеряемым как денежными средствами, так и потерей доли рынка, уроном имиджу и другим негативными последствиями, способными привести к краху всего бизнеса.

Сегодня подавляющее большинство крупных международных компаний либо уже работает на основе платформенных решений различной функциональной направленности, либо рассматривает возможность их внедрения. Одной из интересных особенностей последнего времени становится развитие систем, позволяющих размещать в решения вендора отдельные функциональные подсистемы, созданные сторонними компаниями – разработчиками программного и аппаратного обеспечения. Фактически технологические платформы для корпоративного сегмента (B2B) превратятся в решение, составной частью которого будет маркетплейс, аналогичный решениям App Store и Google Play. В дополнение к знакомой нам функциональности отдельных платформ для корпоративного сегмента постепенно приходят решения интернет вещей (Internet of things – IoT), позволяющих собирать огромные массивы данных с различных устройств и датчиков, а также работать с этими данными и устройствами. Подобная функциональность уже служит существенным конкурентным преимуществом в сегменте как B2B, так и B2C. Стоит отметить, что в ближайшем будущем большинство платформенных решений для корпоративного сектора станут облачными и получат еще большее распространение. Уже сейчас сложно представить себе крупную компанию, не использующую решения класса ERP, CRM, MDM и других. Учитывая роль и объем данных, накопленных и постоянно пополняющихся в этих системах, можно предположить, что одним из основных направлений дальнейшего развития информационных систем, существенно повышающих эффективность бизнеса, станут многофункциональные платформы управления данными, в которых на единой платформе будут собраны различные подсистемы для работы с данными.

По мере развития аппаратного обеспечения увеличение мощности и скорости обработки данных, платформенные решения работы с данными смогут обеспечить обработку данных, их очистку, сопоставление, качество, полноту, публикацию, распространение практически в режиме реального времени, что позволит не только работать с ними онлайн, но и формировать отчеты и корректировать их с применением технологий искусственного интеллекта фактически на постоянной основе в режиме реального времени, формируя всевозможные срезы по данным по мере их появления и актуализации. В подобном режиме существенно повышается качество анализируемой информации и принятие управленческих решений, базирующихся на использовании невероятных массивов качественных данных, поражающих воображение их объемом. Соответственно, поскольку объемы данных являются основой и ценнейшим ресурсом использования самых передовых решений в области аналитики, то сама область применения и результаты исследований претерпит существенные изменения. Работа с данными на лету приведет к эволюции индустрии работы с данными, обеспечив единые правила работы как с основными данными, так и с транзакционными данными, оставив между ними весьма условную границу, проходящую исключительно через методологию работы с ними.

Как известно, инновационный процесс состоит из нескольких этапов: научные открытия, за которыми обычно стоят академические университеты и лаборатории; прикладные исследования, проходящие чаще всего в стенах корпораций и использующие в качестве основы академические открытия; этап изготовления изделий/продуктов; создание новых рынков сбыта. Это традиционный путь инноваций от их зарождения до возможности использования в повседневной жизни, и в случае аппаратного обеспечения эти этапы используют практически все инновации, попадающие на рынок. Любой существенный скачок развития аппаратного обеспечения, приводящий к кардинальному изменению производительности, обеспечивает мультипликативный эффект развития решений работы с данными.

В ближайшем будущем решения в области управления данными станут привычной областью во всех сферах деятельности, и одним из критериев оценки профессиональных качеств сотрудников станут компетенции, образование и опыт работы с информацией. Уже сейчас многие профессии хотя бы косвенно имеют дело с данными, формируя справки, отчеты, заполнения различных форм, и выполняя большинство повседневных операций за компьютером.

В будущем с учетом как существенного увеличения уже накопленных данных, так и роста поступающих в постоянном режиме данных от всевозрастающего количества систем и устройств, формирующих огромные массивы информации, можно ожидать отдельного направления экономики – организации, занимающиеся исключительно работой с данными с использованием различных платформенных решений для этого. Организации, основной деятельностью которых будет работа с данными, станут крайне востребованными в различных сегментах, где необходимо обеспечивать государственные и коммерческие организации инструментарием и услугами по формированию массивов данных, их сегментированию, обеспечению качества, полноты, непротиворечивости, интероперабельности, приведению к единому формату и многими другими услугами.

Более того, этот сегмент очень скоро будет самым востребованным на рынке в первую очередь за счет взрывного спроса со стороны многочисленных заказчиков, многие из которых не готовы заниматься этим направлением самостоятельно в силу дороговизны специалистов, инструментария, отсутствия компетенций и экономической нецелесообразности. По мере развития технологий в области искусственного интеллекта и их использования в платформах управления данными участие человека в подавляющем большинстве процессов работы с данными будет снижаться, а эффективность решений, наоборот, увеличится.

Как мы неоднократно отмечали, мы живем в эпоху данных, которые нас окружают, даже если мы этого не замечаем, а разработки решений искусственного интеллекта базируются на четырех принципах:

● огромные объемы данных;

● вычислительные мощности;

● введение инструментария работы с данными;

● привлечение талантливых специалистов в области разработки алгоритмов работы с данными системы искусственного интеллекта.

Но основную роль играют именно данные, их объем и качество. Развитие синергии технологий работы с данными и систем искусственного интеллекта приведет к расширению функциональности платформ управления данными, в которых на единых принципах хранения данных будет реализовано подавляющее большинство известных сегодня отдельных решений, таких как MDM, DQ, DG, DATAMART, ETL, BI и других в единой платформе, позволяющей работать с основными и транзакционными данными, объемы которых будут исчисляться сотнями миллиардов записей. На рисунке 17.1 представлена продуктовая линейка одного из вендоров в области управления данными, учитывающая все вышесказанное.

Решения искусственного интеллекта, являющегося частью подобных платформенных решений, позволяют существенно улучшить качество данных, обеспечить управление данными, их мониторинг и операций с ними в зависимости от реализуемых сценариев, сегментируют информацию в соответствии с задачами, обеспечивают интеллектуальную настройку всевозможных правил и процедур в зависимости от многочисленных параметров данных, их структуры, внешних систем (источников и получателей данных); ранее используемых операций и все больше, все эти системы искусственного интеллекта могут принимать самостоятельные решения, формируя всевозможные подсказки в различных форматах.

На определенном этапе платформы управления данными, используя искусственный интеллект, обеспеченный большим объемом высококачественных данных, позволят принимать критически важные решения во всех сферах человеческой деятельности, окружая нас незаметной заботой и помощью – от управления всеми видами транспорта и проведения сложнейших хирургических операций до автономной работы большинства приложений на смартфонах и домашних устройствах.

ПРАКТИЧЕСКИЙ ПРИМЕР

Постепенное создание практики управления данными в «Телеком Дубль» дало компании возможность не только экономить на постоянном обновлении ИТ-ландшафта, но и получать от своих информационных ресурсов серьезную прибыль. Совмещение в одном месте данных по всем информационным доменам дает возможность получать аналитику по рынку телекоммуникационных услуг и с ее помощью развивать бизнес. Это развитие идет в том числе путем внедрения в собственную телекоммуникационную платформу новых видов продуктов – от курсов онлайн-обучения до медицинских консультаций.Взглянув на бизнес глазами директора по данным, компания, в частности, увидела один из своих продуктов не просто как программу по организации видеоконференций, а как международную коммуникационную платформу с возможностью развития торговых площадок и привлечения новых бизнес-партнеров. И все это с использованием понятных и предсказуемых процессов.В целом же можно отметить целый ряд полученных компанией очевидных выгод, например:● серьезное увеличение показателей ARPU (average revenue per user – средняя выручка на одного пользователя) и LTV (customer lifetime value – общая прибыль, которую получают от клиента в период сотрудничества);● возможность за счет интеграции данных о клиенте в единый профиль и надстраивания над ним аналитики и системы принятия решений формировать оптимальное действие для клиента (next best action);● возможность формировать максимально приближенные к реальности KPI для каждого сотрудника и т. д.Желание «Телеком Дубль» постоянно развиваться, быть в тренде и задавать собственные правила игры позволило создать полноценную практику управления данными с достаточно высоким уровнем зрелости. Благодаря повышению экспертизы в области управления информационными активами из рядовой телекоммуникационной компании «Телеком Дубль» стала превращаться в одного из лидеров рынка, повышать капитализацию и играть все большую роль в отрасли.

Литература к главе 17

• Силен Д., Мейсман А., Али М. Основы Data Science и Big Data. Python и наука о данных. – СПб.: Питер, 2018.

• Anderson C. Creating a Data-Driven Organization. O’Reilly Media, 2015. (Русский перевод: Андерсон К. Аналитическая культура. От сбора данных до бизнес-результатов. – М.: Манн, Иванов и Фербер, 2017.)

• Ladley J. Data Governance: How to Design, Deploy, and Sustain an Effective Data Governance Program: 2nd Edition. Academic Press, 2020.

• Loshin D. Business Intelligence: The Savvy Manager’s Guide: 2nd Edition. Morgan Kaufmann, 2012.

• Loshin D. Big Data Analytics: From Strategic Planning to Enterprise Integration with Tools, Techniques, NoSQL, and Graph: 1st Edition. Morgan Kaufmann, 2013.

• Smith P., Edge J., Parry S., Wilkinson D. Crossing the Data Delta: Turn the data you have into the information you need. Entity Group Limited, 2016.

Назад: Глава 16. Организационные аспекты управления данными

Дальше: Глава 18. Основные тренды будущего