6. Конец наших ценностей

Автономные системы вооружения – пример того, как технологические изменения могут угрожать фундаментальным человеческим ценностям, на которых держится наше общество. Мы понимаем, что люди разделяют некоторые естественные права, такие как право на свободу мысли, совести и религии. Мы поддерживаем больных и пожилых людей. Мы уверены в том, что каждый должен получить свой справедливый шанс. Что к мужчинам и женщинам нужно относиться одинаково. Что раса и религия не могут быть основанием для вынесения суждений о конкретном человеке.

В бесконечном потоке плохих новостей легко не заметить множество проявлений доброты, которые происходят каждый день по всему миру. Люди совершают такие добрые поступки, как усыновление сирот. Врачи добровольно жертвуют своим временем, чтобы вылечить катаракту в странах третьего мира. Нефрологи запускают цепь трансплантации.

Давайте не забывать и о небольших проявлениях доброты. Кто-то готовит еду для своего пожилого соседа. Кто-то кладет десять долларов в стаканчик бездомного. Кто-то поддерживает вас за руку, когда вы споткнулись.

Такая доброта нас определяет. Мы покорили эту планету не только потому, что умнее других видов, но еще и потому, что работаем в команде. Мы создали семьи и другие социальные группы, деревни, города и страны. Сетевые эффекты и другие экономии от масштаба подарили нам огромное преимущество над другими видами.

Работая вместе, мы вышли за пределы теории эволюции Дарвина. Выживает теперь не обязательно сильнейший. Наоборот, мы гордимся тем, что защищаем слабых. В 1900 году один из трех детей умирал, не достигнув пятилетнего возраста. Сегодня – меньше одного из двадцати. Более миллиарда человек были спасены из глубокой нищеты с 1990 года. Ожидаемая продолжительность жизни удвоилась за последние триста лет. Мы не идеальны, но мы часто помогаем друг другу.

Однако мы все еще не можем полностью положиться на наши ценности. В обществе появляются увеличивающиеся разломы. Националистические и сепаратистские движения переживают подъем. Расизм по-прежнему весьма распространен. Многие фундаментальные человеческие ценности под угрозой. Искусственный интеллект к 2062 году может сделать ситуацию еще хуже. К этому времени мы, должно быть, уже доверим принятие огромного количества важных решений машинам, которые, по умолчанию или нет, не разделяют наших ценностей.

Предвзятость машин

Если попросить переводчик Google перевести «Она доктор» на турецкий язык, а затем обратно на английский, мы получим фразу «Он доктор». С другой стороны, если попросить его перевести «Он няня» на турецкий, а затем обратно, то получится «Она няня». В турецком языке нет родов, так что «он» и «она» превращаются там в одно и то же слово – «o». Однако когда Google переводит фразу обратно на английский, он демонстрирует старомодные предубеждения в отношении врачей и нянь. Сложно избавиться от мысли о том, что машины могут подхватить множество стереотипов, которые человечеству с большим трудом удалось преодолеть.

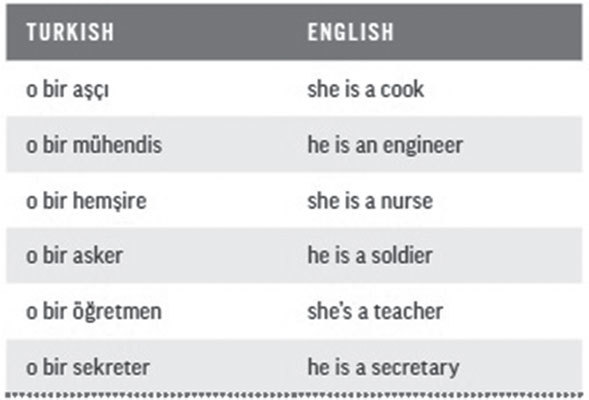

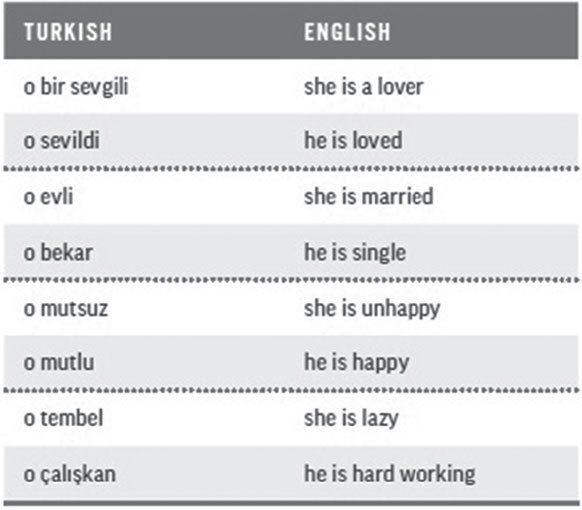

Если вы вдруг думаете, что я специально выбрал эти примеры, то взгляните на другие данные, взятые из переводчика Google (см. таблицу № 1). Помните, что в турецком языке «o» может значить как «он», так и «она».

Таблица № 1

Я мог бы легко придраться и к другим программам, например переводчику от Microsoft. Я мог бы обратиться к другим парам языков. К примеру, при переводе с английского на немецкий Google переводит «воспитатель в детском саду» в женское «die Kindergärtnerin», а «учитель» в мужское «der Lehrer».

Причина этого сексизма в том, что все программы для перевода, так же как и многие алгоритмы машинного обучения, основываются на статистике. Эта статистика порождается тем, что программа тренируется на корпусе текстов, в котором содержатся подобные гендерные стереотипы. Слово die Kindergärtnerin встречается чаще, чем его мужской эквивалент der Kindergärtner. Потому программа отражает предубеждения, которыми наполнены письменные тексты. Однако это стереотип, без которого мы вполне могли бы обойтись. Его можно было бы устранить, если бы мы – а точнее, Google и другие технологические компании, занятые разработкой переводчиков, – приложили усилия.

Обнаружились и другие примеры предубеждений в алгоритмах. Например, исследование Университета Карнеги – Меллона 2015 года показало, что Google предлагает больше рекламы высокооплачиваемых профессий для мужчин, чем для женщин. В отличие от многих других я не обвиняю Google в этих стереотипах. Исходя из той информации, которой мы владеем, вина за это может лежать как на поиске Google, так и на алгоритмах рекламодателей. Однако, что бы ни было источником этой проблемы, это явно не поможет нам победить гендерную дискриминацию, пока женщинам предлагают менее оплачиваемую работу, чем мужчинам.

Большие компании, такие как Google или Facebook, должны взять на себя некоторую ответственность. Даже если они предоставляют эти сервисы бесплатно, они обязаны пресекать утверждение этих предубеждений. Технологические компании способствуют продвижению мифа о том, что алгоритмы не содержат неосознанных человеческих стереотипов и просто предоставляют лучший результат. Эта ложь позволяет корпорациям избегать ответственности за свои алгоритмы и не заниматься решением проблемы.

Слова Питера Норвига о том, что люди плохо умеют принимать решения, сущая правда. Специалисты в области поведенческой экономики выяснили, что мы полны стереотипов и часто ведем себя иррационально. Однако если мы не будем осторожны, то создадим машины, которые будут такими же предвзятыми. На самом деле алгоритмы сегодня часто уступают людям в этом аспекте. В отличие от нас многие алгоритмы не могут объяснить, как они принимают решения. Это черные ящики, которые просто дают ответы. Человека всегда можно спросить, почему он поступил так или иначе. С большинством современных ИИ придется просто принять ответ как должное.