Новый способ мышления

Использование в ИИ подхода, основанного на больших данных, теперь близко к внедрению во все сферы нашей жизни, перестав ограничиваться только лишь интернет-магазинами.

Например, Институт судебных экспертиз Нидерландов в Гааге через месяц после выступления Рашида воспользовался системой машинного обучения для поиска подозреваемого в убийстве, который в течение 13 лет скрывался от полиции. Программа смогла проанализировать и сравнить колоссальные объемы образцов ДНК, что потребовало бы колоссального времени для выполнения вручную.

Также к машинному обучению прибегают страховая и кредитная отрасли, используя алгоритмы для создания профилей рисков отдельных лиц. Медицина обращается к статистическому ИИ для сортировки наборов генетических данных, слишком объемных для анализа человеком. Watson (IBM), DeepMind (Google) и подобные им системы могут диагностировать болезни. Анализ больших данных позволяет увидеть то, что мы зачастую упускаем. Такой ИИ может узнать нас даже лучше, чем мы сами. Но для этого потребуется принципиально новый способ мышления.

В период зарождения ИИ высоко ценилось понятие «объяснимость», то есть способность системы показать, как именно она пришла к определенному решению. Когда система символического мышления на основе правил делает свой выбор, человек может отследить всю логическую цепочку и понять «ход мыслей» ИИ.

И все же логические выводы, к которым приходит современный ИИ, основанный на больших данных, представляют собой сложный статистический анализ огромного количества точек данных. Это означает, что мы отказались от «почему» в пользу «что». Даже если технический специалист с высокой квалификацией постарается воспроизвести логику выполнения, на выходе может получиться нечто бесполезное. По словам Криса Бишопа из Microsoft, мы не сможем понять, почему система принимает именно это решение, поскольку в своем решении она не руководствуется набором правил, понятных для человека. Но, по его мнению, это достойный компромисс для получения работающей системы. Ранние искусственные «умы» могли быть прозрачными для человека, но они терпели неудачу. Многие критиковали новый подход, однако Бишоп и другие уверены, что пришло время перестать ждать от системы человеческих объяснений. «Объяснимость – это социальное соглашение, – говорит Нелло Кристианини. – Когда-то давно мы считали, что это важно. Сейчас же мы решили иначе».

Питер Флэч из Бристольского университета пытается научить этому принципиально новому образу мышления своих студентов с направления информатики. Программирование – это абсолют, а машинное обучение является в нем степенью неопределенности. Он считает, что нам стоит проявить больше скептицизма. Например, если Amazon рекомендует вам книгу, то он делает это благодаря машинному обучению или лишь потому, что данные книги плохо продаются? А когда Amazon говорит, что похожие люди купили такие книги – что именно система имеет в виду под «похожими людьми» и «такими книгами»?

Крупные ставки

Опасность скрыта в том, что мы перестаем задавать вопросы. Сможем ли мы настолько привыкнуть к сделанному за нас выбору, что перестанем это замечать? Теперь, когда интеллектуальные машины начинают принимать непостижимые решения по ипотечным кредитам, диагностике болезней и виновности в совершении преступлений, ставки становятся еще выше.

Что если медицинский ИИ решит, что через несколько лет вы начнете сильно пить? Оправдают ли в таком случае врачей за отказ в трансплантации? Сложно ли будет оспорить решение по вашему делу, если никто не знает, как оно было получено? Некоторые люди могут доверять ИИ куда больше других. «Люди слишком охотно принимают все, что нашел алгоритм, – говорит Флэч. – Компьютер говорит "нет". В этом вся проблема». А вдруг уже где-то есть интеллектуальная система, которая прямо сейчас дает оценку вашей личности – вам настоящему и вам будущему. Вспомните тот случай с Латанией Свини из Гарвардского университета. Однажды она с удивлением обнаружила, что ее поисковый запрос в Google сопровождался рекламными модулями с текстом «Вас когда-нибудь арестовывали?». Для белых коллег такая реклама не показывалась. Так было проведено исследование, показавшее, что система машинного обучения, использовавшаяся в поиске Google, случайным образом оказалась расистом. Глубоко в веренице сопоставлений имена, типичные для чернокожих людей, были связаны с рекламными объявлениями об арестах.

Крупные промахи

В последние годы у нас было несколько крупных промахов. В 2015 году Google пришлось извиняться за то, что один из его продуктов автоматически отметил фотографии двух чернокожих людей как «горилл». Год спустя компании Microsoft пришлось отключить чат-бота по имени Tay, поскольку он выучил оскорбительные ругательства. В обоих случаях это были не проблемы с алгоритмом, а ошибки в подборе обучающих данных.

2016 год тоже отметился: произошел первый несчастный случай, связанный с беспилотным автомобилем. Тогда водитель перевел автомобиль Tesla в режим автопилота, и система не заметила трейлер на дороге. Дорожные условия были необычными: белое препятствие на фоне светлого неба, – поэтому система машинного зрения просто допустила ошибку. С выходом все большего количества компаний на мировой рынок вероятность возникновения подобных инцидентов лишь возрастает.

Существует бесчисленное количество историй, которые не попадают в новости, потому что системы ИИ работают так, как нужно. Однако мы не можем узнать, делают ли подобные системы именно то, что мы от них хотим. Нам нужно уделять пристальное внимание типу данных, которые мы передаем системе, ведь мы поручаем машинам принятие все более сложных решений. Переосмысления требует не только технология, но и ее использование в нашей повседневной жизни.

В эпоху больших данных многие люди обеспокоены конфиденциальностью информации. Но Виктор Майер-Шенбергер из Оксфордского института интернета считает, что на самом деле беспокойство должно вызывать неправильное использование вероятностного прогноза. «В данной сфере существуют серьезные этические дилеммы», – говорит он.

Чтобы ориентироваться в этом мире, нам потребуется изменить представления о том, что же означает искусственный интеллект. Знаковые интеллектуальные системы, которые мы уже создали, не играют в шахматы и не планируют гибель рода человеческого. «Они не похожи на HAL 9000», – рассказывает Нелло Кристианини, профессор искусственного интеллекта в Бристольском университете. Они прошли долгий путь от «сопровождения» нас в Интернете и стимулирования продаж товаров в сети до обещаний предсказать наше поведение еще до того, как мы сами о нем узнаем. От таких систем никуда не скрыться. Нам требуется смириться с тем, что мы не сможем понять, почему принимаются те или иные решения, и научиться принимать выбор системы таким, какой он есть – рекомендация, математическая вероятность. Интеллектуальные машины не управляются оракулом.

Когда люди мечтали о создании ИИ по своему образу и подобию, они ожидали увидеть разумные машины, которые будут с человеком на равных. ИИ, который есть сейчас, – он как пришелец. Это форма разума, с которой мы никогда ранее не сталкивались.

Сможем ли мы покопаться в «мозгах» ИИ?

Интересно, о чем думает ИИ? Чтобы понять чье-то поведение, нужно знать, о чем этот человек думает. То же самое и с искусственным интеллектом. Новая техника по созданию снимков нейронных сетей в процессе обнаружения проблемы позволяет лучше понять принципы работы сетей – это приведет к повышению эффективности и надежности ИИ.

За последние несколько лет алгоритмы глубокого обучения, основанные на нейронных сетях, достигли прогресса во многих областях ИИ. Проблема в том, что мы не всегда знаем, как именно все происходит. «Система глубокого обучения – это настоящий "черный ящик", – говорит Нир Бен Зрихем из Техниона (Израильского технологического института) в городе Хайфа. – Если система работает – отлично. Если же нет, то вам крупно не повезло».

Нейронные сети – это больше, чем сумма своих компонентов. Они состоят из множества простых элементов – искусственных нейронов. «Вы не можете указать на какую-то конкретную область в сети и сказать, что весь интеллект запрятан там», – говорит Зрихем. Но из-за сложности соединений нейронов невозможно проследить шаги, которые выполняет алгоритм глубокого обучения для достижения нужного результата. В таких случаях сама машина действительно больше похожа на оракула, а ее результаты принимаются на веру.

Для наглядной демонстрации своей точки зрения Зрихем с коллегами создал образы глубокого обучения в процессе работы. По их мнению, подобная техника похожа на функциональную МРТ для компьютеров, поскольку фиксирует активность алгоритма в процессе решения какой-то задачи. Подобные образы позволяют исследователям отследить различные этапы работы нейронной сети, включая тупиковые ситуации.

Чтобы получить нужные динамические образы, команда поставила перед нейронной сетью задачу – сыграть в три классические игры Atari 2600: Breakout, SeaQuest DSV и Pac-Man. Пока алгоритм проходил каждую из игр, ученые смогли сделать 120 000 снимков. Затем они разметили данные, используя технику, позволяющую сравнивать одинаковые моменты при повторяющихся попытках в игре.

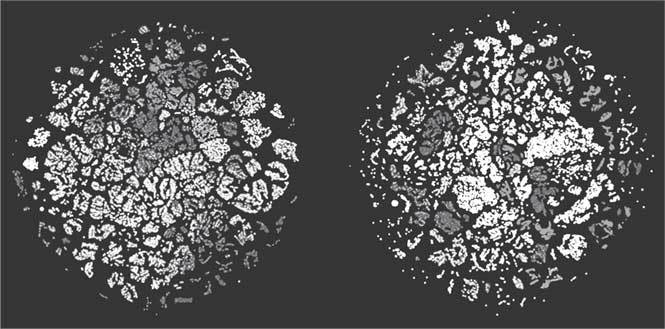

Результаты похожи на сканы головного мозга человека (см. рис. 2.1), но каждая точка представляет собой снимок одной игры в отдельный момент времени. Различные цвета показывают, насколько успешно действовал ИИ в данный момент игры.

Возьмем, например, Breakout. Здесь игрок с помощью ракетки и мяча должен пробить дыру в «стене» из ярких блоков. На одном из снимков команда исследователей смогла обнаружить четкую область в форме банана. Эта область повторялась каждый раз, когда алгоритм пытался пройти через пробитый туннель из блоков, чтобы закинуть мяч на вершину – успешная тактика, которую нейронная сеть придумала самостоятельно. Анализ этапов прохождения игры позволил исследователям проследить использование алгоритмом различных тактик для победы в игре.

Создание идеальной игровой стратегии – это, конечно, интересно. Но такие сканы помогут нам отточить эффективность алгоритмов, предназначенных для решения реальных задач. Например, наличие изъянов в алгоритме информационной безопасности означает, что при определенных ситуациях систему можно будет легко обмануть, или же алгоритм для одобрения заявки на банковский кредит может выказывать предвзятость к определенной расе или полу. При использовании данной технологии в реальном мире нужно четко понимать, как все работает и что может пойти не так.

Символы наносят ответный удар

Нет сомнений в том, что машинное обучение через нейронные сети имело ошеломительный успех. И все же оно не идеально. Обучение системы для выполнения конкретной задачи происходит медленно, к тому же система не может повторно использовать полученные знания для выполнения другой задачи. От этой проблемы страдает весь современный искусственный интеллект. Компьютеры могут обучаться и без нашего руководства, но приобретаемое таким образом знание совершенно бесполезно за пределами решаемой задачи. Они подобны детям, которые, научившись пить из бутылочки, не понимают, что же делать с кружкой.

Рис. 2.1. Результат «сканирования мозга» нейронной сети

Мюррей Шанахан с коллегами из Имперского колледжа Лондона пытаются решить эту проблему старомодным способом, при котором техники машинного обучения отходят на задний план. Идея Шанахана – воскрешение символического ИИ и объединение его с современными нейронными сетями.

Символический ИИ так и не смог достичь успеха, поскольку описание всего необходимого ИИ вручную оказалось непосильной задачей. Современный ИИ смог преодолеть эту трудность, обучаясь собственным представлениям о мире. Однако эти представления невозможно передать в другие нейронные сети.

Работа Шанахана направлена на то, чтобы реализовать передачу определенных знаний между задачами. Награда этой разработки – ИИ, который быстро учится и требует меньше данных о мире. Андрей Карпати, исследователь машинного обучения в OpenAI, написал в своем блоге: «Вообще-то мне не нужно несколько сотен раз разбивать машину об стену, чтобы научиться медленно избегать столкновения».