Книга: Человек + машина. Новые принципы работы в эпоху искусственного интеллекта

Назад: Введение

Дальше: Глава 6. Сверхрезультаты обычных людей

Глава 5. Правильное формирование алгоритмов

* * *

Три функции человека по развитию и внедрению ответственного искусственного интеллекта

У Мелиссы Цефкин интересная работа. Будучи научным руководителем исследовательского центра компании Nissan в Кремниевой долине, она работает вместе с простыми разработчиками автомобилей над созданием следующего поколения беспилотных транспортных средств. Задача Мелиссы — обеспечить беспроблемное взаимодействие человека и машины (другими словами, между водителем и автомобилем), в этом ей помогает образование антрополога. «Необходимо понять людей, если вы хотите предоставить им автоматизированного партнера», — утверждает Мелисса.

Роль Цефкин в компании Nissan — обращать внимание и анализировать те вещи, о которых большинство разработчиков автомобилей и не задумываются. Возьмем, к примеру, правила дорожного движения и дорожные знаки, большинство из которых интуитивно понятны (как в случае запрета на пересечение двойной сплошной линии), однако при определенных условиях люди часто нарушают эти правила (пересекая двойную сплошную, чтобы избежать столкновения). Следует ли программировать самоуправляемые автомобили на нарушение правил в определенной ситуации? Вместе с разработчиками, инженерами-электротехниками и специалистами по искусственному интеллекту Цефкин надеется наделить алгоритмы искусственного интеллекта в беспилотных автомобилях человеческими качествами, такими как готовность нарушить правила в благих целях.

Будучи антропологом в области проектирования транспортных средств, Цефкин относится к группе профессионалов, которых до недавнего времени не существовало. За последние годы системы искусственного интеллекта стали неотъемлемой частью повседневной деятельности компаний, предлагая продукты покупателям, помогая промышленным предприятиям становиться эффективнее, а также обнаруживая и решая проблемы посредством информационных систем. Такая трансформация инициировала широкую дискуссию о возможном исчезновении ряда профессий в будущем. (Подумайте хотя бы о множестве сотрудников складов, которые работают сейчас в компании Amazon.) Однако в дискуссиях такого рода часто упускают из виду, что в то же время появится много новых профессий, подобных тому, чем занимается Цефкин. Большинство их будут сфокусированы на обучении машин человеком, причем этот процесс все больше будет напоминать процесс воспитания ребенка. Так системы искусственного интеллекта научатся поддерживать сложное взаимодействие с людьми.

В рамках глобального исследования более полутора тысяч компаний, уже использующих или тестирующих системы искусственного интеллекта и машинного обучения, мы обнаружили ряд новых профессий, роль которых будет только расти.

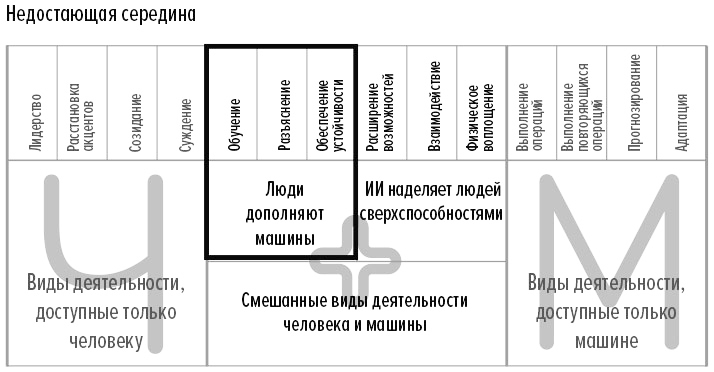

Эти новые профессии не просто заменят старые. Речь идет о совершенно новых функциях, требующих таких навыков и такой подготовки, в которых еще никогда не возникала потребность. В частности, системы искусственного интеллекта высокого уровня сложности требуют привлечения специалистов в области бизнеса и технологий, которые должны заниматься обучением, разъяснением и обеспечением устойчивости систем искусственного интеллекта (речь идет о функциях в левой части рис. 4, где показаны смешанные виды деятельности человека и машины). Такая работа дополняет задачи, выполняемые интеллектуальными машинами. Будучи тесно связанными с искусственным интеллектом, такие функции опираются на сугубо человеческие навыки. Где в вашей организации могут найти применение эти новые профессии? Как они согласуются с существующими и переосмысленными процессами? В этой главе мы дадим ответы на эти вопросы и приведем примеры, которые помогут вам приступить к анализу перспектив, открывающихся перед специалистами по обучению, разъяснению и экспертами по устойчивости искусственного интеллекта.

Рис. 4. «Недостающая середина» — левая часть

Специалисты по обучению

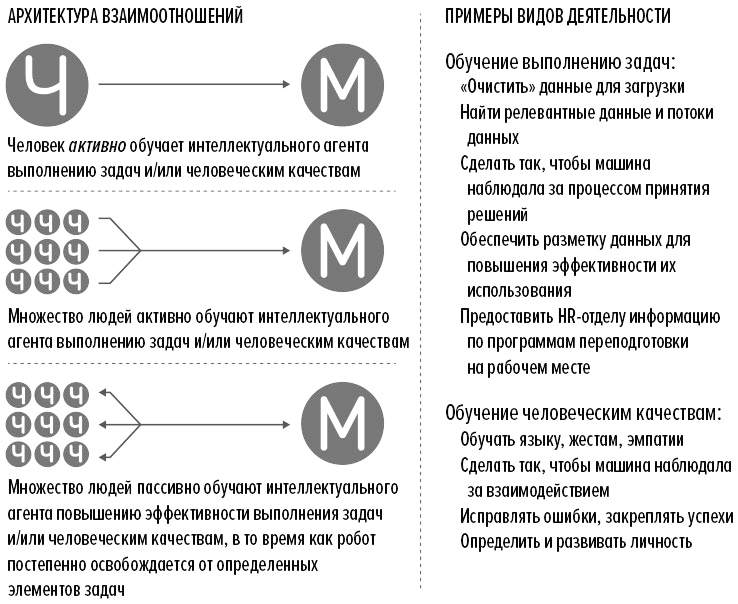

В прошлом людям приходилось приспосабливаться к работе компьютеров. В настоящее время происходит обратный процесс — системы искусственного интеллекта учатся тому, как адаптироваться к нам. Для достижения этой цели им требуется всестороннее обучение. На рис. 5 перечислены профессии, без которых системы искусственного интеллекта невозможно будет обучить тому, как выполнять определенные задачи или как действовать немного более… очеловеченно. Как правило, мы положительно реагируем на искусственный интеллект, демонстрирующий человекоподобное поведение, ведь это позволяет нам поддерживать более естественное взаимодействие с машинами. (С другой стороны, у нас могут вызывать неприязнь малейшие отклонения в поведении человекоподобных роботов — этот феномен, получивший название «зловещая долина», рассматривается в одном из следующих разделов данной главы.)

Рис. 5. Функции специалистов по обучению

Например, промышленных роботов, работающих рядом с людьми, необходимо программировать и обучать выполнению разных задач, что требует привлечения сотрудников с соответствующими навыками. Автомобилестроительные компании с высоким уровнем автоматизации несут огромные потери при выходе оборудования из строя. Незапланированный шестичасовой простой автоматизированной сборочной линии, выпускающей по одному автомобилю стоимостью $50 000 в минуту, обходится примерно в $18 миллионов. Именно по этой причине компания Fanuc (ведущий производитель робототехники) обучила 47 тысяч людей использованию своего оборудования. Тем не менее в ближайшие годы будет не хватать около 2 миллионов квалифицированных специалистов для работы на производстве.

Физические роботы — не единственный тип систем искусственного интеллекта, которым необходимо обучение. Интеллектуальное программное обеспечение также нуждается в обучении — и в этом случае очень важно, чтобы обучающиеся машины обрели человекоподобные черты. В самых простых случаях специалисты по обучению помогают системам распознавания естественного языка и «переводчикам» делать меньше ошибок. В более сложных случаях алгоритмы искусственного интеллекта необходимо научить имитировать человеческое поведение. Например, чат-боты, обслуживающие клиентов, должны научиться распознавать неочевидные моменты человеческого общения. В Yahoo! специалисты по обучению искусственного интеллекта стремятся научить корпоративную систему обработки естественного языка тому, что люди не всегда имеют в виду то, что говорят. К настоящему времени компания разработала алгоритм, способный обнаруживать сарказм в социальных сетях и на веб-сайтах с точностью до 80%.

По мере того как искусственный интеллект будет охватывать все больше отраслей, вырастет число компаний, испытывающих потребность в специалистах по обучению физических и программных систем искусственного интеллекта. На первом этапе целесообразно привлекать тех квалифицированных сотрудников, которые уже работают в тесном взаимодействии с системами искусственного интеллекта или с системами, в которые интегрирован искусственный интеллект. Во многих случаях от скрытых знаний таких специалистов зависит, будет ли система работать эффективно или ее ждет провал. Затем, после того как она усвоит основные принципы, необходимо перейти на следующий уровень обучения, который обеспечит дальнейшую детализацию и устойчивость, как в приведенных ниже примерах.

Специалист по обучению эмпатии — это человек, который учит системы искусственного интеллекта демонстрировать сочувствие. Такая задача может показаться надуманной, однако упомянутый в , созданный в медиалаборатории Массачусетского технологического института, разработал систему машинного обучения, которая призвана помочь таким чат-ботам, как Siri компании Apple и Alexa компании Amazon, реагировать на вопросы пользователей с сочувствием и глубоким пониманием. В настоящее время специалисты обучают алгоритм Koko более чутко реагировать на запросы людей, которые, например, опечалены потерей багажа, покупкой некачественного товара или мигающим монитором, который никак не удается починить. Цель — добиться того, чтобы система обсуждала с человеком проблему или сложную ситуацию, проявляя сочувствие, сострадание, а может, даже юмор. Каждый раз, когда алгоритм Koko реагирует ненадлежащим образом, специалист по обучению помогает ему внести необходимые коррективы в свои действия. Со временем такой алгоритм машинного обучения обретет способность давать лучший ответ.

Этот пример демонстрирует потенциал современных систем искусственного интеллекта такого рода. Без алгоритма Koko Alexa реагирует на опасения пользователя заранее заготовленными, повторяющимися фразами, такими как «Мне жаль это слышать» или «Порой помогает разговор с другом». Благодаря алгоритму Koko бот Alexa способен оказать гораздо более существенную поддержку. Вот как звучит ответ виртуального помощника Alexa с алгоритмом Koko человеку, который волнуется перед предстоящим экзаменом: «Экзамены действительно вызывают стресс, однако небольшое беспокойство помогает добиться успеха. Оно обостряет интеллект… Так организм готовится действовать. На самом деле это даже полезно. Нервозность можно воспринимать как секретное оружие. Я знаю: это легче сказать, чем сделать. Но я думаю, ты сдашь экзамен гораздо лучше, чем тебе кажется». В случае приложений для обслуживания клиентов с использованием искусственного интеллекта хорошо обученный чуткий бот позволит вам обойти конкурентов.

Помимо обучения эмпатии усовершенствованные системы искусственного интеллекта будут также учиться тому, как стать более похожими на человека, — им помогут в этом специалисты по обучению личностным качествам. На первый взгляд предположение о том, что у систем искусственного интеллекта может возникнуть потребность в развитии определенных личностных качеств, нам кажется в чем-то даже дерзким. Но подумайте, какую важную роль может сыграть такая технология, как виртуальный помощник Cortana компании Microsoft, в контексте создания бренда и его дальнейшего поддержания (о чем шла речь в ). Возьмем, к примеру, уверенный, компетентный и заботливый стиль общения системы Cortana. Благодаря интенсивному обучению специалистами Microsoft Cortana производит впечатление собеседника, который всегда готов помочь, но при этом не склонен к менторскому тону. Например, Cortana начнет понимать, в каких случаях конкретный человек наиболее восприимчив к рекомендациям. Все это соответствует миссии Microsoft, которая уже много лет поддерживает расширение возможностей пользователей.

У специалистов по обучению личностным качествам может быть разное образование и опыт работы. Так, Робин Юинг в прошлом писала сценарии и продавала их голливудским киностудиям. В настоящее время она применяет свои творческие способности, помогая инженерам развивать личностные качества Sophie — программы искусственного интеллекта в области здравоохранения. Среди многих других задач Sophie напоминает пользователям о том, чтобы они приняли лекарства, и регулярно связывается с ними, чтобы проверить их самочувствие. Безусловно, у таких специалистов, как Юинг, нет резюме, типичного для сферы высоких технологий. В компании Microsoft развитием личностных качеств виртуального помощника Cortana занимается команда, в состав которой входят поэт, писатель и драматург.

Надлежащее обучение таких ботов, как Cortana, начнет играть все более важную роль по мере того, как подобные приложения будут принимать антропоморфный облик и ассоциироваться с тем или иным брендом. Некоторые специалисты по маркетингу уже сейчас предвидят эволюцию брендов от одностороннего взаимодействия (от бренда к клиенту) к двусторонним взаимоотношениям. В рамках такого взаимного обмена с потребителями искусственный интеллект становится лицом бренда, о чем шла речь в предыдущей главе.

Если эволюция чат-ботов (и брендов) пойдет по такому пути, их необходимо будет обучать в глобальном контексте — и эта задача будет возложена на специалистов по обучению мировоззрению и локализации. Подобно тому как людям, работающим за рубежом, необходимо считывать культурные коды иностранных коллег и понимать, о чем они говорят, боты также должны быть чувствительными к различиям между людьми из разных стран мира. Специалисты по обучению мировоззрению и локализации позаботятся о том, чтобы системы искусственного интеллекта учитывали множество локальных факторов. Например, в некоторых странах люди не испытывают такого же беспокойства из-за роботов и роста автоматизации, как жители США и Западной Европы. Так, японцы восхищаются роботами и ощущают «культурную близость» с ними, что может облегчить установление более тесного взаимодействия машины и человека. Специалисты по обучению мировоззрению должны знать о таких различиях. Понимание чат-ботами культурных кодов позволит избежать недоразумений и затруднений, а также укрепить доверие к бренду.

Большую помощь в обучении систем искусственного интеллекта человеческим качествам и глобальному мировоззрению могут оказать специалисты по моделированию взаимодействия. Такие люди помогают привить машинам определенные поведенческие паттерны, привлекая сотрудников с большим опытом в качестве ролевых моделей. Так, профессор робототехники Массачусетского технологического института Джули Шах занимается разработкой роботов, которые могут наблюдать за работой людей, чтобы со временем научиться выполнению определенных задач. Одна из целей такого подхода — научить роботов принимать элементарные решения, например прерывать выполнение одной задачи ради более важного задания, а затем возвращаться к исходной, как это сделал бы человек.

Обучение искусственного интеллекта не обязательно выполнять собственными силами. Подобно бухгалтерскому учету, IT и другим функциям, обучение систем искусственного интеллекта может осуществляться на краудсорсинге или аутсорсинге. Компания Mighty AI умело применяет методы краудсорсинга для обучения систем искусственного интеллекта распознаванию объектов (например, озер, гор и дорог на фотографиях), а также обработке естественного языка. Компания накопила огромный объем обучающих данных, которые использует при выполнении заказов своих клиентов. Так, один заказчик поручил Mighty AI научить его платформу машинного обучения определять намерения собеседников и смысл того, что они говорят. Ранее другая компания в области искусственного интеллекта предприняла попытку выполнить такое обучение своими силами, предлагая сотрудникам «разыграть» диалоги для составления эталонных бесед, однако такой подход было трудно масштабировать. Это ограничение в итоге привело к тому, что компания делегировала данную работу подрядчику.

В сотрудничестве с Mighty AI компания разработала сложные задачи на основе поддающихся персонализации шаблонов, опираясь на помощь сообщества пользователей, прошедших предварительный квалификационный отбор. Обладая знаниями, навыками и специализацией в соответствующих областях, эти пользователи «озвучивали» диалоги в соответствии со сценариями, приближенными к реальному взаимодействию клиентов и сотрудников компании. Затем в использовали полученные данные для построения собственных моделей диалогов, которые легли в основу подготовки платформы машинного обучения.

Совершенно очевидно, что качество систем искусственного интеллекта полностью зависит от качества данных, на основе которых их обучали. Приложения такого рода ищут закономерности в данных, и любые искажения отразятся на результатах последующего анализа. Эта ситуация напоминает принцип «мусор на входе — мусор на выходе», но в данном случае было бы уместно сказать «ошибки на входе — ошибки на выходе». В рамках одного интригующего эксперимента программисты компании DeepMind, принадлежащей Google, научили систему искусственного интеллекта играть в две игры, одна из которых сводилась к охоте, а другая к сбору фруктов. В итоге система искусственного интеллекта, которую обучали играть в охоту, демонстрировала крайне агрессивное поведение. При обучении на игре в сбор фруктов система искусственного интеллекта демонстрировала гораздо большую склонность к сотрудничеству.

Именно поэтому роль специалиста по гигиене данных так важна. Беспристрастными должны быть не только сами алгоритмы; данные, которые используются для их обучения, также должны быть свободными от предвзятости. В ближайшие годы роль таких специалистов будет только возрастать, ведь компании используют информацию из самых разных источников, в том числе биометрические данные, изображения со спутника, данные о дорожном движении, данные из социальных сетей и т. д. Во многих случаях это могут быть так называемые выбросы, то есть данные, возникающие как побочный продукт другого процесса. Подумайте о тех данных, которые каждый день генерируются Facebook.

Ведущие компании быстро обнаружили, как использовать такие «выбросы» в эпоху больших данных. Например, хедж-фонд BlackRock использует спутниковые снимки территории Китая для более эффективного анализа промышленного развития этой страны. Данный анализ даже привел к появлению нового финансового инструмента — «квантаментальных» фондов, которые используют сложные алгоритмы машинного обучения для анализа традиционной финансовой отчетности и «выбросов» для того, чтобы прогнозировать динамику стоимости тех или иных акций на рынке. Такие инновационные приложения требуют опыта и знаний специалистов по гигиене данных, во многих случаях работающих совместно с экспертами по устойчивости систем искусственного интеллекта, о которых мы поговорим позже. Специалисты по гигиене данных должны не только обеспечивать преобразование «выбросов» в формат, приемлемый для ввода в систему искусственного интеллекта, но и очищать эту информацию от любого «шума» или скрытой предвзятости.

Специалисты по разъяснению

Представители этой профессии нужны, чтобы устранять разрыв между техническими специалистами и руководителями компаний. Важность подобного функционала будет возрастать по мере увеличения непрозрачности систем искусственного интеллекта. Многие обеспокоены тем, что сложные алгоритмы машинного обучения напоминают черный ящик, особенно когда такие системы рекомендуют действия, идущие вразрез с общепринятыми представлениями или носящие противоречивый характер (рис. 6).

Рис. 6. Функции специалистов по разъяснению

Рассмотрим в качестве примера компанию ZestFinance, которая помогает кредитным организациям повысить эффективность прогнозирования кредитного риска и увеличить выдачу займов тем лицам, которые при обычных обстоятельствах не соответствуют всем условиям получения кредита. Эта компания обеспечивает кредиторам возможность анализировать тысячи единиц информации о потенциальном заемщике (гораздо больше, чем требуется для расчета кредитного рейтинга FICO и составления традиционных кредитных историй) и использует самую современную технологию искусственного интеллекта для принятия решений о выдаче кредита или отказе в нем. Средний годовой доход потенциального заемщика достигает $30 000, причем у многих есть невыплаты по кредитам. Как правило, кредиты предоставляются на небольшую сумму (в среднем около $600) под высокие проценты.

Учитывая характер бизнеса, компании ZestFinance необходимо иметь возможность объяснить своим клиентам работу системы искусственного интеллекта, которую они используют для одобрения кредитов. Компания описала процесс оценки кандидатов на основе разных критериев, таких как честность, стабильность и благоразумие. Если указанный человеком доход гораздо выше, чем у аналогичных кандидатов, это снижает его рейтинг честности. Если за прошедшие несколько лет человек много раз переезжал с одного места на другое, под ударом оказывается его рейтинг стабильности. А если он не нашел времени, чтобы прочитать все условия предоставления кредита перед подачей заявки, это отрицательно сказывается на рейтинге благоразумия. Затем набор алгоритмов, каждый из которых выполняет самостоятельный анализ, изучает всю совокупность данных. Так, один из них проверяет, не указывает ли определенная информация на более серьезные события, например просрочку платежа по состоянию здоровья. На основании результатов анализа ZestFinance присваивает кандидату рейтинг от 0 до 100.

Усовершенствованные алгоритмы позволили ZestFinance выявить множество любопытных закономерностей. Так, компания выяснила, что люди, использующие прописные буквы при заполнении заявок на кредит, обычно оказываются заемщиками с более высоким уровнем риска. Такие результаты дали ZestFinance возможность постоянно снижать процент невозврата кредитов на несколько процентных пунктов, что позволяет компании обслуживать клиентов, которым при обычных обстоятельствах кредит бы не выдали. Однако главное здесь то, что ZestFinance может объяснить, как она принимает решения по кредиту, одобряя каждую третью заявку.

Поскольку компании полагаются на всё более совершенные системы искусственного интеллекта, принимая те или иные решения (особенно те, которые затрагивают интересы клиентов), им необходимо объяснять и обосновывать свои действия. На самом деле правительства уже рассматривают возможность принятия нормативных актов в этой области. Например, новое постановление Европейского союза «Общий регламент по защите данных», которое вступило в силу в 2018 году, по существу, вводит «право на разъяснение», позволяющее потребителям бороться за отмену любого решения, затрагивающего их интересы и принятого исключительно на основе алгоритма.

Компаниям, использующим современные системы искусственного интеллекта, понадобятся квалифицированные сотрудники, способные объяснить логику сложных алгоритмов. Одним из таких сотрудников станет эксперт по алгоритмам, в обязанности которого входит выявление причин, по которым алгоритм выдает те или иные результаты. Когда система совершает ошибку или когда ее решения приводят к непредвиденным негативным последствиям, эксперт должен выполнить своего рода «аутопсию» алгоритма, чтобы понять причины таких действий и внести необходимые коррективы. Некоторые типы алгоритмов объяснить не составит труда — к их числу относится алгоритм «убывающий список правил», в котором используется упорядоченный список правил импликации. Другие, как, например, алгоритмы глубокого обучения, объяснить не так просто. Тем не менее эксперт по алгоритмам должен иметь надлежащую подготовку и навыки, необходимые для детального анализа всех алгоритмов, используемых организацией.

В данном случае могут оказаться чрезвычайно полезными такие методы, как локально интерпретируемые моделе-агностические объяснения (local-interpretable-model-agnostic explanations, LIME). Для LIME не имеет значения, какой именно алгоритм искусственного интеллекта используется на самом деле. По существу, LIME вообще не нужно знать о внутренних механизмах соответствующей системы искусственного интеллекта. Для анализа любых результатов LIME корректирует переменные и наблюдает за тем, как меняется решение. Эта информация позволяет LIME выделить разные данные, на основе которых был сделан соответствующий вывод. Так, например, если экспертная система по подбору персонала определила лучшего кандидата на одну из должностей в отделе научных исследований и разработок, LIME может установить переменные, которые привели к принятию данного решения (такие как образование и глубокие знания в определенной узкой области), а также аргументы против этого решения (такие как отсутствие опыта работы в команде). С помощью таких методов эксперт по алгоритмам может объяснить, почему заявителю отказали в кредите, почему приостановили производственный процесс или маркетинговую кампанию запустили только на определенный сегмент потребителей.

Однако еще до возникновения потребности в такой экспертизе специалист по прозрачности алгоритмов должен классифицировать причины, по которым алгоритм искусственного интеллекта действует как черный ящик. От этих причин зависят уровень прозрачности и возможность проведения проверки алгоритма. Например, некоторые алгоритмы намеренно создаются как черные ящики, с тем чтобы защитить интеллектуальную собственность, тогда как другие напоминают черные ящики из-за сложности программного кода, или масштаба обрабатываемых данных, или механизмов принятия решений. Специалист по прозрачности — это человек, который классифицирует системы и ведет базу данных или библиотеку информации о доступности системы.

Для специалиста по разъяснению такая база данных бесценна. В его обязанности входит принятие важных решений о том, какие технологии искусственного интеллекта лучше всего использовать для конкретных задач. В данном случае особое внимание следует уделить выбору между точностью и объяснимостью алгоритма. Например, система глубокого обучения обеспечивает высокий уровень точности прогнозирования, однако у компаний могут возникнуть трудности с объяснением полученных результатов. Напротив, дерево решений может не привести к получению результатов с высокой точностью прогнозирования, но обеспечит существенно более высокий уровень разъяснения. Так, например, для внутренней системы оптимизации логистики, допускающей только небольшие отклонения от графика поставок, целесообразно использовать технологию глубокого обучения. С другой стороны, в области здравоохранения или взаимодействия с клиентами осуществляется строгий надзор со стороны регуляторов, а значит, в этом случае лучше использовать алгоритмы убывающих списков правил.

Кроме того, специалист по разъяснению может решить, что в определенной области целесообразно вообще отказаться от искусственного интеллекта. Оптимальным вариантом может стать традиционный обработчик правил. Принимая подобное решение, специалист по разъяснению должен учитывать не только технологические аспекты, но и финансовые, юридические, этические и другие важные факторы.

Эксперты по устойчивости

В 2015 году на заводе компании Volkswagen в Германии робот нанес сотруднику смертельные увечья. Трагическая гибель рабочего привлекла внимание общества к растущей зависимости от автоматизированных инструментов. С тех пор как компьютеры начали брать на себя выполнение все более сложных задач, усиливаются опасения, что машины могут выйти из-под контроля. От компьютера HAL из фильма «2001 год: Космическая одиссея» до киборгов из франшизы «Терминатор» — популярная культура только подогревает тревоги людей. Однако робот в Германии не совершал умышленного нападения на рабочего. Согласно первым отчетам, причина трагедии заключалась в программной ошибке — другими словами, в ошибке человека.

Это ужасающее происшествие — исключительный случай, однако обеспечение корректного использования искусственного интеллекта — первоочередная обязанность представителей новой профессии: экспертов по устойчивости, которые должны постоянно работать над тем, чтобы системы искусственного интеллекта функционировали надлежащим образом как инструменты, призванные обслуживать людей, помогать им выполнять свою работу и облегчать их жизнь. Таким образом эксперты по устойчивости систем искусственного интеллекта помогут развеять страхи перед мрачным будущим, в котором роботы станут разумными и превзойдут человеческое общество (рис. 7).

Рис. 7. Функции экспертов по устойчивости

Очевидно, один из лучших способов добиться того, чтобы сложные роботы и другие системы искусственного интеллекта функционировали так, как было задумано, — изначально правильно проектировать их. Именно в этом случае компаниям понадобятся специалисты по контекстному дизайну. Разрабатывая новую систему, они должны учитывать самые разные факторы, зависящие от контекста, такие как бизнес-среда, задача бизнес-процесса, пользователи, культурные коды и т. д. Важную роль могут играть даже, на первый взгляд, мелкие детали. Когда компании General Motors и Fanuc проектировали нового робота для гибкого автоматизированного производства, призванного работать бок о бок с людьми, возникли трудности с выбором цвета для него. Оранжевый символизировал опасность, а желтый можно было интерпретировать как предупреждение. В конечном счете остановились на цвете лайма, который они назвали «безопасным зеленым».

Безусловно, даже грамотно спроектированные системы могут создавать определенные проблемы, а в некоторых случаях проблема заключается в чересчур хорошем функционировании технологии, что приводит к непреднамеренному нанесению вреда. Много лет назад известный писатель-фантаст Айзек Азимов сформулировал три закона робототехники:

• Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

• Робот должен повиноваться всем приказам человека, кроме тех случаев, когда эти приказы противоречат первому закону.

• Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит первому или второму законам.

Впервые изложенные в рассказе «Хоровод» (1942), эти три закона актуальны до сих пор, однако это только отправная точка. Например, должен ли беспилотный автомобиль, пытаясь защитить своих пассажиров, свернуть в сторону, чтобы не сбить выбежавшего на дорогу ребенка, если при этом он может совершить наезд на пешехода? Именно из-за таких вопросов компаниям, которые проектируют и используют сложные технологии искусственного интеллекта, понадобятся специалисты по безопасности систем искусственного интеллекта. Они должны делать все от них зависящее, чтобы предвидеть непреднамеренные результаты действий системы искусственного интеллекта, а также без промедления устранять последствия любых происшествий.

По итогам недавнего исследования Accenture мы обнаружили, что менее трети компаний демонстрируют высокий уровень доверия к справедливости и контролируемости систем искусственного интеллекта, а также что менее половины компаний испытывают столь же высокое доверие к безопасности этих систем. Исследования показали, что каждый третий опасается искусственного интеллекта, а каждый четвертый убежден, что эта технология нанесет вред обществу. Безусловно, это указывает на фундаментальные проблемы, которые необходимо решить, чтобы и впредь использовать технологии искусственного интеллекта. Именно здесь эксперты по устойчивости систем искусственного интеллекта будут играть ключевую роль.

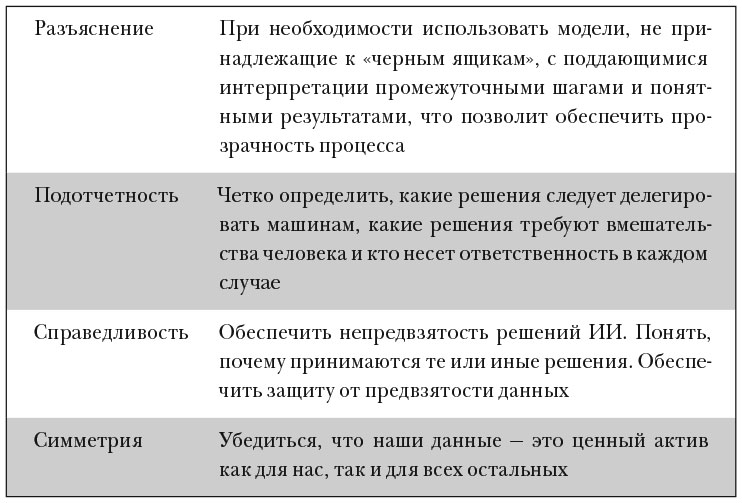

За одну из важнейших функций отвечают менеджеры по соблюдению этических норм. Они будут блюстителями общепринятых норм, человеческих ценностей и моральных принципов. Например, если система искусственного интеллекта по одобрению кредитов проявляет дискриминацию к людям, проживающим в определенных регионах, такой менеджер обязан расследовать и устранить это нарушение этических (а может, даже правовых) норм. Другие случаи предвзятости могут быть не столь явными, как у поискового алгоритма, выдающего изображения только белых женщин, когда кто-то вводит запрос «любящая бабушка». Менеджер по соблюдению этических норм в сотрудничестве с экспертом по алгоритмам должен раскрыть причины такой выдачи, а затем принять надлежащие меры по их устранению (табл. 1).

Таблица 1. Ответственный и устойчивый искусственный интеллект: новые факторы, которые должны учитывать эксперты по устойчивости систем искусственного интеллекта

В будущем возрастет роль искусственного интеллекта в обеспечении того, чтобы передовые системы действовали согласно этическим принципам и моральным нормам человеческого сообщества. Исследователи Школы интерактивных вычислений Технологического института Джорджии Марк Ридл и Брент Харрисон создали прототип системы искусственного интеллекта Quixote, которая способна усваивать этические принципы (например, что нельзя воровать) при чтении прозы. По словам Ридла и Харрисона, эта система умеет обнаружить ценности, анализируя художественные тексты, где люди взаимодействуют друг с другом. Такие произведения описывают культуру и общество, кодируя тем самым «общие знания, социальные протоколы, примеры надлежащего и ненадлежащего поведения, а также стратегии преодоления трудностей». Так, «прочитав» множество историй, система Quixote узнала о том, что стремление к эффективности весьма похвально, за исключением тех случаев, когда это противоречит другим важным факторам. Однако даже при наличии таких инноваций менеджерам по соблюдению этических норм все равно необходимо будет осуществлять мониторинг и обеспечивать надлежащее функционирование сложных систем такого рода.

Система искусственного интеллекта может быть технически совершенной и этичной, но все же оказывать негативное воздействие на организацию. Именно поэтому компаниям понадобятся специалисты по этике автоматизации, в обязанности которых будет входить оценка неэкономического воздействия систем искусственного интеллекта. Один из важных аспектов — общий уровень принятия новых технологий сотрудниками компании. Разумеется, они боятся потерять работу из-за автоматизированной прикладной системы, которая способна функционировать так же хорошо, как человек, если не лучше.

Сильные эмоциональные реакции могут возникать в ответ на внедрение роботизированных систем искусственного интеллекта. Изучая, как мы реагируем на роботов, японский специалист по робототехнике Масахиро Мори обнаружил одну любопытную закономерность. Чем реалистичнее робот, тем выше наша эмоциональная близость и эмпатия, но до определенного момента. Когда робот становится еще более похожим на нас, любые изъяны или отклонения начинают вызывать у нас отторжение. Однако если эти изъяны убрать, робота будет почти не отличить от человека, он снова начнет вызывать у нас положительные эмоции, и со временем уровень эмпатии к такому роботу сравнится с уровнем эмпатии к человеку. Резкое снижение эмпатии, которое Мори обозначил термином «зловещая долина», может стать препятствием на пути успешного взаимодействия человека и машины. Специалисты по этике автоматизации должны знать об этом феномене.

В целом эффективно функционирующие системы искусственного интеллекта целесообразно продвигать, а их варианты дублировать и внедрять в других подразделениях компании. С другой стороны, необходимо ограничить функции систем искусственного интеллекта, работающих неудовлетворительно, а если усовершенствовать их невозможно, то снимать с эксплуатации. Решением этих задач будут заниматься менеджеры по связям с машинами — специалисты с функциями, как у HR, только контролировать они будут не сотрудников, а системы искусственного интеллекта. Эти специалисты будут работать в «отделе по связям с машинами» и регулярно проводить аттестацию всех систем искусственного интеллекта, внедренных в организации. В ходе такой аттестации нужно будет проанализировать множество факторов, в том числе объективную производительность системы, а также опосредованные цели, например стремление следовать корпоративным ценностям, таким как повышение разнообразия и забота об окружающей среде.

Проблема в людях

Вопросы, которые мы подняли в этой главе, лишь начало. Мы рассказали только о нескольких новых профессиях, появляющихся по мере того, как искусственный интеллект охватывает все больше бизнес-процессов. Описанный здесь функционал — малая часть множества новых профессий, которые возникнут в будущем. Действительно, по мере того как организации развиваются вместе со своими командами людей и машин, в них неизбежно будут появляться должности, сходные по функционалу со специалистами по обучению, разъяснению и устойчивости систем искусственного интеллекта. В связи с возникновением новых профессий (которые демонстрируют важность навыков человека в «недостающей середине») руководители должны иначе подходить к потребностям команд людей и машин. (Речь идет о таких аспектах нашей модели MELDS, как мышление и лидерство.) В частности, новые профессии потребуют определенного образования, профессиональной квалификации и опыта. Например, специалистам по обучению эмпатии не обязательно обладать традиционным дипломом о высшем образовании. Людей со средним образованием, от природы наделенных состраданием, можно обучить необходимым навыкам в рамках корпоративных программ профессиональной подготовки. Многие новые профессии могут привести к появлению «безворотничковой» рабочей силы, которая будет постепенно формироваться на основе традиционных «синих воротничков» в области промышленного производства и в других секторах экономики.

С другой стороны, представителям некоторых новых профессий (таких как менеджер по соблюдению этических норм) понадобятся высшее образование и специальные навыки. Например, большинство ведущих компаний уже сейчас адаптируют свои программы профессиональной подготовки к тем специальностям, о которых мы говорили выше, внедряя методы из психологии детского развития.

Главный вывод: компаниям, внедряющим технологии искусственного интеллекта, необходимо переосмыслить свои стратегии формирования базы талантливых специалистов, чтобы более эффективно привлекать, обучать, управлять и удерживать таких сотрудников. Очевидно, внедрение систем искусственного интеллекта потребует новых подходов и процессов, причем не только в области информационных технологий, но и во всех остальных. Мы обсудим соответствующие управленческие вопросы более подробно в главе 7. В конце концов, во многих случаях проблемы зачастую связаны с людьми, а не с технологиями.

Назад: Введение

Дальше: Глава 6. Сверхрезультаты обычных людей