Книга: Математика для гиков

Назад: 8.11. Почему пройти поперек комнаты – это математический подвиг для вас?

Дальше: 3.13. Ваша зависть в социальных сетях имеет математические корни

3.12. Теория информации

Математическое понятие: теория информации

Время от времени находится какой-нибудь математик, который меняет ход истории. Одним из них был Клод Шеннон. В середине ХХ века Шеннон работал в Bell Labs (знаменитый исследовательский отдел AT&T), потом преподавал в Массачусетском технологическом институте. Он также был инженером по электронике и интересовался коммуникациями. Его исследование положило начало теории информации, благодаря которой появились цифровые компьютеры, Интернет и компакт-диски. Он также помог популяризировать термин «бит», что является сокращением от «двоичной цифры». Другими словами, Шеннон сделал будущее возможным.

Одна из идей пришла к Шеннону, когда он учился в магистратуре в Массачусетском технологическом институте. Он понял, что структура коммутационной схемы в аналоговых компьютерах и телефонных сетях напоминала структуру булевой алгебры (см. главу 3.19). В физическом смысле замкнутая цепь могла представлять логическое значение «истина», а открытая цепь – «ложь». В сущности, Шеннон понял, что можно записать работу логики в машине. Вы на самом деле можете решить проблему по логике и математике, используя переключатели и цепи. Это вылилось в магистерскую диссертацию Шеннона в 1938 году под названием «Символьный анализ реле и коммутаторов», теперь эту диссертацию называют самой важной диссертацией ХХ века.

Позднее, во время работы над взломом кодов во время Второй мировой войны, Шеннон заинтересовался дальней связью. Его мысли в конечном итоге переросли в книгу «Математическая теория связи», опубликованную в 1949 году. Шеннон изучал проблемы, присущие отправке сообщений на дальние расстояния по проводам, чем дальше было расстояние, тем сигнал становился все хуже и появлялось больше шума. Но путем преобразования информации в сообщении в основные единицы под названием «биты», состоящие из единиц и нулей, можно с легкостью восстановить сообщение на другом конце провода, так как единицы и нули очень легко отличить. А виды сообщений, которые можно передавать с помощью этих двух чисел, варьируются от видео до фотографий, от аудиофайлов до электронных писем: все, что можно передать через Интернет.

Шеннон также связал биты и понятие энтропии, которое для него указывает на количество информации в каждом конкретном сообщении. Вот его знаменитое уравнение:

H(X)=–∑p(x)logp(x)

Поэтому, когда в следующий раз будете отправлять письмо по электронной почте, подумайте о Клоде.

Шифры

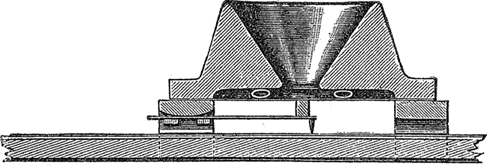

На техническом языке шифр – это четкий метод для кодирования информации. Примером является шифр замены, в котором одни буквы заменяются другими. В некоторых шифрах замены даже используются несколько алфавитов. В начале ХХ века электромеханические шифры, такие, как в немецкой машине «Энигма», означали, что машина, а не человек осуществляли эти замены.

Назад: 8.11. Почему пройти поперек комнаты – это математический подвиг для вас?

Дальше: 3.13. Ваша зависть в социальных сетях имеет математические корни