Книга: Революция в аналитике. Как в эпоху Big Data улучшить ваш бизнес с помощью операционной аналитики

Назад: Часть III Превращаем традиционную аналитику в операционную

Дальше: Глава 8 Аналитическая команда

Глава 7

Аналитика

В этой главе мы сосредоточимся на аналитических концепциях, позволяющих организации превратить аналитику в операционную. Как мы увидим, далеко не все ново под луной в мире операционной аналитики, но возникают и новые уникальные проблемы, которые важно понимать и учитывать.

Не забывайте о том, что превращение традиционной аналитики в операционную происходит эволюционно, поэтому многие уроки и принципы из прошлого, связанные с разработкой аналитических процессов, точно так же применимы и в настоящем, но с некоторыми изменениями. Организации, уже хорошо освоившие использование аналитики и располагающие в штате крепкими командами аналитиков-специалистов, вправе рассчитывать на успех.

Создание операционно-аналитических процессов

Мы дали определение операционной аналитики в первой главе. Здесь же начнем с рассмотрения ряда тем касательно создания и внедрения операционной аналитики. Как вы увидите, она имеет много общего с традиционной пакетной аналитикой, поэтому вам не придется начинать с нуля. Но в то же время это означает, что организации не могут прыгнуть сразу же на уровень операционной аналитики, если у них нет никакого опыта работы с традиционной пакетной аналитикой.

Постоянство аналитического процесса

Когда появились большие данные и в мир аналитики начали приходить люди с разной подготовкой, начались дебаты о том, не потребуется ли для аналитики новый рабочий процесс. Нет, не потребуется. На фундаментальном уровне рабочий процесс является одинаковым для всех типов данных и аналитики. Подобное постоянство замечательно, поскольку избавляет нас от необходимости каждый раз заново изобретать колесо, когда нам нужно применить аналитику новым способом или использовать новые источники данных.

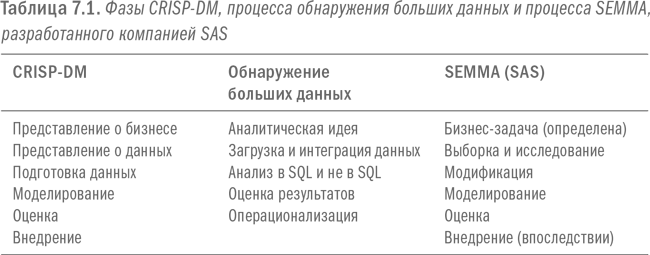

Я был свидетелем споров по поводу того, представляет ли анализ больших данных нечто новое. Помню, как в ходе жарких дебатов утверждал, что в обнаружении больших данных нет ничего нового. Чтобы положить конец спорам, я показал своим оппонентам модель межотраслевого стандартного процесса анализа данных (Cross Industry Standard Process for Data Mining, CRISP‐DM), разработанную в 1990-х гг. Модель CRISP-DM описывает основные шаги в классическом процессе анализа данных. Я поместил схему процесса CRISP-DM рядом с предложенной схемой процесса обнаружения больших данных. Также нарисовал таблицу, где сопоставил отдельные этапы каждого процесса. Один из моих оппонентов, ранее утверждавший, что это были разные процессы, воскликнул: «Постой, Билл, но это практически то же самое!» Наконец-то они поняли мою точку зрения. Да, слегка были изменены термины и семантика, но фундаментально «новый» процесс ничем не отличался от «старого». В таблице 7.1 показано сходство фаз этих двух моделей, тогда как на рис. 7.1 представлена схема типового аналитического рабочего процесса.

Еще одна популярная парадигма – модель SEMMA, разработанная компанией SAS Institute. Аббревиатура SEMMA расшифровывается как sample (отобрать), explore (исследовать), modify (модифицировать), model (моделировать) и assess (оценить). На веб-странице SEMMA говорится: модель предполагает, что бизнес-задача уже определена, а внедрение рассматривается как дополнение завершающей фазы. И снова обратите внимание на то, что эта модель мало чем отличается от модели CRISP-DM и модели обнаружения больших данных, как это можно увидеть в таблице 7.1.

Тот факт, что разные модели аналитических рабочих процессов, разработанные в разные годы и с использованием разных подходов, столь схожи между собой, свидетельствует о том, что, перефразируя слова великого Шекспира, в аналитическом безумии есть свой метод. Переход к аналитике больших данных, операционной аналитике или к следующему феномену будет опираться на знания, которыми уже обладают организация и ее команды.

От пакетной аналитики к операционной

Давайте начнем с рассмотрения сходства и несходства между традиционной пакетной аналитикой и операционной аналитикой. Во-первых, и операционная, и пакетная аналитика требуют значительных усилий по подготовке и проверке качества данных. Например, если требуется оценить риск ухода клиента, вероятность продажи продукта или риск отказа двигателя в течение нескольких следующих минут, то нужно будет получить необходимые данные, проверить их качество и подготовить правильные метрики для поддержки требуемого анализа.

Операционная аналитика сосредоточена на обработке данных и принятии решений в режиме реального времени и, как правило, применяется к конкретному клиенту, продукту или двигателю именно в тот момент, когда это необходимо. Тем самым она отличается от пакетной аналитики, где данные по всем клиентам, продуктам или двигателям анализируются одновременно в виде единого пакета и в произвольное время. Во многих случаях аналитические методы, используемые при операционном вводе данных, идентичны тем, что используются при традиционной пакетной обработке. Разница состоит лишь в том, как выполняются и применяются эти процессы.

Например, те же самые алгоритмы, что использовались с целью прогнозирования следующего лучшего предложения для всех клиентов при пакетном анализе, могут использоваться и с целью прогнозирования следующего лучшего предложения для конкретного клиента, который прямо сейчас просматривает веб-сайт. Разница в том, что процесс генерации предложения для клиента в режиме реального времени опирается на самые свежие данные. Разумеется, в некоторых случаях операционно-аналитические процессы потребуют абсолютно новую аналитику, у которой не существует исторических аналогов. Возьмите, например, процессы, регулирующие угол наклона лопастей ветряных турбин с целью увеличения их мощности в зависимости от окружающих условий, о чем мы говорили в третьей главе.

Операционная аналитика стоит на прочном фундаменте

Вы не можете наладить производство миллионов штук печенья с шоколадной крошкой без рецепта и налаженного производственного процесса. Рецепт можно будет разработать, а процесс наладить путем тестирования на мелких партиях. Аналогичный подход применяется и в операционной аналитике. Сначала нужно создать работающий базовый процесс, а уже затем превращать его в операционный.

Ключевой момент – во многих случаях операционно-аналитический процесс представляет собой просто более интегрированную, сдвинутую к режиму реального времени версию пакетного аналитического процесса. Вот почему, прежде чем внедрять операционную аналитику, организация должна достичь мастерства в применении традиционной аналитики. Это ничем не отличается от ситуации на промышленном производстве, когда сначала изготавливаются формы и прототипы изделия, которое потом будет изготовляться на сборочной линии. Подобно тому как производство новой модели мобильного телефона начинается с создания опытных образцов и тестирования производственного процесса на небольших партиях изделий, точно так же абсолютно необходимо сначала разработать прототип аналитического процесса и протестировать его в небольшом масштабе, прежде чем его автоматизировать. Для того чтобы наладить производство чего угодно, от мобильных телефонов до замороженной пиццы, вы должны пройти ключевые этапы дизайна, производства опытных образцов и утверждения процесса. Вы не сможете запустить массовое производство миллионов штук печенья с шоколадной крошкой, пока у вас не будет проверенного рецепта и отлаженного производственного процесса, которые позволят вам изготовить пробную партию с десяток вкусняшек.

Как говорилось в шестой главе, операционно-аналитические процессы тоже требуют постоянного контроля и регулярной модернизации. Я рекомендую прочитать вам хорошую статью на эту тему – «Одержимость качеством в Western Digital Corporation» Ричарда Хакаторна из компании Bolder Technology. В статье рассматриваются конкретные примеры касательно качества данных, управления, реализации и мониторинга операционной аналитики.

Операционная аналитика – это…

Еще один важный угол зрения, под которым следует рассматривать действия по превращению аналитики в операционную, заключается в том, что операционная аналитика – это… подождите, подождите… просто аналитика! Я уже писал о том, что аналитика больших данных – это просто аналитика. Теперь повторю то же самое: операционная аналитика – это просто аналитика.

Тем самым я вовсе не хочу сказать, что внедрение больших данных или операционной аналитики требует минимальных усилий. То и другое представляет собой довольно трудную задачу и нуждается в новых инструментах, технологиях и навыках. Просто я хочу подчеркнуть, что необходимые действия не являются чем-то абсолютно новым и неизвестным. Скорее, они представляют собой естественное продолжение стремлений организаций и специалистов-аналитиков увеличить количество и разнообразие источников данных и аналитических методов, с тем чтобы усовершенствовать принятие бизнес-решений.

Операционная аналитика – это…

… просто аналитика! Не упускайте из виду сей простой факт.

Если вы сами являетесь специалистом-аналитиком или у вас есть в штате такие классные профессионалы, вам нечего бояться операционной аналитики. Специалисты обеспечивали эволюцию аналитических процессов в прошлом, и точно так же они обеспечат эволюцию этих процессов для выведения их на операционный уровень. Определят бизнес-проблему и требуемые для ее решения источники данных. Затем исследуют эти данные, подготовят их и проанализируют. Включат данные в аналитический процесс, который протестируют, прежде чем масштабируют его на операционном уровне. Маршрут во многом останется тем же, что и в прошлом. В конце концов цель превращения традиционной аналитики в операционную состоит в увеличении числа аналитических процессов для поддержки бизнеса.

Новые аналитические дисциплины

Как говорилось во второй главе, большие данные часто представляют собой особый тип данных с принципиально иной структурой. Новые структуры данных могут потребовать других способов обработки для включения этих данных в аналитический процесс. Соответственно организации придется осваивать новые аналитические дисциплины. В этом разделе мы дадим им определение, расскажем о том, как их можно сочетать и как это сочетание способно создать ценности.

Определение аналитических дисциплин

Современная деловая среда требует все более широкого спектра аналитики. Когда я только начинал заниматься аналитикой, большинство аналитических процессов, используемых крупными компаниями, относилось к одной из двух ключевых дисциплин. Первая – это статистика, включающая в себя что угодно – от дисперсионного и регрессионного анализа до проверки статистической значимости. Вторая – это прогнозирование, включающее в себя классические временные ряды и проекционные способы. Однако в современном мире эти две аналитические дисциплины больше не в состоянии удовлетворить всех потребностей бизнеса, нуждающегося в выходе за пределы статистических и прогностических методов. Давайте рассмотрим несколько новых аналитических дисциплин.

В последнее время все более широкое применение находит моделирование. В частности, особенно популярно моделирование по методу Монте-Карло. В основе его лежит очень простая концепция и, если вы прибегали к пенсионному планированию, то, скорее всего, применяли этот метод. Для того чтобы спрогнозировать пенсионные накопления, необходимо учесть множество допущений, например:

• Какова будет средняя годовая доходность инвестиций?

• Насколько волатильной будет доходность на протяжении рассматриваемого периода времени?

• Каким будет темп инфляции?

При моделировании по методу Монте-Карло исследуется широкий спектр комбинаций допущений по всему диапазону возможных значений. Какие сценарии приведут к хорошим результатам, позволив достичь намеченных финансовых показателей, а какие к плохим? Смоделировав тысячи или даже миллионы сценариев, процесс Монте-Карло обозначает распределение успехов и неудач. В идеале широкий диапазон разумных допущений должен привести к положительному исходу. Если этого не произойдет, то намеченная цель может быть попросту нереалистичной.

Также широкое распространение получает такая дисциплина, как оптимизация. На протяжении многих лет она активно использовалась в аналитике ценообразования, а сегодня сфера ее применения начинает раздвигаться. Оптимизация нацелена на поиск вариантов, которые позволяют наилучшим образом достичь поставленной цели с учетом широкого разнообразия факторов и ограничений. Если моделирование по методу Монте-Карло позволяет исследовать и количественно оценить множество различных вариантов, то цель оптимизации – найти оптимальный вариант. Как правило, оптимизация используется в тех случаях, когда можно управлять факторами, оказывающими значительное влияние на результат. Например, организация может управлять ценами на свою продукцию для достижения оптимальных результатов, а вот в случае пенсионного планирования у человека нет возможности управлять, скажем, уровнем инфляции.

Оптимизация часто опирается на традиционную предсказательную аналитику. Например, какое предложение лучше всего показать клиенту, когда он посещает веб-сайт? Даже при создании списка предложений для электронной рассылки в пакетном режиме оптимизация помогает качественно повысить общий уровень откликов с учетом различных ограничений, скажем, количества предложений и бюджета, выделенного на скидки. Два типичных подхода к оптимизации – это линейное и нелинейное программирование. Информация об этих методах широко доступна, и заинтересованные читатели могут глубже их изучить.

Расширение аналитических компетенций

Классические методы статистики и прогнозирования больше не могут удовлетворять аналитические потребности организаций. Обработка новых типов данных и новые аналитические требования понуждают к овладению многочисленными новыми аналитическими дисциплинами. Будьте готовы к тому, что для этого вам придется расширить наборы используемых инструментов и навыков.

Еще одна тенденция последнего времени – увеличение количества потоковых данных, особенно в связи с развитием датчиков и Интернета вещей. Потоковые данные часто бывают структурированными и, как следует из названия, представляют собой непрерывный, быстрый и крупномасштабный поток. Для их обработки используется, в частности, такая набирающая популярность дисциплина, как обработка сложных событий (CEP). При этом подходе CEP анализирует данные по мере их поступления и часто еще до того, как они загружаются в хранилище. Идея состоит в том, чтобы анализировать данные во время их перемещения из источника к месту хранения и таким образом максимально сократить время на принятие решений. Аналитика в CEP может включать в себя большинство других аналитических дисциплин. Отличие CEP в том, что аналитика здесь применяется максимально быстро и за пределами традиционных окружений. По своей природе CEP предназначена для применения в операционных целях.

Другие аналитические дисциплины, получающие широкое распространение, включают в себя:

• Распознавание лиц и другие виды анализа изображений, находящие применение во многих областях, от социальных сетей до сферы безопасности.

• Машинное обучение, чьи алгоритмы становятся все более усложненными. Такие компании, как Google, скрытно приобретают и используют технологии машинного обучения.

• Анализ графов. Хотя теории, лежащие в основе анализа графов, были разработаны много лет назад, но только после развития социальных сетей и появления всеобщего стремления проверять отношения между людьми или организациями этот вид анализа стал обыденным.

• Геопространственный анализ, который до недавнего времени использовался только крупными логистическими или картографическими компаниями. Сегодня для пользователей смартфонов геопространственный анализ стал повседневной реальностью.

• Текстовая аналитика, испытавшая взрывной рост, когда стало возможным собирать все тексты организации, а также превращать речи в текст. Большинство крупных организаций уже применяют текстовую аналитику.

Чтобы двигаться вперед, придется добавлять в существующий набор все новые аналитические дисциплины. Приготовьтесь развивать навыки обращения с этими дисциплинами у себя в организации и применять для их поддержки специализированные инструменты.

Преимущества мультидисциплинарной аналитики

Как организация может сочетать различные аналитические дисциплины и какое преимущество это создаст? Прежде всего, давайте назовем подход с использованием разных аналитических дисциплин в рамках одного процесса «мультидисциплинарной аналитикой». Далее, чтобы проиллюстрировать путь к успеху, давайте рассмотрим историческую параллель с хранением данных. Хранилища возникли в результате того, что организации собирали все больше данных, но сам сбор не был скоординирован. Как правило, в разных частях организации имелись свои платформы управления данными, а также повсюду возникали киоски данных, сосредоточенные на нуждах отделов. Если кто-то хотел осуществить анализ с использованием данных от разных частей организации, то ему приходилось выполнять невероятно трудный и зачастую в ручном режиме процесс извлечения и объединения данных из всех этих разрозненных систем.

Концепция корпоративного хранилища данных (EDW) достаточно проста. EDW стремится, по мере возможности, собрать все необходимые для анализа данные на одной платформе. Любой пользователь может увидеть данные в том же виде, в каком они хранились в традиционном киоске данных, но при этом также получить доступ к данным из других киосков. Например, финансовые данные можно легко скомбинировать с данными по продажам. На протяжении многих лет концепция EDW генерировала огромную рыночную ценность, и сегодня такие хранилища есть фактически у любой крупной организации.

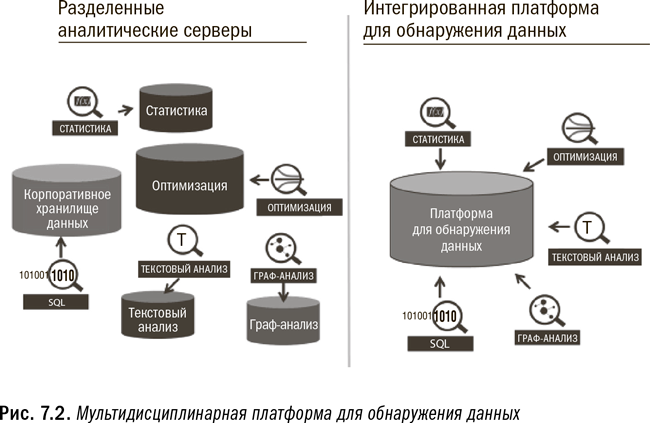

Каким образом оправдание хранения данных связано с мультидисциплинарной аналитикой? Актуальная проблема аналитики состоит в том, что даже при наличии централизованного EDW каждая аналитическая дисциплина часто имеет собственное внешнее окружение. Организация размещает статистическое ПО на одном сервере, ПО текстового анализа на другом, ПО анализа графов на третьем, комплект программ для оптимизации на четвертом и т. д. При таком изобилии аналитических инструментов, когда организация хочет сочетать разные аналитические дисциплины, она сталкивается с трудностями, аналогичными тем, что существовали еще до хранения данных. Поэтому не имеет смысла иметь все эти разные наборы инструментов, предназначенные для поддержки разных аналитических дисциплин в разных местах с ограниченной интеграцией, для чего потребуется каждый раз перемещать огромные объемы данных.

Сочетайте, сопоставляйте и исследуйте

Наличие возможности сочетать различные аналитические дисциплины дает огромное преимущество. Подобно тому как источники данных набирают мощность при объединении с другими данными, так и сочетание различных аналитических дисциплин придаст дополнительную силу. Платформа для обнаружения данных обеспечивает такую возможность.

Решение заключается в создании окружения, которое позволяет удовлетворять все аналитические потребности в одном месте. Платформа для обнаружения данных, о которой мы рассказали в пятой главе, идеально подходит для этой цели, как это видно на рис. 7.2. В идеале платформа должна иметь доступ ко всем хранилищам данных и позволять проведение анализа в рамках любой аналитической дисциплины. Некоторые специалисты будут по-прежнему фокусироваться на одной дисциплине, точно так же как некоторые пользователи хранилища данных продолжат работать с данными только своего отдела. Однако сейчас стало возможным изучить, как различные аналитические дисциплины могут взаимодействовать между собой и усиливать друг друга.

Мультидисциплинарная аналитика в действии

Давайте рассмотрим несколько наглядных примеров того, как сочетание различных аналитических дисциплин может принести гораздо более значимые результаты, чем применение каждой дисциплины в отдельности.

Когда текстовый анализ применяется сам по себе, он часто используется для сиюминутных и краткосрочных целей. Организации исследуют посты в социальных сетях и оценивают их тональность по шкале от позитивной до негативной. Также они определяют, о каких продуктах идет речь. Во многих случаях эти результаты включаются в сводные отчеты по трендам, которые показывают, как изменяется общая тональность и популярность отдельных продуктов. Часто на этом и заканчивается применение текстовой аналитики и данных социальных сетей.

Однако текстовая аналитика может быть использована и в стратегическом плане. Почему бы организации не отслеживать каждый комментарий, сделанный каждым клиентом по поводу ее продуктов? Например, несколько лет назад клиент мог сказать о том, что он любит красный цвет, а месяц назад заявить, что не любит зеленый. Наличие постоянного хранилища подобных фактов об интересах и предпочтениях клиентов может иметь огромную ценность. Это позволит выделить такие метрики, как предпочитаемые цвета, продукты, выбор продуктов и т. д., чтобы составить уточненный профиль каждого клиента. Например, метрика «не любит зеленый цвет» может быть включена в модели по определению следующего лучшего предложения. Таким образом, результаты текстовой аналитики можно использовать для улучшения совершенно не связанного с ней статистического аналитического процесса. Если же эти две аналитические дисциплины не сочетать, то модель по определению следующего лучшего предложения не будет учитывать цветовые предпочтения и окажется менее действенной.

Второй пример относится к анализу социальных сетей или к анализу графов. Знание связей между клиентами способно помочь в прогнозировании продаж новых продуктов. В добавление к проецированию на перспективу начальных продаж нового продукта анализ графов позволяет определить, кто его покупает и каким влиянием обладают эти люди. Благодаря исследованию количества и качества связей ранних последователей можно уточнить прогнозы дальнейших продаж. Например, если пользующиеся большим влиянием люди первыми попробуют новый продукт и положительно его оценят, они с большой вероятностью побудят других тоже его попробовать. Если же первыми покупателями становятся люди с небольшим кругом влияния, то признание продукта замедлится. Таким образом, дополнительная информация, поставляемая анализом графов, может быть использована для уточнения прогнозов продаж. Кроме того, повысится эффективность маркетинга, поскольку при определении людей с наибольшим кругом влияния им можно будет делать целенаправленные предложения.

Третий пример связан с добавлением симуляции к обычному моделированию. С помощью симуляции по методу Монте-Карло проверяется надежность результатов прогнозирования. Традиционная прогностическая модель определяет наиболее правдоподобные диапазоны оцениваемых параметров, а также пределы ошибки, что позволяет количественно установить, сколько шума от рекламы присутствует в данных. Симуляция по методу Монте-Карло может быть использована для исследования прогнозов посредством варьирования всех параметров в рамках соответствующих пределов ошибки. Это позволяет определить стабильность прогнозов, генерируемых моделью, и снизить риск при одновременном укреплении доверия к результатам.

Наконец, последний пример касается использования алгоритмов CEP для анализа потока сенсорных данных. Чтобы улучшить процессы CEP, можно применить алгоритмы машинного обучения к историческим данным. Ретроспективный взгляд на поток и применение машинного обучения для более точного определения шаблонов, присутствующих в данных, позволят улучшить алгоритмы обработки событий. Например, алгоритм, отыскивающий проблемы с двигателем, можно усилить, чтобы он распознавал ранее пропущенный инициатор проблемы, который был определен благодаря применению метода машинного обучения к анализу исторических данных с целью выявления факторов, ведущих к отказу двигателя.

Существует множество возможных способов сочетания аналитических дисциплин. Хотя вышеприведенные примеры касались только парных комбинаций, но их вполне можно развить и дальше, когда в один процесс включаются несколько различных дисциплин.

Сосредоточение аналитических действий

Когда организация готова приступить к превращению традиционной аналитики в операционную, она должна научиться сосредоточивать свои действия на нужных направлениях. Соблюдение нескольких ключевых правил поможет обеспечить распределение ресурсов в нужном направлении, чтобы не тратить время и деньги на реализацию ошибочных идей, основанных на ложных предположениях.

Задавайте правильные вопросы и делайте обоснованные предположения

Создаваемая аналитикой ценность зависит от того, как определена задача, какие вопросы заданы, как аналитическое решение разработано и как это решение реализуется. При этом выбор вопросов способен оказывать большее влияние на ценность, создаваемую результативным аналитическим процессом, чем детали этого процесса, разработанного для ответа на заданные вопросы.

Это имеет смысл. В конце концов, способен ли оказаться точным и полезным анализ, если решаемая им задача плохо определена или нужные вопросы не заданы? Ведь запросто можно идеально выполнить абсолютно неподходящий и ненужный анализ для решения неправильно поставленного вопроса. Хуже того, задав не тот вопрос, можно не выявить и ошибку. Если же вопрос кажется разумным и анализ ему соответствует, то в адекватности этого вопроса можно больше не сомневаться.

Когда потенциальные миллионы решений будут приниматься автоматически, даже небольшая ошибка при разработке аналитического процесса может привести к серьезным последствиям. Операционная аналитика требует как никогда внимательного подхода к определению анализа и разработке процесса. И по-прежнему необходимо учитывать разнообразные технические и практические факторы. Невозможно позволить себе внедрить полностью автоматизированный операционно-аналитический процесс в требуемом масштабе, если не доверяешь его надежности.

Не обрекайте анализ на неудачу с самого начала

Способ определения задачи, постановки вопросов и разработки анализа может оказать большее влияние на полученные результаты, чем вся нелегкая работа, которая за этим последует. Ничего не стоит разработать анализ, отвечающий на неправильно поставленный вопрос для решения неправильно определенной задачи.

Это подводит нас к необходимости внедрения подхода, который пока еще не стал, но должен стать привычным. В процесс разработки анализа должно входить тестирование сделанных предположений. Для этого можно использовать дисциплину, обычно используемую в инжиниринге, под названием «анализ чувствительности».

Любой аналитический процесс опирается на конкретные предположения. Это могут быть предположения о темпах роста продаж, увеличении на рынке доли конкурента или будущих затратах на сырье. Результат аналитического процесса окажется неправильным, если неточны исходные предположения. Однако по мере того как становятся известны фактические значения, оказывается, что они отличаются от предполагаемых (в лучшем случае ненамного). Важнейший вопрос: если истинные значения в той или иной степени отклоняются от наших предположений, как это влияет на результаты анализа?

Например, сотрудники могут расходиться во мнениях о том, каким будет уровень инфляции – 3, 4 или 5 %. Здесь им на помощь придет анализ чувствительности, который позволяет показать, как изменение темпов инфляции повлияет на результаты анализа. Если независимо от того, чей прогноз окажется точнее, результаты анализа приведут к одному и тому же ответу, тогда сотрудникам не придется приводить свои прогнозы к единому показателю. Достаточно определить вероятный диапазон, скажем от 3 до 5 %, поскольку при любом из этих значений анализ приведет к одинаковому решению.

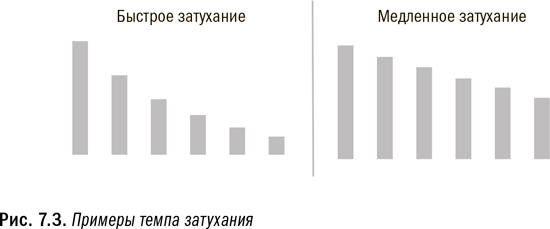

Впервые я столкнулся с такой необходимостью при разработке моделей комплексного маркетинга, которые включали данные телерекламы. Мало того, что последние были предельно обобщены, так нам к тому же нужно было сделать множество предположений в отношении этих данных, чтобы подготовить их для включения в наши модели. Например, каким будет темп затухания впечатлений от рекламы? Темп затухания – очень простая концепция. Телереклама способна повысить продажи. Однако люди действуют под влиянием рекламы, т. е. активно покупают рекламируемый товар в магазине или онлайн, всего в течение нескольких дней. При первых показах телерекламы ее влияние на покупательское поведение максимально, а затем это влияние постепенно снижается. Такое сокращение и называется темпом затухания, оказывающим заметное влияние на результаты. На рис. 7.3 показаны примеры темпа затухания.

В свое время я получил рекомендацию, которой до сих пор следуют многие специалисты-аналитики: если выдаваемые моделью оценки параметров являются статистически значимыми и модель обладает мощной объяснительной силой, значит, предположения насчет темпа затухания верны и модель является работоспособной. Но, следуя такому подходу, я столкнулся с серьезной проблемой.

Однажды я создал хорошую модель с использованием стандартного темпа затухания. Однако мне пришло в голову посмотреть, что будет, если я изменю свои предположения насчет темпа затухания и запущу модель заново. Я был поражен, когда получил по-прежнему статистически значимые оценки параметров, а у модели по-прежнему доставало объяснительной силы. Но при этом новые оценки параметров расходились с предыдущими оценками больше, чем допускали пределы ошибки. Стало понятно, что наличия хорошей модели и статистически значимых параметров было недостаточно для доказательства правильности исходных предположений. И, мало того, мои предположения о темпе затухания влияли на результаты больше, чем сама модель. Мы с моей командой приложили массу усилий, чтобы окончательно определить максимально точные, на наш взгляд, предположения. Тем не менее мне и по сию пору становится не по себе от мысли о том, что предположения способны настолько радикально повлиять на результаты анализа.

Предположения увеличивают риски; оцените риски

При создании аналитического процесса делается много предположений, причем вероятность того, что все они будут абсолютно точными, крайне низка. Полезно оценивать, как изменяются результаты, по мере того как варьируются фактические значения под влиянием предположений в правдоподобном диапазоне. Это позволяет лучше понять сопряженные с анализом риски.

Далеко не всегда все разумные предположения будут приводить к одинаковому ответу. В некоторых ситуациях один набор разумных предположений даст положительный результат, тогда как другой набор – отрицательный. В таких случаях необходимо прийти к согласию относительно заключительного предположения и оценить риски, связанные с возможной ошибкой. Когда разные предположения ведут к разным ответам, разумно использовать для подстраховки наиболее консервативные предположения. Анализ чувствительности для оценки влияния предположений не устраняет риски, а просто позволяет измерить их количественно и лучше их осознать. Хорошим инструментом для такой оценки предположений служит моделирование по методу Монте-Карло.

Делайте ваши ставки!

Как мы увидели во второй главе, хотя затраты на сбор и хранение данных снизились, но по крайней мере столь же быстро растут объемы данных и аналитические потребности организаций. Сегодня существует такое широчайшее разнообразие аналитических возможностей, что порой это приводит в замешательство. Все решения о том, где следует сделать ставки, должны быть основаны на надежном суждении. Причем в отношении больших данных и операционной аналитики оно должно быть не менее надежным, чем в прошлом. Ведь чем больше появляется данных и во все более разнообразных сочетаниях, тем проще пойти по ложному пути. Или же можно наткнуться на ложные корреляции, которые не имеют никакого отношения к реальности.

Например, при построении статистических моделей можно угодить в стандартную ловушку ввиду того, что многие модели устанавливают меру доверия к своим оценкам значений параметров. Общепринятый стандарт требует по крайней мере 99 %-ного уровня доверия к тому, что эффект действительно существует, а не является чисто случайным совпадением. Когда тестируется всего несколько факторов, шансы на успех невелики и, вполне вероятно, что некая абсолютная фальшивка будет признана статистически значимой. Но подумайте о петабайтах сенсорных данных, генерируемых современным самолетом. Возможно, появятся тысячи или даже десятки тысяч метрик, способных коррелировать с такими событиями, как перегрев двигателя. Если при исследовании 20 000 факторов устанавливается уровень доверия в 99 %, то можно ожидать, что 200 совершенно ложных факторов будут признаны статистически значимыми.

Необходимо решить, какие метрики должны быть включены в анализ, чтобы оставить из них только разумные. Но даже после такой фильтрации может остаться множество метрик, которые будут приводить к выявлению ложных эффектов. После построения модели требуется осуществить дополнительный анализ для проверки реальности обнаруженных эффектов. Оценке должен подвергаться весь процесс.

Не спешите выносить приговор

Отличный пример, хорошо иллюстрирующий затронутые в этом разделе темы, связан с компанией Boeing и ее самолетом модели 787. В 2012 г. компания попала в новости из-за проблем с аккумуляторами на 787. Это дорого обошлось ей и в финансовом плане, и с точки зрения ущерба репутации. Во время моего выступления на одной из конференций меня спросили, не считаю ли я, что Boeing облажалась, не сумев исправить проблему с аккумуляторами до выпуска самолета на рынок. Задавший этот вопрос человек считал, что, получив в ходе тестирования все сенсорные данные, компания должна была обнаружить дефект. Я ответил, что не совсем справедливо рассматривать ситуацию под таким углом, поскольку не все так просто. Я предпочитаю считать людей или компании невиновными до тех пор, пока их вина не доказана. Задним числом может казаться, что выявить проблему с аккумуляторами было несложно, но давайте рассмотрим несколько соображений, которые противоречат такой точке зрения.

Во-первых, вполне возможно, что Boeing не собирала таких данных, которые позволили бы выявить конкретную проблему с аккумуляторами. Во-вторых, даже если компания собирала нужные данные во время тестирования, то скорее всего и проанализировала их, но не обнаружила вызывающих тревогу шаблонов. Возможно, проблема возникла только тогда, когда самолет начал эксплуатироваться в реальных условиях. Более того, даже если данные содержали информацию, позволяющую выявить проблему, это вовсе не означает, что компания облажалась. Позвольте мне объяснить, в чем дело.

Не становитесь жертвой суждений задним числом

Когда нужно проанализировать столь много данных по самым разным направлениям, следует, применив здравый смысл, воспользоваться возможностями, способными оказать самое сильное воздействие. Задокументируйте принятие решения с указанием, на чем были сосредоточены усилия, чтобы впоследствии защитить свои действия от суждений задним числом. Найти иголку в стоге сена почти невозможно. Но, когда она обнаружена, ее почти невозможно упустить.

С учетом тех объемов данных, которые генерируются мириадами датчиков на Boeing 787, невозможно исследовать каждую деталь, способную сломаться. На это попросту не хватит времени с точки зрения как рабочей силы, так и вычислительных мощностей. Инженерам и специалистам-аналитикам компании пришлось, исходя из предположений, выбирать, где сосредоточить свои усилия. Безусловно, они изучили области высокого риска. В самолете имеются компоненты, чей отказ может привести к катастрофе, такие как двигатель и шасси. Я уверен, что компания приложила много сил для анализа в этих областях. В то же время не столь страшно, если во время полета перестанет работать кнопка вызова стюардов. Эту поломку легко устранить, и она не несет никакого реального риска для экипажа или пассажиров. Проблема с аккумуляторами находится где-то посередине между этими двумя крайностями. Вполне возможно, что аккумуляторы не были сочтены источником высокого риска, чтобы уделить им пристальное внимание, притом с учетом ограниченности ресурсов и прошлого опыта.

Разумеется, возможно, что Boeing анализировала данные с аккумуляторов, и эти данные позволяли выявить проблему, но компания ее проглядела. Возможно, что Boeing действительно облажалась. Но без дополнительных фактов мы не можем знать об этом наверняка.

Отсюда вытекает урок: по мере того как организация собирает все больше данных и создает все больше аналитических процессов, специалисты-аналитики должны документировать свои процессы принятия решений. Это означает документировать не только то, что анализируется, но и то, что не анализируется и почему не анализируется. Найти иголку в стоге сена будет невозможно, пока кто-нибудь не укажет вам на нее. Но, когда вы узнаете, где находится иголка, то четко ее разглядите. Подобным же образом, когда возникла проблема с аккумуляторами в самолете, было естественным вообразить, что ее следовало выявить заранее. Документирование выбора места для сосредоточения аналитических усилий позволяет смягчить подобную критику задним числом. Проблемы часто не бывают очевидными до тех пор… пока вдруг не станут очевидными просто потому, что они возникли.

Сравнение аналитических подходов

Есть несколько различных способов создания аналитических процессов. Хотя на первый взгляд эти подходы могут казаться похожими, между ними существуют различия, которые важно осознать. Некоторые аналитические подходы часто понимаются неправильно и считаются намного менее логичными и высококлассными, чем они есть на самом деле. В этом разделе мы рассмотрим несколько основных подходов, призванных стать частью действий любой организации по внедрению операционной аналитики.

Обнаружение данных и подтверждающий анализ

В прошлом бо́льшая часть аналитики представляла собой то, что можно назвать «подтверждающим анализом». Он начинается с формулировки конкретной гипотезы или постановки конкретной цели. Далее выполняется анализ, чтобы подтвердить (или нет) гипотезу либо проложить путь к цели. Другими словами, анализ начинается с очень четкого определения направления и поля деятельности. Например, меня могли бы попросить ответить на вопрос, в какой степени информация о продуктах, просмотренных клиентом в сетевом журнале, повышает продвижение моделей, используемых для прогнозирования вероятности покупки. Когда поле деятельности было четко определено, я мог с самого начала уверенно оценить свои трудозатраты и назвать критерии, по которым будет оцениваться успешность моих действий. Это облегчало мою работу в рамках типичных корпоративных процессов обоснования проектов.

Мир больших данных все чаще ориентируется на то, что можно назвать исследовательской аналитикой. Такой анализ начинается не столько с постановки конкретной гипотезы или цели, сколько с попытки найти в данных ценность, которая может оказаться полезной при постановке более широких целей или набора гипотез. Наличие у специалистов-аналитиков лишь немногих заранее сложившихся идей вовсе не означает, что они изначально не имеют представления о том, что хотят узнать в ходе анализа. Это просто означает, что задачи изначально являются менее формализованными, не очень четко определенными и жестко поставленными.

Например, меня могут попросить проверить, можно ли использовать новый источник данных с целью повысить эффективность моделей, применяемых для прогнозирования вероятности покупки. Я волен сам выбирать лучшие метрики, лучшие способы тестирования этих метрик в рамках аналитического процесса и лучшие методики, которые следует использовать. Могу начать с целого ряда идей, но заранее не знаю наверняка, какие из них сработают, и не могу оценить свои трудозатраты и определить критерии успеха, пока не выполню анализ. В силу этих обстоятельств сотрудники поначалу могут испытывать дискомфорт. Между тем исследовательский анализ существует уже достаточно долгое время и всегда играл важную роль для крупных организаций. Сегодня этот тип анализа начинает приобретать все большую актуальность, поэтому на него начинает выделяться больше ресурсов, чем в прошлом. Исследовательский анализ также можно назвать пробным анализом.

Исследование данных не является случайным или бесцельным процессом

Иногда к исследовательскому анализу относятся скептически, считая, что специалисты-аналитики просто играют с данными в попытке найти нечто стоящее. Это не так. Просто исследование данных начинается с постановки более широкой цели и специалистам предоставляется больше времени для достижения этой цели.

По мере того как организации увеличивают использование аналитики и, следовательно, пул талантливых аналитиков и аналитические обрабатывающие мощности, им становится гораздо проще выделять пусть даже небольшую долю ресурсов на исследовательскую аналитику. Если команда аналитиков небольшая, возможно, будет трудно высвободить сотрудника, который будет заниматься конкретно такими исследованиями, поскольку команда едва справляется с потребностями организации в подтверждающей аналитике. Но если команда большая, то будет гораздо легче высвободить время и для исследовательских действий.

Исследовательский анализ начинается с постановки более широкой цели, но при этом на момент начала проекта остается неизвестным наилучший способ ее достижения. Здесь нет четко очерченного плана анализа в отличие от проекта с использованием подтверждающей аналитики. Например, подробный план по созданию нового механизма рекомендаций станет непременной частью подтверждающего анализа. А исследовательский анализ может начаться, когда задается только основное направление, например найти возможные способы улучшения действующего механизма рекомендаций. Специалисты будут экспериментировать, чтобы найти оптимальный вариант улучшения механизма. Команда станет исследовать различные источники данных и методологии, пока не найдет наилучший вариант. В этот момент может быть принят более жесткий план, с тем чтобы запустить в работу подтверждающий анализ.

Чтобы наглядно проиллюстрировать различия между подтверждающим и исследовательским анализом, можно провести параллель с ситуацией в энергетической отрасли. Нефтегазовые компании тратят массу денег на определение мест для бурения скважин. Эта деятельность сходна с исследовательским анализом, поскольку компании изучают широкий спектр нетестированных вариантов, чтобы выбрать из них наиболее подходящие для бурения. После того как находится площадка, обладающая потенциалом, приступают к бурению. Начинается этап с подтверждающего анализа. Компания знает точно, где бурить и что она ищет. В процессе бурения она либо находит нефть, либо нет. Другими словами, гипотеза о том, что в данном месте залегает нефть, либо подтверждается, либо нет.

Исследования и разработки или хакерство?

Люди часто ошибочно воспринимают исследовательский анализ как бездумное хакерство и бесполезное экспериментирование. Такое отношение абсолютно несправедливо, если исследовательский анализ осуществляется надлежащим образом. Исследовательскую аналитику следует рассматривать как один из видов исследований и разработок (НИОКР) с вытекающим отсюда намерением впоследствии монетизировать результаты. Разумеется, чтобы найти способы монетизации (или определить отсутствие таковых), могут потребоваться дополнительные эксперименты.

Крупные сети ресторанов и производители продуктов питания имеют специальные тест-кухни, где они экспериментируют с десятками или сотнями рецептов в поисках интересных новинок, которые можно включить в меню или производимый ассортимент. Сходным образом аналитической команде может потребоваться испытать ряд аналитических процессов, прежде чем она найдет заслуживающий его превращения в операционный.

Например, перед тест-кухней может быть поставлена такая неопределенная задача, как «создать новый рецепт сэндвича с курицей». Повара получают широкую свободу в изучении трендов и вкусов, популярных сегодня на рынке. Например, какие приправы входят в моду? Недавний тому пример – сэндвичи на фигурных булках (брецелях), появившиеся в 2013 г. Эта новинка стала настолько популярной, что многие сети быстрого питания включили брецель-сэндвичи в свое меню. Итак, тест-кухня получила некие общие указания. Хотя повара и понимали, что им нужно создать новый рецепт сэндвича с курицей, но каким именно должен быть окончательный рецепт, в указаниях не сообщалось. После того как повара узнали о том, что в моду вошел брецель, они сосредоточились на поиске рецепта вкусного брецеля и рецепта сэндвича, который приобретет вкус в сочетании с брецелем. Именно так и должен проходить исследовательский анализ, а рассматривать его следует как деятельность с широкой целью в рамках НИОКР.

Организация должна обеспечить в своей корпоративной культуре место для исследовательской аналитики, чтобы она расценивалась не как бесцельное хакерство, а как научное начинание. Такое небольшое изменение привычного образа мыслей может значительно ускорить поиск организацией новой аналитики, способной к превращению в операционную. Постановка более широких, но обоснованных задач позволяет сфокусировать внимание аналитической команды на реальных потребностях бизнеса, а не на любопытных идеях, не способных к воздействию. Специалисты-аналитики могут легко сбиться с пути, следуя интересным, но несущественным трендам, если они будут просто предаваться хакерству, а не начнут официально работать в рамках НИОКР. Каждая исследуемая ими идея должна оцениваться с точки зрения ее полезности для бизнеса. А хакерством они могут заняться в качестве хобби по выходным дням.

Как уже говорилось в шестой главе, даже на этапе НИОКР специалисты должны учитывать те ограничения, с которыми они столкнутся при внедрении процесса в производство. Например, тест-кухня не будет придумывать такой рецепт сэндвича, приготовление которого потребует нового дорогостоящего оборудования – разумеется, если только повара не сумеют доказать, что установка такого оборудования в каждом заведении сети для поддержки свежеиспеченного продукта окупит себя. Аналогичным образом учет ограничений в ходе НИОКР позволит аналитикам избежать путей, непригодных для превращения их в операционные. Например, все знают о знаменитом конкурсе Netflix Prize. Однако многие победившие в нем решения так и не были претворены в жизнь, поскольку прирост точности прогнозов не оправдывал огромных затрат, требуемых для улучшения алгоритма фирмы Netflix.

Укрепление процессов для внедрения в операционном масштабе

Есть аспект в операционной аналитике, с которым трудно смириться профессионалам. Он заключается в том, что при операционализации аналитики часто бывает необходимо отказаться от некоторой точности или сложности аналитических процессов. Операционная аналитика требует смириться с использованием хороших (а не идеальных) данных, с получением хороших (а не идеальных) результатов и с изменением критериев для оценки успеха. Теоретическая точность и продвижение аналитического процесса не так важны, как фактическое влияние генерируемых им решений и рекомендаций. Например, если водители будут игнорировать предлагаемые им оптимальные маршруты, то воздействие аналитических процессов будет нулевым независимо от того, насколько они хороши.

Как об этом говорилось в шестой главе, когда аналитика выполняется в качестве кастомизации или в индивидуальном порядке, процессам может быть присуща известная хрупкость. В такую «ручную работу» вполне можно добавить немного элегантности и усложненности, чтобы сделать анализ подлинно уникальным и максимально ценным, поскольку он будет использоваться в небольших масштабах.

Точно так же вы способны с легкостью украсить свой дом в соответствии с вашими потребностями и вкусами. Декор может включать множество очень красивых и хрупких вещей. Однако вы бы никогда не использовали их для украшения общественных мест, таких как торговый центр или офисное здание. В тех редких случаях, когда ценные и хрупкие вещи выставляются в общественных местах, например музеях, требуются дополнительные меры безопасности, включая толстые органические стекла и поглощающие вибрацию витрины. Подобно тому как необходимо применять разные стандарты оформления интерьера для дома и общественных мест, так же необходимо применять и разные стандарты для аналитических процессов, когда они переводятся из разряда «ручных» в разряд операционных.

Производство любого продукта в количестве миллионов штук за день в промышленном масштабе требует некоторых компромиссов. При разработке дизайна продукта производители вынуждены идти на компромиссы постоянно. Очень изысканный дизайн бокала для вина может сделать его слишком хрупким для частого использования, например, в ресторанах. В таком случае можно частично пожертвовать изысканностью дизайна ради обеспечения большей прочности.

Организации должны сосредоточиться на оптимизации общего воздействия своих операционно-аналитических процессов, а не на достижении изощренности или абсолютной точности каждого отдельного решения в рамках процессов. Иногда, немного пожертвовав изощренностью и точностью, можно превратить нулевое воздействие в очень значительное. От небольшого дополнительного повышения точности будет мало толку, если решение не может быть реализовано в операционном масштабе.

Оптимизируйте совокупное качество решений

В операционной аналитике цель – максимизировать не качество каждого отдельного решения, а совокупное воздействие процесса на все решения. Это может потребовать отказа от некоторой аналитической мощности, чтобы сделать процесс достаточно устойчивым для внедрения его в промышленном масштабе.

Не поймите меня неправильно! Я не ратую за отказ от всяких стандартов. Даже если при разработке продукта делались некоторые уступки, промышленная производственная линия всегда подчинена строжайшим процедурам контроля качества. Когда небольшое повышение точности аналитического процесса достигается за счет удвоения времени на его выполнение, это не сработает. Если применяемый аналитический метод высокочувствителен к выбросам данных, будет слишком рискованно применять его в окружении, где нет возможности осуществлять проверку данных перед их использованием. Остается надеяться, что абсолютно лучшее решение и решение, наиболее пригодное для операционного внедрения, не будут слишком сильно расходиться между собой. Тем не менее необходимо делать между ними различие.

Давайте на минутку обратимся к контрольным процессам на производственных линиях. Производители используют процедуры статистического контроля, выдающие постоянные сводки о работе производственного процесса. Статистический контроль процессов предоставляет информацию о том, находятся ли различные показатели в ожидаемом диапазоне и в каком направлении они изменяются. Когда какой-либо показатель выходит за пределы допустимого диапазона, применяется корректирующие действие. Например, если температура изделий по выходу из печи становится слишком высокой или слишком низкой, производственная линия может быть остановлена с целью регулировки печи.

Процедуры статистического контроля процессов могут применяться и к операционно-аналитическим процессам. Организация способна отслеживать решения, принимаемые аналитическим процессом, а также данные, на основе которых решения принимаются. Принимаются ли решения в тех же пропорциях, что и раньше? Показывают ли вводимые данные то же ожидаемое распределение, что и раньше? Когда один из показателей начинает отклоняться от установленных параметров, кто-то должен вмешаться, остановить процесс и устранить неполадку точно так же, как это происходит на производственных линиях. Для контроля за операционно-аналитическими процессами могут использоваться методы традиционной аналитики.

Успех операционной аналитики зависит не только от мощности и эффективности собственно аналитики, но и от того, как люди и организационные процессы фактически используют рекомендации и следуют решениям. Поведение сотрудников должно измениться под воздействием аналитики, иначе она не принесет искомой отдачи. Вот почему изменение организационной культуры является ключом к успеху операционной аналитики, о чем мы подробнее поговорим в девятой главе.

Уроки прошлого

На протяжении всей книги я делаю акцент на том, что многие уроки прошлого применимы и в мире больших данных и операционной аналитики. Существуют классические аналитические концепции, от которых не следует отказываться, несмотря на шумные призывы к отказу. Давайте рассмотрим несколько областей, где шумиха могла затмить реальность.

Статистические методы по-прежнему актуальны

Сегодня можно наткнуться на мнение, кто классические методы статистики – это устаревшие концепции, предназначенные только для малых данных. Это абсолютно ошибочная точка зрения. Разумеется, аналитика развивается и добавляет все новые аналитические дисциплины, поэтому организации должны расширять свои аналитические компетенции за пределы классических методов статистики. Некоторые аналитические методы и алгоритмы, такие как алгоритмы поиска и обработки естественного языка, не основаны непосредственно на методах классической статистики. Это нормально. Однако подобно тому как добавление нереляционного окружения к реляционному не означает, что потребности в реляционной обработке канули в лету, так и добавление дополнительных аналитических дисциплин к классической статистике не говорит о том, что последняя потеряла свое значение.

Независимо от того, насколько большим является источник данных, ему все равно присущи вариативность и неопределенность. Данные никогда не бывают идеальными, и в изучаемых нами совокупностях данных всегда будет присутствовать естественная вариативность. Сколько бы данных у нас ни имелось, невозможно с идеальной точностью предсказать поведение каждого конкретного человека или поломку каждого конкретного двигателя, поскольку нам всегда будет недоставать некоторой информации и всегда будут присутствовать неучтенные факторы. Статистика позволяет количественно оценить и учесть риски, сопряженные с этими пробелами. Давайте рассмотрим следующий пример.

В последнее время большую популярность приобретает такой нестатистический метод, как пат-анализ (он же анализ троп). Как правило, он используется для идентификации серии действий каждого клиента и соотнесения путей, которыми он следует, с проявлениями его интереса. Эти действия могут включать снятие средств через банкомат, звонки в колл-центр, внесение средств на счет, клики на веб-страницах, твиты и любые другие, прямо или косвенно затрагивающие организацию. В путь могут быть включены десятки возможных действий. На протяжении многих лет пат-анализ применялся к веб-трафику, позволяя определять, как пользователи передвигаются по сайту и какие пути с наибольшей вероятностью ведут к продажам. Сегодня этот аналитический метод начинает выходить за рамки веб-трафика.

Статистика умерла… Да здравствует статистика!

Идея о том, что статистика потеряла свою актуальность, – заблуждение. Тогда как сегодня действительно существует необходимость выходить за рамки только классических статистических методов, сами по себе эти методы остаются крайне важным компонентом операционной аналитики.

Установление ключевых фактов о типичных путях позволяет повысить мощность прогностических моделей благодаря включению в них уникальной информации. Рассмотрим сценарий с четырьмя конкретными взаимодействиями: снятием средств через банкомат (А), звонком в колл-центр (B), визитом в филиал банка (C) и подачей жалобы (D). Свой путь я обозначу как ABCD: сначала снял деньги в банкомате, потом позвонил в колл-центр, далее нанес визит в филиал банка и, наконец, подал жалобу. После идентификации пути каждого клиента можно легко определить, какие из путей являются наиболее типичными и к каким, положительным или отрицательным, исходам относительно интересующих организацию метрик они ведут, например к открытию нового счета или закрытию существующего. Использование статистики может повысить точность пат-анализа и расширить его применение. Создав набор вспомогательных метрик, отражающих ключевые особенности каждого пути, можно более глубоко исследовать, какие аспекты путей влияют на интересующие организацию метрики. Резюме может включать следующие метрики:

• Повышает ли звонок в колл-центр риск ухода клиента в любой ситуации?

• Подача жалобы имеет значение только в том случае, если она является первой или последней в серии действий?

• Такие действия, как визит в филиал и подача жалобы, имеют значение только в сочетании, но не по отдельности?

• Подача жалобы после звонка клиента в колл-центр приобретает большее значение, чем когда предшествует звонку?

• Подача жалобы сразу по трем каналам коммуникации в любом сочетании существенно увеличивает риск ухода клиента?

На эти вопросы можно ответить, если маркировать путь каждого клиента при помощи серии числовых переменных, определяющих наличие или отсутствие ключевых характеристик пути. Например, одна переменная будет иметь значение 1, если путь включает комбинацию визита в филиал и звонка в колл-центр, и 0, если не включает. После создания широкого спектра переменных можно использовать классический корреляционный или регрессионный анализ для определения того, какие характеристики пути в наибольшей степени связаны с интересующей организацию метрикой. В рассматриваемом нами сценарии нестатистическая функция пути используется для поиска новой информации, которая затем может быть проанализирована строгими статистическими методами. Таким образом, статистика усиливает эффективность пат-анализа. Это еще один пример воздействия мультидисциплинарной аналитики, о чем мы уже говорили ранее в данной главе. Статистика живет и процветает.

Не пренебрегайте выборками

Концепция использования выборок в аналитических процессах родилась практически вместе с самой аналитикой. В прошлом необходимость работы с выборками, а не со всей совокупностью данных диктовалась ограниченными возможностями обработки. В последние годы во многих случаях стало возможным собирать и анализировать всю совокупность интересующих нас данных, поэтому начались разговоры о том, что эпоха выборочных исследований подошла к концу.

Давайте начнем с признания того, что есть случаи, когда выборочный метод просто не будет работать. Если вам нужно найти 100 клиентов, обеспечивающих самые большие объемы продаж, это нельзя сделать на основе выборки. Вы должны рассмотреть каждого клиента, чтобы найти 100 лучших. Однако такие задачи, хотя и являются довольно типичными, не превалируют среди аналитических потребностей. Кроме того, существуют случаи, когда модель, даже если она построена на основе выборки, должна быть применена ко всей совокупности данных. Другими словами, когда дело доходит до практического применения модели, вариант с выборками отпадает.

Но давайте обратимся к типичной задаче, когда необходимо установить среднее значение или получить оценки параметров прогностической модели. С точки зрения статистики правильная выборка, которая адекватно отражает всю совокупность и имеет достаточный размер, даст такой же ответ, как и вся совокупность данных. В таких обычных ситуациях практически не будет разницы между ответом, полученным на выборке, и ответом, полученным на всей совокупности. Более высокая стоимость обработки массы дополнительных данных не принесет дополнительных доходов. Даже если модель в конечном итоге будет использована для обработки всех данных, нет смысла создавать модель на основе всей совокупности. Вместо этого необходимо разделить все данные на две части и использовать одну для построения, а другую для последующей валидации модели. Угадайте, что представляют собой наборы данных, предназначенные для построения и проверки модели? Это выборки! Таким образом, использования выборок данных во многих случаях попросту нельзя избежать.

Некоторые специалисты с пеной у рта утверждают, что в тех случаях, когда можно обойтись без выборки, нужно обходиться без нее. Другие считают, что использование более чем минимальной выборки – это пустая трата времени и ресурсов. Лично моя позиция такова: если некто выполняет для меня проект и хочет использовать выборку, я соглашаюсь при условии, что выборка является правильной и достаточного размера. Если же мне предлагают использовать всю совокупность данных, я соглашаюсь и на это при условии, что привлечение дополнительных ресурсов окажется незначительным. Я уверен, что получу такие же результаты, поэтому меня не беспокоит, какой именно путь будет избран. При разработке аналитического процесса существует масса спорных вопросов, поэтому не тратьте время на споры о том, использовать выборку или нет.

Не переусложняйте анализ

Впервые столкнувшись с этой проблемой, я был поражен: оказывается, чересчур изощренная аналитика иногда дает худший результат, чем простая. Это может быть верно даже в тех случаях, когда чисто теоретически более сложный метод должен работать лучше. Убежден, причина в том, что данные всегда содержат некоторую неопределенность, зачастую являются разреженными и никогда не бывают абсолютно полными. Когда аналитика усложняется, возникает риск увеличения в данных ошибок и неопределенностей наряду со снижением контроля и ухудшением их расчета. Вдобавок можно перестараться с настройкой модели, т. е. настолько ее усложнить, что она начнет отражать случайные вариации, присутствующие в конкретном наборе данных, на котором модель создавалась, а не реально существующие эффекты. Переусложненная настройка становится очевидной, когда модель плохо работает при применении к проверочной выборке.

Несколько лет назад моя команда разрабатывала модели прогнозирования продаж на уровне отдельных магазинов для крупного ретейлера. Анализ должен был охватывать сотни миллионов комбинаций магазин/товар. Многие виды товаров продавались часто и стабильно, что соответствовало предположениям, на которые опираются широко используемые алгоритмы для такого типа прогнозов. Однако также было много товаров, что не вписывались в стандартные шаблоны продаж. Клиент нанял мою команду, чтобы разработать индивидуальные решения, применимые к таким исключениям. Однако, с учетом масштабов организации, исключения все равно составляли миллионы комбинаций магазин/товар.

Не слишком изощряйтесь!

При создании аналитических процессов в операционном масштабе упрощенные решения могут оказаться лучше причудливых. Операционная аналитика часто работает с данными низкого качества, которые могут быть разреженными и неполными. Чрезмерная изощренность модели может привести к нарастанию в данных проблем, вместо того чтобы контролировать их.

Мы с самого начала знали, что клиент нанял еще одну консалтинговую фирму для реализации того же проекта и что команда, предложившая лучшее решение, будет выбрана для дальнейшей работы. Поскольку другая фирма бросила на проект больше людей, чем наша, победить за счет грубой силы мы не могли. У меня был опыт сотрудничества с этой фирмой в прошлом, и я знал, что ее сотрудники любят использовать наборы сложных алгоритмов для повышения точности прогностических моделей. Однако в этом конкретном случае существовала вероятность того, что такой подход не сработает в требуемом масштабе. Я попросил свою команду начать с простых алгоритмов и постепенно увеличивать их сложность, пока не будет достигнут такой порог, когда начнет страдать их масштабируемость.

Когда проект только начался, я предположил, что другая команда превзойдет нас в абсолютной прогностической точности, однако для масштабирования разработанного ею решения потребуются настолько значительные усилия, что это будет признано нецелесообразным. В то же время наши пусть и менее точные модели должны были лучше работать на практике. Я был приятно удивлен, когда оказалось, что наши модели оказались и более точными. Учитывая неполную и разреженную природу данных, изощренные многоступенчатые алгоритмы усиливали помехи, вместо того чтобы их контролировать. Моя команда думала, что мы отказываемся частично от аналитической мощности ради операционной масштабируемости (об этой концепции уже несколько раз говорилось в книге). Однако в итоге вышло так, что в данном случае простой подход сработал лучше и нам не пришлось ничем жертвовать. Вот почему не следует думать, что всегда лучше делать выбор в пользу изощренности. Пробуйте и простые варианты.

Операционная аналитика должна обеспечивать решения

В свете нашего разговора об аналитике легко впасть в заблуждение и решить, что сотрудников среднего звена в организациях интересует аналитика. Она их не интересует! Большинство сотрудников интересует возможность решения тех проблем, которые у них есть. Если аналитика может предложить такое решение, они ее принимают, но сама по себе она им неинтересна. Запомните: их интересует не аналитика, а решение проблемы!

Разумеется, во многих случаях мои заказчики проектов в определенной степени интересуются аналитикой. Например, сотрудники, отвечающие за базу маркетинговых данных, охотно обсуждают со мной аналитические тонкости и решения. Руководители подобных отделов понимают и приветствуют аналитику и, кроме того, часто имеют подготовку в этой области. Что же касается операционной аналитики, то многих моих клиентов заботит только решение проблемы. Это может быть снижение уровня мошенничества, повышение эффективности в цепочке поставок или сокращение затрат на техническое обслуживание, но за пределами воздействия на проблему аналитика их не интересует. Более того, основными пользователями операционной аналитики обычно выступают рядовые сотрудники, которые не имеют необходимого образования для понимания аналитики. Но они должны иметь возможность использовать аналитику, даже если не разбираются в ее деталях.

Вот почему я рекомендую делать акцент на решении проблемы. Покажите, что процесс работает, но не сосредоточивайтесь на самой аналитике при демонстрации ее результатов. Если ваши клиенты или непосредственные пользователи процессов не понимают нюансов и сложностей, лежащих в основе аналитических процессов, нет смысла перегружать их подробностями. Иначе они могут вообще отказаться от внедрения аналитических процессов. Просто продемонстрируйте, что процесс работает, опишите все преимущества и на этом остановитесь – если только вас не попросят о дополнительной информации.

Обеспечьте решения, а не лекции по теории аналитики

Многие заказчики и пользователи операционной аналитики не понимают аналитики или не испытывают к ней интереса. Их заботит только возможность решения проблемы. Убедите их в том, что аналитика поможет решить их проблему, но не углубляйтесь в технические подробности. Если же людей перегрузить информацией, они могут вообще отказаться от выполнения предложенного им решения.

Многие из нас не желают вникать в детали непонятного нам явления. Например, большинство людей не хотят вникать в то, как работает двигатель автомобиля и почему после нажатия на педаль газа топливо подается в карбюратор. Обычно человек просто хочет знать, что, если он нажмет на педаль газа, автомобиль поедет вперед. С операционной аналитикой дела обстоят точно так же, когда ее пользователями становятся люди, не желающие вникать в принципы ее работы.

Операционная аналитика просто должна быть частью предлагаемого вами решения проблемы. Если вы продемонстрируете, что найденное решение приносит нужные результаты, то уже осчастливите заказчиков и пользователей. Им не понадобится вникать в детали. А будут ли конечные пользователи полностью разбираться в стоящей за решением аналитике или принимать ее, это действительно не важно. Если вы помните, в первой главе мы рассматривали пример с логистической компанией, которая решила уменьшить ежедневный километраж для своих водителей службы доставки. Многие водители с пренебрежением отнеслись к компьютерным рекомендациям, поскольку оказалось, что при более вдумчивом подходе они смогли найти способы сократить километраж еще больше и превзойти компьютерную программу. Таким образом, рекомендации бросили вызов водителям – и заставили их изменить свое поведение. Даже если водители не поняли, что именно аналитика инициировала изменения, главное, что изменения произошли.

Подведем итоги

Наиболее важные положения этой главы:

• Операционная аналитика должна опираться на прочный фундамент пакетной аналитики. По-прежнему применим и традиционный аналитический процесс.

• Организация должна иметь возможность применять и сочетать различные аналитические дисциплины, чтобы, помогая друг другу, они позволяли улучшать результаты.

• Платформа для обнаружения данных – лучшее место для применения к проблеме мультидисциплинарного подхода.

• Постановка правильных вопросов в начале построения аналитического процесса сильнее воздействует на результаты, чем вся последующая работа.

• Если фактические значения могут отличаться от исходных предположений, примените анализ чувствительности для оценки потенциального воздействия такого расхождения на результаты.

• Невозможно проанализировать все и вся. Однако если упускается что-то важное, критика задним числом неизбежна. Всегда документируйте процесс принятия решений с указанием того, почему были выбраны одни пути для анализа и не выбраны другие.

• Исследовательский анализ направлен на поиск ответа на более общие вопросы в условиях широкой свободы действий, тогда как подтверждающий анализ с самого начала носит конкретный и жестко заданный характер.

• Аналогично тому, как тест-кухни ищут новые рецепты, организации должны использовать аналитические НИОКР для поиска новых аналитических процессов. Эти усилия должны рассматриваться не как бездумное хакерство, а как продуманное размещение ставок.

• Выведение аналитики на операционный уровень иногда требует частичного отказа от аналитической мощности в обмен на требуемую масштабируемость. Необходимо оптимизировать не каждое отдельное решение, а влияние процесса на все решения.

• Методы классической статистики, включая выборки, по-прежнему сохраняют свою актуальность. Россказни о том, что они устарели, будут опровергнуты.

• Изощренные решения могут усиливать, а не контролировать проблемы с данными, особенно когда они применяются к низкокачественным – разреженным и неполным – данным. В действительности простые решения способны работать лучше, одновременно обеспечивая необходимую масштабируемость.

• Заказчики и пользователи операционной аналитики часто не разбираются в аналитике и не интересуются ею. Главное для них – получить решение проблемы. Вдаваясь в технические подробности, когда вас об этом не просят, вы рискуете отпугнуть людей от аналитики.

Назад: Часть III Превращаем традиционную аналитику в операционную

Дальше: Глава 8 Аналитическая команда